Введение………………………………………………………………………….2

1 Поисковые машины: состав, функции, принцип работы

1.1 Состав поисковых систем………………………………….………………3

1.2 Особенности поисковых машин…………………………………………..4

1.3 Принципы работы поисковых систем……………………………………..4

2 Обзор функционирования поисковых систем

2.1 Зарубежные поисковые системы: состав и принципы работы…………12

2.2 Русскоязычные поисковые системы: состав и принципы работы….…..14

Вывод………………………………………………………………..……………16

Список используемой литературы…………………………………..………….17

Введение

Поисковые системы уже давно стали неотъемлемой частью российского Интернета.В силу того, что они, хотя и различными средствами, самостоятельно обеспечивают все этапы обработки информации от ее получения с узлов-первоисточников до предоставления пользователю возможности поиска, их часто называют автономными поисковыми системами .

Поисковые системы сейчас – это огромные и сложные механизмы, представляющие собой не только инструмент поиска информации, но и заманчивые сферы для бизнеса.Эти системы могут различаться по принципу отбора информации, который в той или иной степени присутствует и в алгоритме сканирующей программы автоматического индекса, и в регламенте поведения сотрудников каталога, отвечающих за регистрацию. Как правило, сравниваются два основных показателя:

Пространственный масштаб, в котором работает ИПС,

И ее специализация.

Большинство пользователей поисковых систем никогда не задумывались (либо задумывались, но не нашли ответа) о принципе работы поисковых систем, о схеме обработки запросов пользователей, о том, из чего эти системы состоят и как функционируют… Поисковые системы можно сравнить со справочной службой, агенты которой обходят предприятия, собирая информацию в базу данных. При обращении в службу информация выдается из этой базы. Данные в базе устаревают, поэтому агенты их периодически обновляют. Некоторые предприятия сами присылают данные о себе, и к ним агентам приезжать не приходится. Иными словами, справочная служба имеет две функции: создание и постоянное обновление данных в базе и поиск информации в базе по запросу клиента.

1 Поисковые машины: состав, функции, принцип работы

1.1 Состав поисковых систем

Поисковая система - это программно-аппаратный комплекс, предназначенный для осуществления поиска в сети Интернет и реагирующий на запрос пользователя, задаваемый в виде текстовой фразы (поискового запроса), выдачей списка ссылок на источники информации, в порядке релевантности (в соответствии запросу). Наиболее крупные международные поисковые системы: «Google», «Yahoo», «MSN». В русском Интернете это – «Яндекс», «Рамблер», «Апорт».

Аналогично, поисковая машина состоит из двух частей: так называемого робота (или паука), который обходит серверы Сети и формирует базу данных поискового механизма.

База робота в основном формируется им самим (робот сам находит ссылки на новые ресурсы) и в гораздо меньшей степени - владельцами ресурсов, которые регистрируют свои сайты в поисковой машине. Помимо робота (сетевого агента, паука, червяка), формирующего базу данных, существует программа, определяющая рейтинг найденных ссылок.

Принцип работы поисковой машины сводится к тому, что она опрашивает свой внутренний каталог (базу данных) по ключевым словам, которые пользователь указывает в поле запроса, и выдает список ссылок, ранжированный по релевантности.

Следует отметить, что, отрабатывая конкретный запрос пользователя, поисковая система оперирует именно внутренними ресурсами (а не пускается в путешествие по Сети, как часто полагают неискушенные пользователи), а внутренние ресурсы, естественно, ограниченны. Несмотря на то что база данных поисковой машины постоянно обновляется, поисковая машина не может проиндексировать все Web-документы: их число слишком велико. Поэтому всегда существует вероятность, что искомый ресурс просто неизвестен конкретной поисковой системе.

1.2 Особенности поисковых систем

В работе поисковый процесс представлен четырьмя стадиями: формулировка (происходит до начала поиска); действие (начинающийся поиск); обзор результатов (результат, который пользователь видит после поиска); и усовершенствование (после обзора результатов и перед возвращением к поиску с иной формулировкой той же потребности). Более удобная нелинейная схема поиска информации состоит из следующих этапов:

Фиксация информационной потребности на естественном языке;

Выбор нужных поисковых сервисов сети и точная формализация записи информационной потребности на конкретных информационно-поисковых языках (ИПЯ);

Выполнение созданных запросов;

Предварительная обработка и выборка полученных списков ссылок на документы;

Обращение по выбранным адресам за искомыми документами;

Предварительный просмотр содержимого найденных документов;

Сохранение релевантных документов для последующего изучения;

Извлечение из релевантных документов ссылок для расширения запроса;

Изучение всего массива сохраненных документов;

Если информационная потребность не полностью удовлетворена, то возврат к первому этапу.

1.3 Принципы работы поисковых систем

Задача любой поисковой системы – доставлять людям ту информацию, которую они ищут. Научить людей делать “правильные” запросы, т.е. запросы, соответствующие принципам работы поисковых систем невозможно. Поэтому разработчики создают такие алгоритмы и принципы работы поисковых систем, которые бы позволяли находить пользователям именно ту информацию, которую они ищут. Это означает, поисковая система должна “думать” также как думает пользователь при поиске информации.

Поисковые системы в большинстве своем работает по принципу предварительного индексирования. По такому же принципу работают база данных большинства поисковых систем.

Есть и другой принцип построения. Прямой поиск. Он заключается в том, что вы в поиске ключевого слова перелистываете книгу страницу за страницей. Конечно, этот способ гораздо мене эффективен.

В варианте с инвертированным индексом поисковые системы сталкиваются с проблемой величины файлов. Как правило, они значительно велики. Эту проблему обычно решают двумя методами. Первый заключается в том, что из файлов удаляется все лишнее, а остается лишь то, что действительно нужно для поиска. Второй метод заключается в том, что для каждой позиции запоминается не абсолютный адрес, а относительный т.е. разница адресов между текущей и предыдущей позициями.

Таким образом, два главных процесса, выполняемых поисковой системой – это индексирование сайтов, страниц и поиск. В общем, процесс индексирования для поисковиков проблем не вызывает. Проблемой является обработка миллиона запросов в сутки. Это связано с большими объемами информации, которая подвергается обработке больших компьютерных комплексов. Главный фактор, определяющий количество участвующих в поиске серверов, - поисковая нагрузка. Это объясняет некоторые странности возникающие при поиске информации.

Поисковые системы состоят из пяти отдельных программных компонент:

spider (паук): браузероподобная программа, которая скачивает веб-страницы.

crawler: «путешествующий» паук, который автоматически идет по всем ссылкам, найденным на странице.

indexer (индексатор): «слепая» программа, которая анализирует веб-страницы, скаченные пауками.

the database (база данных): хранилище скаченных и обработанных страниц.

search engine results engine (система выдачи результатов): извлекает результаты поиска из базы данных.

Spider: Паук – это программа, которая скачивает веб-страницы. Он работает точно как ваш браузер, когда вы соединяетесь с веб-сайтом и загружаете страницу. Паук не имеет никаких визуальных компонент. То же действие (скачивание) вы можете наблюдать, когда просматриваете некоторую страницу и когда выбираете «просмотр HTML-кода» в своем браузере.

Crawler: Как и паук скачивает страницы, он может «раздеть» страницу и найти все ссылки. Это его задача – определять, куда дальше должен идти паук, основываясь на ссылках или исходя из заранее заданного списка адресов.

Indexer: Индексатор разбирает страницу на различные ее части и анализирует их. Элементы типа заголовков страниц, заголовков, ссылок, текста, структурных элементов, элементов BOLD, ITALIC и других стилевых частей страницы вычленяются и анализируются.

Database: База данных – это хранилище всех данных, которые поисковая система скачивает и анализирует. Это часто требует огромных ресурсов.

Search Engine Results: Система выдачи результатов занимается ранжированием страниц. Она решает, какие страницы удовлетворяют запросу пользователя, и в каком порядке они должны быть отсортированы. Это происходит согласно алгоритмам ранжирования поисковой системы. Эта информация является наиболее ценной и интересной для нас – именно с этим компонентом поисковой системы взаимодействует оптимизатор, пытаясь улучшить позиции сайта в выдаче, поэтому в дальнейшем мы подробно рассмотрим все факторы, влияющие на ранжирование результатов.

Работа поискового указателя происходит в три этапа, из которых два первых являются подготовительными и незаметны для пользователя. Сначала поисковый указатель собирает информацию из World Wide Web . Для этого используют специальные программы, аналогичные браузеры. Они способны скопировать заданную Web-страницу на сервер поискового указателя, просмотреть ее, найти все гипетэссылки, которые на ней имеютте ресурсы, которые найдены там, снова разыскать имеющиеся в них гиперссылки и т. д. Подобные программы называют червяками, пауками, гусеницами, краулерами, спайдерами и другими подобными именами. Каждый поисковый указатель эксплуатирует для этой цели свою уникальную программу, которую нередко сам и разрабатывает. Многие современные поисковые системы родились из экспериментальных проектов, связанных с разработкой и внедрением автоматических программ, занимающихся мониторингом Сети. Теоретически, при удачном входе спайдер способен прочесать все Web-пространство за одно погружение, но на это надо очень много времени, а ему еще необходимо периодически возвращаться к ранее посещенным ресурсам, чтобы контролировать происходящие там изменения и выявлять «мертвые» ссылки, т. е. потерявшие актуальность.

Поиск информации в Интернете -- одна из наиболее востребованных операций в Интернете. Посетителям Интернета часто приходится искать документы по какой-либо тематике. Если у вас есть точный адрес документа в Интернете, то в этом случае проблем с поиском не возникает: в браузере в адресной строке можно набрать известный адрес ресурса, и при удачном соединении браузер выведет на экран нужную страницу.

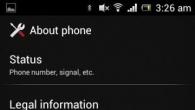

Если точного адреса документа нет, то можно воспользоваться услугами поисковой машины. Поисковая машина? это «специализированный сервер в Интернете, который предлагает разнообразные средства поиска документов» . Пример поискового сервера -- сервер Рамблер (Rambler.ru), расположенный по адресу http://rambler.ru. Вид головной страницы сервера приведен на рисунке.

Рис. 1.

Поисковые серверы обычно составляют собственные каталоги ресурсов Интернета. Каталоги поисковых серверов регулярно пополняются информацией о создаваемых в сети ресурсах, которая поступает от поисковых роботов. Поисковые роботы или пауки -- это специальные сетевые программы, которые обращаются к доступным на текущий момент серверам Интернета, проводят анализ документов и пополняют таблицы своей поисковой машины. Работа по поиску и систематизации ресурсов поисковые роботы выполняют в фоновом режиме круглосуточно.

Еще один источник поступления на поисковые серверы информации о существующих сайтах -- явная регистрация ресурсов владельцами web-страниц. На сервере имеются формы, которые заполняют владельцы ресурсов. В форме задается адрес ресурса, краткая характеристика, ключевые слова, целевая аудитория и пр. Эта информация анализируется и добавляется в каталоги сервера автоматически специальными программами или «вручную» экспертами -- специалистами, следящими за формированием каталогов ресурсов.

Понимание механизмов поиска информации в Интернете позволяет разработчикам web-страниц готовить свои документы так, чтобы они могли быть в дальнейшем найдены поисковыми машинами и размещены в соответствующих разделах каталога ресурсов.

Поиск по ключевым словам в Интернет

Один из популярных способов поиска документов в сети WWW -- поиск по ключевым словам. При задании ключевых слов в поисковой форме поисковая машина будет искать документы, содержащие заданные ключевые слова. Разумеется, для выполнения запроса поисковая машина не станет исследовать содержание тысяч работающих в Интернете компьютеров -- результат такого поиска вам пришлось бы ждать не один день. Поиск ведется среди тех ресурсов (каталогов, таблиц) поисковой машины, которые были ранее собраны и систематизированы с помощью роботов и экспертов.

Поскольку объем ресурсов сети становится поистине безграничным, то по запросу на поиск документа по ключевому слову поисковая машина может найти несколько тысяч документов, содержащих указанное ключевое слово. Понятно, что в таком количестве документов трудно найти тот, который лучше всего соответствует заданной теме. Однако поисковые машины обычно дают возможность сформулировать более детальный запрос.

Запрос может иметь сложную форму и составляться с помощью ключевых слов и логических функций И (AND), ИЛИ (OR), отрицания (NOT) . Или же запрос на поиск может формироваться с помощью специальных символов, позволяющих задать (или отменить) словоформы ключевых слов. Такие механизмы помогают более точно сформулировать требования для отбора документов. Каждая поисковая машина имеет справочную систему, которая поможет посетителю составить поисковый запрос.

Врач-аспирант может найти в Интернете научные статьи для написания литературного обзора медицинской кандидатской диссертации, статьи на иностранном языке для подготовки к экзамену кандидатского минимума, описание современных методик исследования и многое другое...

О том, как искать с помощью поисковых машин информацию в Интернете и пойдет речь в данной статье.

Для тех, кто еще не очень хорошо ориентируется в таких понятиях как сайт, сервер - сообщаю начальные сведения о Интернете.

Интернет - это множество сайтов, размещенных на серверах, объединенных каналами связи (телефонными, оптоволоконными и спутниковыми линиями).

Сайт - это совокупность документов в формате html (страниц сайта), связанных между собой гиперссылками.

Большой сайт (например "Medlink" -

медицинский тематический каталог http://www.medlinks.ru

- состоит из 30000 страниц, а объем дискового

пространства, который он занимает на

сервере, составляет около 400 Mб).

Небольшой сайт состоит из нескольких

десятков - сотен страниц и занимает 1 - 10 Мб (например

мой сайт "Врач-аспирант"

25 июля 2004 г. состоял из 280 .htm-страниц и

занимал на сервере 6 Мб).

Сервер - это компьютер, подключенный к Интернету и работающий круглосуточно. На сервере могут быть размещены одновременно от нескольких сотен до нескольких тысяч сайтов.

Сайты, размещенные на компьютере-сервере, могут просматривать и копировать пользователи Интернета.

Для обеспечения бесперебойного доступа к сайтам, электроснабжение сервера осуществляется через источники бесперебойного питания, а помещение, где работают серверы (дата-центр), оборудовано автоматической системой пожаротушения, организовано круглосуточное дежурство технического персонала.

За более чем 10 лет своего существования Рунет (русскоязычный Интернет) стал упорядоченной структурой и поиск информации в Сети стал более предсказуем.

Основной инструмент поиска информации в Интернете - поисковые машины.

Поисковая машина состоит из программы-паука, которая просматривает сайты Интернета и базы данных (индекса), в которой находится информация о просмотренных сайтах.

По заявке веб-мастера робот-паук заходит на сайт и просматривает страницы сайта, занося в индекс поисковой машины информацию о страницах сайта. Поисковая машина может сама найти сайт, даже если его веб-мастер и не подавал заявку на регистрацию. Если ссылка на сайт попадется где-либо на пути поисковой машины (на другом сайте, например), то она сайт тут же проиндексирует.

Паук не копирует страницы сайта в индекс поисковой машины, а сохраняет информацию о структуре каждой страницы сайта - например, какие слова встречаются в документе и в каком порядке, адреса гиперссылок страницы сайта, размер документа в килобайтах, дата его создания и многое другое. Поэтому индекс поисковой машины в несколько раз меньше, чем объем проиндексированной информации.

Что и как ищет поисковая машина в Интернете?

Поисковую машину придумали люди, чтобы она помогала им искать информацию. Что такое информация в нашем человеческом понимании и наглядном представлении? Это не запахи или звуки, не ощущения и не образы. Это просто слова, текст. Когда мы что-то ищем в Интернете, мы запрашиваем слова - поисковый запрос, и в ответ надеемся получить текст, содержащий именно эти слова. Потому что мы знаем, что поисковая система будет искать в массиве информации именно запрошенные нами слова. Потому что именно таковой она была задумана, чтобы искать слова.

Поисковая машина ищет слова не в Интернете, а в своем индексе. В индексе поисковой машины находится информация только о небольшом количестве сайтов Интернета. Существуют поисковые машины, которые индексируют только сайты на английском языке и есть поисковые машины, которые заносят в свой индекс только русскоязычные сайты.

(в индексе находятся сайты на английском, немецком и других европейских языках)

Поисковые машины Рунета (в индексе находятся сайты на русском языке)

Особенности некоторых поисковых машин Рунета

Поисковая машина Google не учитывает морфологию русского языка. Например, Google слова "диссертация" и "диссертации" считает разными.

Необходимо просматривать не только первую страницу результата поискового запроса, но и остальные.

Потому что нередко сайты, в которых содержится действительно нужная пользователю информация, находятся на 4 - 10 странице результата поискового запроса.

Почему так происходит? Во-первых, многие создатели сайтов не оптимизируют страницы своего сайта для поисковых машин, например, не включают в страницы сайта метатеги.

Метатеги - это служебные элементы web-документа, которые на экране не видны, но имеют важное значение при нахождении вашего сайта поисковыми системами. Метатеги облегчают поиск поисковым машинам, чтобы тем не нужно было лезть вглубь документа и анализировать весь текст сайта для составления определенной картины о нем. Наиболее важный метатег - meta NAME="keywords" - ключевые слова страницы сайта. Если слово из основного текста документа не расценено как "поисковый спам" и есть в "keywords" среди первых 50, то вес этого слова в запросе повышается, то есть документ получает более высокую релевантность.

Во-вторых, между веб-мастерами сайтов существует жесткая конкуренция за первые позиции в результате поискового запроса.

Согласно статистике, 80% посетителей на сайт приходит именно с поисковых машин. Рано или поздно веб-мастера осознают это и начинают адаптировать свои сайты к законам поисковых машин.

К сожалению, некоторые из создателей сайтов применяют нечестный метод раскрутки своего сайта через поисковые системы - так называемый "поисковый спам" для создания как будто бы соответствия содержания метатегов и остального текста сайта - размещают на страницах сайта скрытые слова, набранные цветом фона, так что они не мешают посетителям сайта. Однако создатели поисковых машин отслеживают подобные хитрости и сайт "поискового спамера" падает с достигнутых высот на самое дно.

В Интернете малопригодны метафоры и образные сравнения. Они искажают истину, уводят пользователей Интернета от точной и однозначной информации. Чем меньше художественности и больше точности в стиле автора сайта - тем более высокие позиции в результатах поискового запроса занимает сайт.

В свою очередь, если вы хотите, чтобы поисковая машина находила для вас статьи в Интернете - думайте как машина, станьте машиной. Хотя бы на время. На время поиска.

Поисковые машины (Search engine)

Поисковые машины позволяют найти WWW-документы, относящиеся к заданным тематикам или снабженные ключевыми словами или их комбинациями. На поисковых серверах отрабатываются два способа поиска:

· По иерархии понятий;

· По ключевым словам.

Заполнение поисковых серверов происходит автоматически или вручную. Поисковый сервер обычно имеет ссылки на остальные поисковые сервера, и передает им запрос на поиск по желанию пользователя.

Существует два типа поисковых машин.

1."Полнотекстовые" поисковые машины, которые индексируют каждое слово на веб-странице, исключая стоп-слова.

2."Абстрактные" поисковые машины, которые создают реферат каждой страницы.

Для вебмастеров полнотекстовые машины полезней, поскольку любое слово, встречающееся на веб-странице, подвергается анализу при определении его релевантности к запросам пользователей. Однако абстрактные машины могут индексировать страницы лучше полнотекстовых. Это зависит от алгоритма извлечения информации, например по частоте употребления одинаковых слов.

Основные характеристики поисковых машин.

1.Размер поисковой машины определяется количеством проиндексированных страниц. Однако в каждый момент времени ссылки, выдаваемые в ответ на запросы пользователей, могут быть различной давности. Причины, по которым это происходит:

· некоторые поисковые машины сразу индексируют страницу по запросу пользователя, а затем продолжают индексировать еще не проиндексированные страницы.

· другие чаще индексируют наиболее популярные страницы сети.

2.Дата индексации. Некоторые поисковые машины показывают дату, когда был проиндексирован документ. Это помогает пользователю определить, когда документ появился в сети.

3.Глубина индексирования показывает сколько страниц после указанной будет индексировать поисковая система. Большинство машин не имеют ограничений по глубине индексирования. Причины, по которым могут быть проиндексированы не все страницы:

· не правильное использование фреймовых структур.

· использование карты сайта без дублирования обычными ссылками

4.Работа с фреймами. Если поисковый робот не умеет работать с фреймовыми структурами, то многие структуры с фреймами будут упущены при индексировании.

5.Частота ссылок. Основные поисковые машины могут определить популярность документа по тому, как часто на него ссылаются. Некоторые машины на основании таких данных "делают вывод" стоит или не стоит индексировать документ.

6.Частота обновления сервера. Если сервер обновляется часто, то поисковая машина чаще будет его реиндексировать.

7.Контроль индексации. Показывает, какими средствами можно управлять поисковой машиной.

8.Перенаправление. Некоторые сайты перенаправляют посетителей с одного сервера на другой, и этот параметр показывает как это будет связано с найденными документами.

9.Стоп-слова. Некоторые поисковые машины не включают определенные слова в свои индексы или могут не включать эти слова в запросы пользователей. Такими словами обычно считаются предлоги или часто использующиеся слова.

10.Spam-штрафы. Возможность блокирования спама.

11.Удаление старых данных. Параметр, определяющий действия вебмастера при закрытии сервера или перемещении его на другой адрес.

Примеры поисковых машин.

1. Altavista. Система открыта в декабре 1995. Принадлежит компании DEC. С 1996 года сотрудничает с Yahoo. AltaVista - это наилучший вариант для настраиваемого поиска. Однако сортировка результатов по категори ям не выполняется и приходится вручную просматривать предоставленную информацию. В AltaVista не предусмотрены средства для получения списков активных узлов, новостей или других возможностей поиска по содержанию.

2.Excite Search. Запущена в конце 1995 года. В сентябре 1996 - приобретена WebCrawler. Данный узел имеет мощный поисковый меха низм, возможность автоматической индивидуальной настройки предоставляемой информации, а также составленные квалифици рованным персоналом описания множества узлов. Excite отличается от других поисковых узлов тем, что позволяет вести поиск в службах новостей и публикует обзоры Web -страниц. В поисковом механизме используются средства стандартного поиска по ключевым словам и эвристические методы поиска по содержанию. Благодаря такому сочетанию, можно найти подходящие по смыслу страницы Web , если они не содержат указанных пользователем ключе вых слов. Недостатком Excite является несколько хаотичный интерфейс.

3.HotBot. Запущена в мае 1996. Принадлежит компании Wired. Базируется на технологии поисковой машины Berkeley Inktomi. HotBot - это база данных, содержащая документы, индексированные по полному тексту, и один из наиболее полных поисковых механизмов в Web . Его средства поиска по логическим условиям и средства ограничения поиска любой областью или узлом Web помогают пользователю найти необходимую информацию, отсеивая ненужную. HotBot предоставляет возможность выбрать необходимые параметры поиска из раскрывающихся списков.

4.InfoSeek. Запущена раньше 1995 года, легко доступна. В настоящее время содержит порядка 50 миллионов URL. У Infoseek хорошо продуманный интерфейс, а также отличные поисковые средства. Большинство ответов на запросы сопровождается ссылками «связанные темы», а после каждого ответа приводятся ссылки «аналогичные страницы». База данных поискового механизма страниц, индексированных по полному тексту. Ответы упорядочиваются по двум показателям: частоте встреч слово или фраз на страницах, а также метоположению слов или фраз на страницах. Существует каталог Web Directory , подразделяющийся на 12 категорий с сотнями подкатегорий, для которых может быть выполнен поиск. Каждая страница каталога содержит перечень рекомендуемых узлов.

5. Lycos. Работает с мая 1994 года. Широко известна и используема. В состав входит каталог с огромным числом URL . и поисковая машина Point с технологией статистического анализа содержимого страниц, в отличии от индексирования по полному тексту. Lycos содержит новости, обзоры узлов, ссылки на популярные узлы, карты городов, а также средства для поиска адресов, изображений и звуковых и видео клипов. Lycos упорядочивает ответы по степени соот ветствия запросу по нескольким критериям, например, по чис лу поисковых терминов, встретившихся в аннотации к доку менту, интервалу меж ду словами в конкретной фразе документа, местоположению терминов в документе.

6. WebCrawler. Открыта 20 апреля 1994 года как проект Вашингтонского Университета. WebCrawler предоставляет возможности синтаксиса для конкретизации запросов, а также большой выбор аннотаций узлов при несложном интерфейсе.

Следом за каждым ответом WebCrawler помешает небольшую пиктограмму с приблизительной оценкой соответствия запросу. Коме того выводит на экран страницу с кратким резюме для каждого ответа, его полным URL , точной оценкой соответствия, а также использует этот ответ в запросе по образцу в качестве его ключевых слов. Графического интерфейса для настройки запросов в Web Crawler нет. Н е допускается ис пользование универсальных символов, а также невозможно назначить весовые коэффициенты ключевым словам. Не существует возможности ограничения поля поиска определенной областью.

7. Yahoo. Старейший каталог Yahoo был запущен в начале 1994 года. Широко известен, часто используем и наиболее уважаем. В марте 1996 запущен каталог Yahooligans для детей. Появляются региональные и top-каталоги Yahoo. Yahoo основан на подписке пользователей. Он может служить отправной точкой для любых поисков в Web , поскольку с помощью его системы классификации пользователь найдет узел с хорошо организованной информацией. Содержимое Web подразделяется на 14 общих категорий, перечисленных на домашней странице Yahoo !. В зависимости от специфики запроса пользователя существует возможность или работать с этими категориями, чтобы ознакомиться с подкатегориями и списками узлов, или искать конкретные слова и термины по всей базе данных. Пользователь может также ограничить поиск в пределах любого раздела или подраздела Yahoo !. Благодаря тому, что классификация узлов выполняется людьми, а не компьютером, качество ссылок обычно очень высокое. Однако, уточнение поиска в случае неудачи – сложная задача. В состав Yahoo ! входит поисковый механизм AltaVista , поэтому в слу чае неудачи при поиске на Yahoo ! автоматически происходит его повторение с использованием поискового механизма AltaVista . Затем полученные результаты передаются в Yahoo !. Yahoo ! обеспечивает возможность отправлять запросы для поиска в Usenet и в Fourl 1, чтобы узнать адреса электронной почты.

К российским поисковым машинам относятся:

1. Rambler.Это русскоязычная поисковая система. Разделы, перечисленные на домашней странице Rambler , освещают русскоязычные Web -ресурсы. Существует классификатор информации. Удобной возможностью работы является предоставление списка наиболее посещаемых узлов по каждой предложенной тематике.

2. Апорт Поиск. Апорт входит в число ведущих поисковых систем, сертифицированных Microsoft как локальные поисковые системы для русской версии Microsoft Internet Explorer . Одним из преимуществ Апорта является англо-русский и русско-английский перевод в режиме online запросов и поисков результата, благодаря чему можно вести поиск в русских ресурсах Internet , даже не зная русского языка. Более того можно искать информацию, используя выражения, даже для предложений. Среди основных свойств поисковой системы Апорт можно вы делить следующие:

Перевод запроса и результатов поиска с русского на англий ский язык и наоборот;

Автоматическую проверку орфографических ошибок запроса;

Информативный вывод результатов поиска для найденных сайтов;

Возможность поиска в любой грамматической форме;

|

язык расширенных запросов для профессиональных пользователей.

К другим свойствам поиска можно отнести под держку пяти основных кодовых страниц (разных операционных систем) для русского языка, технологию поиска с использовани ем ограничений по URL и дате документов, реализацию поиска по заголовкам, комментариям и подпи сям к картинкам и т. д., сохранение параметров поиска и опреде ленного числа предыдущих запросов пользователя, объединение копий документа, находящихся на разных серверах.

3. List . ru (http://www.list.ru ) По своей реализации этот сервер имеет много общего с англоязычной системой Yahoo !. На главной странице сервера расположены ссылки на наиболее популярные поисковые категории.

|

Список ссылок на основные категории каталога занимает центральную часть. Поиск в каталоге реализован таким образом, что в результате запроса могут быть найдены как отдельные сайты, так и рубрики. В случае успешного поиска выводится URL , название, описание, ключевые слова. Допускается использование языка запросов Яндекс. С сылка "Структура каталога" открывает в отдельном окне полный рубрикатор ката лога. Реализована возможность перехода из рубрикатора в любую выбранную подкатегорию. Более детальное тематическое деление текущей рубрики представлено списком ссылок. Каталог организован таким образом, что все сайты, содержащиеся на нижних уровнях струк туры, представлены и в рубриках. Показываемый список ресурсов упорядочен в алфавитном порядке, но можно выбирать сортировку: по вре мени добавления, по переходам, по порядку добавления в каталог, по популярности среди посетителей каталога.

4. Яndex. Программные продукты серии Яndex представляют набор средств полнотекстовой индексации и поиска текстовых данных с учетом морфологии русского языка. Яndex включает модули морфологического анализа и синтеза, индексации и поиска, а также набор вспомогательных модулей, таких как анализатор документов, языки разметки, конверторы форматов, паук.

Алгоритмы морфологического анализа и синтеза, основанные на базовом словаре, умеют нормализовать слова, то есть находить их начальную форму, а также строить гипотезы для слов, не содержащихся в базовом словаре. Система полнотекстового индексирования позволяет создавать компактный индекс и быстро осуществлять поиск с учетом логических операторов.

Яndex предназначен для работы с текстами в локальной и в глобальной сети, а также может быть подключен как модуль к другим системам.

Лабораторная работа №10.

Поиск информации в сети Internet

Цель работы

Познакомиться с основными поисковыми системами сети Интернет. Овладеть навыками работами в поисковых системах. Научиться выбирать оптимальную поисковую систему с учетом специфики поставленных задач.

Приборы и материалы

Для выполнения лабораторной работы необходим персональный компьютер, функционирующий под управлением операционной системы семейства WINDOWS. Должна быть установлена программа Internet Explorer.

Современные поисковые системы

Интернет - гигантское хранилище информации. Множество страниц, ценных и не очень, существуют безо всякого порядка и связанны между собой только случайными ссылками, зависящими от квалификации и личных пристрастий авторов сайтов. Однако пользователю необходимо ориентироваться в этом многообразии и находить, желательно за минуты, необходимую информацию.

В Интернет существует большое количество поисковых систем. По самым скромным оценкам, их более восьми тысяч, считая классические поисковые машины, общие и специализированные каталоги , а также метапоисковые Web-узлы (которые посылают запросы сразу на несколько поисковых серверов). В дополнение к этому существует ряд альтернативных средств поиска, способных вам пригодиться, включая утилиты, которые, работая совместно с браузером, добывают информацию из Web , и так называемые "экспертные узлы" , где с вашими запросами работают живые люди. В настоящее время разрабатываются интеллектуальные поисковые системы. Примером такой системы может служить, например, интеллектуальная поисковая система Nigma (www.nigma.ru).

Поисковые машины и каталоги

При всем изобилии методов поиска в Internet наиболее распространенными средствами нахождения информации по-прежнему остаются поисковые машины и каталоги. Каждый из этих инструментов имеет определенные преимущества, а основная разница между ними заключается в участии/неучастии человека.

Поисковые машины – это комплекс специальных программ для поиска в сети.

Основные части программного комплекса:

1. Робот spider (паук). Автономно работающая программа, которая перебирает страницы сайтов, стоящих в очереди на индексацию. Она скачивает на диск поискового сервера содержимое исследуемых страниц.

2. Робот crawler (“путешествующий” паук). Его задача - собирать все ссылки на исследуемой странице, находить среди них новые, неизвестные поисковой системе, и добавлять их в список ожидающих индексации.

3. Индексатор. Обрабатывает страницы из очереди на индексацию. Для этого он составляет “словарь” странички, запоминает “частоту” использования слов. Особо отмечает ключевые слова, используемые в заголовках, выделенные в тексте жирным шрифтом. Помещает все это в особый файл - “индекс”.

5. Система обработки запросов и выдачи результатов. Принимает запрос пользователя, формирует запрос к базе данных, получает оттуда результат и передает его пользователю.

Поисковые машины запускают в Web программных "пауков", которые путешествуют со страницы на страницу и на каждой индексируют ее полный текст.

Практически у всех поисковых машин одинаковая форма запроса и примерно одинаковый формат выдачи результатов (см. пункт «Внешний вид поисковых страниц»), однако работа поисковых машин существенно различается. Во-первых, релевантностью (степенью соответствия результатов поиска запросу пользователя), во-вторых, величиной и частотой обновления баз данных, в-третьих, скоростью выдачи результатов. Ну и, конечно, поисковые машины различаются удобством работы.

На сегодняшний день поисковые системы - самые популярные страницы сети, на которых пользователи проводят очень много времени. Поэтому, все большее значение при выборе поисковика приобретают сопутствующие сервисы (почта, новостные ленты, торговые площадки и т.п.).

Каталоги - традиционное средство организации информации. Наверное, всем нам приходилось встречаться с библиотечными каталогами, каталогами товаров. Каталоги используются во множестве систем. Практически везде, где необходимо хранить и организовывать информацию.

Одна из основных задач, с которой сталкиваются составители каталогов - создать естественную, интуитивно понятную рядовому пользователю рубрикацию. К сожалению, данную задачу можно решить только с той или иной степенью приближения. Мир непрерывен, строгих границ в нем не существует. Один и тот же сайт можно рассматривать под разными углами зрения и видеть разные его функции. Каталоги формируются людьми-редакторами, которые прочитывают страницы, отсеивают неподходящие и классифицируют узлы по темам.

К недостаткам каталогов можно отнести следующее.

Во-первых, неоднозначность структуры - это явный минус каталожной организации информации (хотя он и несколько сглаживается тем, что в каждом крупном каталоге реализован поиск по каталогу).

Во-вторых, каталоги делают люди. Их полнота и качество зависят от количества и квалификации людей, занятых работой в каталоге, их личных вкусов и пристрастий. Неровность наполнения рубрик - характерная черта всех каталогов.

В- третьих, трудоемкость ручной рубрикации ограничивает объем каталогизируемой информации.

В тоже время безусловными достоинствами каталогов является то, что информация в нем хранится упорядоченно, в соответствии с элементарной человеческой логикой и релевантность найденных страниц при поиске в каталоге обычно на порядок выше, чем при поиске поисковыми системами.

Как было сказано выше, из-за того, что каталоги создаются вручную, они охватывают намного меньше ресурсов, чем поисковые машины. В Web сейчас, по самым скромным оценкам, насчитывается миллиард страниц (причем их число ежедневно увеличивается на миллион). Большинство поисковых машин не подошли сколько-нибудь близко к тому, чтобы проиндексировать всю Сеть. Исключением является Google (для России www.google.ru), который претендует именно на эту цифру - миллиард страниц, частично или полностью охваченных его индексами. Самый большой каталог - Open Directory Project (www.dmoz.org) - на этом фоне кажется крошечным: в него занесено лишь около 2 млн. страниц.

В 1994 г., когда начинался бурный рост "Всемирной паутины", выбор средств поиска в Сети был весьма ограниченным: Yahoo (www.yahoo.com). Этот сервер и по сей день остается краеугольным камнем исследования Web, но как каталог он столкнулся сейчас с жесткой конкуренцией со стороны Open Directory Project.

Многие каталоги весьма полезны, но с учетом всех обстоятельств предпочтение стоит отдать Open Directory Project. Проект Open Directory Project, инициированный компанией Netscape, реализуется усилиями редакторов-добровольцев со всего мира, которых насчитывается более 24 тысяч и которые проиндексировали около 2 млн. узлов b расклассифицировали их по более чем 200 тыс. категорий. Любой поисковый сервер может получить лицензию Open Directory Project и использовать его базу данных при обработке запросов, и на многих это сделано: AltaVista (www.altavista.com), HotBot (www.hotbot.com), Lycos (www.lycos.co.uk) и около сотни других серверов ныряют туда за ссылками.

Можно было бы ожидать, что, коль скоро каталог Open Directory Project создается силами добровольцев, качество результатов будет колебаться. Но в результате мы получаем хорошо организованные списки относящихся к теме страниц с четкими описаниями каждой ссылки. А узел Open Directory Project производит такое же впечатление, как Google: это "чистый поиск" без отвлекающих моментов типа ссылок на магазины.

Какой каталог ни выбрать, у всех есть одно преимущество перед поисковыми машинами: их можно систематически просматривать, пользуясь иерархической системой меню.