Al ruim zestien jaar heeft iedere gebruiker dat goede kans een haalbare bijdrage leveren aan de ontwikkeling van de wetenschap. Er zijn geen geldelijke donaties of zelfs professionele interesse in het gekozen onderzoeksonderwerp vereist. Het enige dat telt is welke karaktereigenschappen iemand heeft en hoe moderne computers tot zijn beschikking staan. Bij succesvolle combinatie deze factoren verschijnen betrouwbare knooppunten van gedistribueerde computernetwerken - een van de meest krachtige hulpmiddelen verwerking van computergegevens.

Dankzij gezamenlijke inspanningen gewone gebruikers erin geslaagd om veel belangrijke ontdekkingen te doen. Alleen al in de afgelopen drie jaar hebben ze 53 pulsars gevonden, en de laatste zeven zijn vrij recent gevonden - eind augustus 2012. De resultaten van het uitgevoerde onderzoek worden gebruikt bij de ontwikkeling van medicijnen voor de behandeling van diabetes type 2, De ziekten van Alzheimer en Parkinson en andere ernstige ziekten. Er zijn honderden wetenschappelijke artikelen gepubliceerd op basis van het verrichte werk.

Supercomputers en gedistribueerde netwerken

Krachtige supercomputers zijn een druppel op een gloeiende plaat. Er zijn niet zo veel auto's die een bron van trots zijn voor hele landen en die de eerste regels van de TOP 500-beoordeling bezetten, en er zijn er niet genoeg voor iedereen. Om toegang te krijgen tot een supercomputer, moet je eerst de noodzaak van de gekozen taak rechtvaardigen en vervolgens, als de argumenten overtuigend zijn, in de rij wachten en tijd hebben om de code te optimaliseren voor uitvoering op een unieke supercomputerarchitectuur.

Veel mensen hier hebben gehoord van het gedistribueerde computerprogramma BOINC, misschien doen velen er zelfs aan mee. Dit artikel is in de eerste plaats bedoeld voor degenen die nog nooit van dit project hebben gehoord, maar er misschien wel in geïnteresseerd zijn. Hier zal ik korte beschrijvingen geven van de meest populaire projecten.

BOIN- software pakket voor een snelle organisatie van gedistribueerd computergebruik. Bestaat uit een serverruimte en onderdelen van klanten. Aanvankelijk ontwikkeld voor het grootste vrijwillige computerproject - SETI@home, maar latere ontwikkelaars van de University of California in Berkeley maakten het platform beschikbaar voor projecten van derden. Tegenwoordig is BOINC een universeel platform voor projecten op het gebied van wiskunde, moleculaire biologie, geneeskunde, astrofysica en klimatologie. BOINC geeft onderzoekers de mogelijkheid om enorm veel aan te boren computer kracht personal computers van over de hele wereld.

Dit proces kan kort als volgt worden weergegeven:

IN dit moment Het BOINC-netwerk heeft ongeveer 300 duizend actieve deelnemers, wat in totaal meer dan 9 miljoen computers en een prestatie van meer dan 8 petaflops oplevert (op het moment van schrijven).

Kosmologie@Home

Het project is gericht op het vinden van een model op de best mogelijke manier die ons heelal beschrijft, en ontdek welke groep modellen de huidige gegevens bevestigt die zijn verkregen door theoretische kosmologische studies en praktische fysieke observaties.

We hebben allemaal de trilogie 'Back to the Future' bekeken en stellen ons meestal wetenschappers voor in de vorm van Doc - een beetje gek, mensen die zich laten meeslepen door sommige ideeën. Soms willen we ons dezelfde pionier voelen, een hypothese testen, een stelling bewijzen, een tijdmachine bouwen. Of in ieder geval een proefrit maken met deze auto.

Maar laten we teruggaan naar de realiteit. Er is geen tijdmachine. Vluchten naar de ruimte zijn nog niet zo ver weg. Ziekten zijn niet verslagen. “Waar zijn deze wetenschappers? Wat is voor mij bijvoorbeeld het voordeel van de ontdekkingen van Einstein”, denken veel mensen terwijl ze op een boot over de oceaan varen. Maar het schip wordt geleid door GPS, waarvan de satellieten voortdurend over de planeet varen en helpen bepalen waar de ontvanger zich precies op aarde bevindt. En zonder het werk van Einstein zouden we dergelijke technologie niet kunnen gebruiken, omdat bij satellietsnelheden al effecten merkbaar zijn die, als er geen rekening mee wordt gehouden, alle GPS-vizieren zullen afwerpen. Dit betekent dat er nog steeds indirecte voordelen uit de wetenschap voortvloeien. Kunnen we helpen, zo niet Doc, dan wel de wetenschap?

Waarschijnlijk hebben velen van jullie gehoord over vrijwilligers – mensen die vrijwillig iets doen in naam van iets groots: walvissen beschermen, bomen planten, afval opruimen, artsen helpen ziekten te bestrijden – die zowel deelnemen aan de vaccinatie van de volkeren van Afrika als het testen van deze medicijnen. op jezelf. Veel mensen willen iets groots doen. Zo sponsort de Bill and Melinda Gates Foundation een verscheidenheid aan gezondheidsprogramma's: de preventie en behandeling van tuberculose, AIDS, de strijd tegen malaria en koorts.

Stel je de toekomst eens voor, over tien jaar. Er komt een kind naar je toe dat een programma over de griep op Discovery heeft gezien en vraagt: “Papa, wist je dat mensen elk jaar ziek werden van de griep, en onlangs ontdekten wetenschappers er een. remedie ertegen en nu zijn we niet ziek? En jij antwoordt: “Natuurlijk weet ik dat! Ik heb hieraan deelgenomen.”

Het is duidelijk dat dit nog steeds fantasie is, maar je zou er blij mee zijn, toch?

Wat als je de wetenschap en de geneeskunde zou kunnen helpen zonder een fortuin te doneren, zoals Bill Gates, zonder zweet en bloed te vergieten bij vrijwilligersactiviteiten, zonder het risico te lopen malaria op te lopen door gevaccineerde mensen? Je zegt dat dit fantastisch is.

Het SETI-project om te zoeken naar intelligent buitenaards leven is voor velen bekend. Een netwerk van radiotelescopen scant de lucht op ongebruikelijke signalen. Ongebruikelijke zijn degenen die worden herhaald, maar die niet kunnen worden verklaard menselijke activiteit- radars, satellieten, radiostations - of door natuurlijke oorzaken (pulsars, kosmische microgolfachtergrondstraling, enz.). Terwijl ze zoeken naar iets interessants in deze “ruis”, luisteren ze naar frequentie na frequentie – alsof je langzaam aan de afstemming van een radio draait, en al dit gesis tussen radiostations is ruis – en in elke frequentie proberen ze iets te vinden dat zich herhaalt . Hoe? Elk signaal kan worden weergegeven als een grafiek van een functie. Door middel van complexe berekeningen kunt u een formule 'selecteren' die dit zou beschrijven - voer een Fourier-transformatie uit voor de grafiek. Dit is ongelooflijk moeilijk omdat er veel gegevens binnenkomen en dit allemaal langdurige berekeningen vereist. Het gebruik van supercomputers hiervoor zou duur zijn.

In 1994 stelde David Gidi het idee voor om voor berekeningen een geïntegreerd netwerk van computers van vrijwilligers te gebruiken die constant of periodiek met het netwerk zijn verbonden. Gegevens van telescopen worden opgesplitst in duizenden onafhankelijke geluiden op specifieke frequenties en naar de computers gestuurd van mensen die hebben ingestemd om te helpen bij het zoeken naar buitenaardse intelligentie.

Heeft dit het normale computergebruik verstoord? Nee - programma's zijn geschreven om bronnen te gebruiken wanneer deze niet actief zijn. Ongeveer hetzelfde als de screensaver op de monitor verschijnt. Wanneer de gebruiker weer actief begint te werken, bijvoorbeeld een game start of een video converteert, 'valt het programma in slaap' en wacht op het volgende vrije moment. Trouwens, moderne computers hebben vaak veel processors (kernen) en de uitvoering van dergelijke programma's kan zelfs tijdens het gebruik van de computer worden uitgevoerd, zodat de gebruiker de belasting van de machine niet merkt. Het clientprogramma maakt periodiek verbinding met de server om het volgende deel van de gegevens te ontvangen voor berekeningen. Nadat de berekeningen zijn voltooid, worden de resultaten teruggestuurd.

De architectuur die zo werd uitgevonden heet BOIN(Engels) Berkeley Open Infrastructuur voor netwerkcomputing) - open softwareplatform(Universiteit) Berkeley voor GRID Computing). Om de wetenschap te helpen, volstaat het nu om het BOINC-clientprogramma te downloaden en verbinding te maken met een van de projecten.

Folding@Home (F@H, FAH) - een gedistribueerd computerproject voor computermodellering vouwing van eiwitmoleculen. Het doel van dit project is het begrijpen van de technologie en principes van het biochemische proces van creatie (vouwen) en vernietiging (ontvouwen) van eiwitten. Dit is nodig om ziekten als de ziekte van Alzheimer, de ziekte van Parkinson, diabetes en multiple sclerose te bestrijden. Dankzij de computationele hulp van vrijwilligers in dit project er waren veel simulaties en er werden veel tussenliggende simulaties op basis daarvan gepubliceerd wetenschappelijke werken. Dit is het grootste van de vrijwillige gedistribueerde computerprojecten; de algehele prestaties van de systemen die erbij betrokken zijn, kunnen wedijveren met de prestaties van de krachtigste supercomputers planeten.

Einstein@Home - het testen van de hypothese van Einstein

Einstein@Home is een project dat is opgezet om Einsteins hypothese over zwaartekrachtsgolven te testen: de manier waarop zwaartekracht zich door het heelal voortplant. Om dit te doen, bestuderen en stellen ze een gedetailleerde atlas samen van ‘zware’ ruimtevoorwerpen – neutronensterren, zwarte gaten, pulserende sterren, om te begrijpen hoe zwaartekrachtsgolven zich kunnen voortplanten, als ze natuurlijk bestaan. Waarnemingen en metingen in het kader van dit project stellen ons in staat om de problemen beter te begrijpen en te bevestigen (en misschien in de toekomst te weerleggen?) algemene theorie relativiteitstheorie (Herinner je GPS?), ontdek met welke snelheid zwaartekrachtgolven bewegen - is het met de snelheid van het licht, bepaal de fysieke eigenschappen van deze hypothetische golven. Bovendien is sinds 2009 een deel van de capaciteit van het project, en dus ook een deel van de berekeningen van de vrijwilligers, gericht op het zoeken naar radiopulsars en andere ongewone objecten in het heelal.

MilkyWay@Home – astrofysica

MilkyWay@Home is een door vrijwilligers gedistribueerd computerproject in de astrofysica dat tot doel heeft de stroom van stellaire materie in de Melkweg te bestuderen en zeer nauwkeurige dynamische 3D-modellen te produceren. Momenteel wordt de sterrenstroom van Boogschutter voornamelijk gemodelleerd. Het heeft een onstabiele baan en is hoogstwaarschijnlijk ontstaan als gevolg van de convergentie van een dwergstelsel met het Melkwegstelsel.

World Community Grid - helpt IBM

Het World Community Grid (WCG) is een vrijwillig gedistribueerd computerproject gecreëerd door IBM, waaruit vele subprojecten zijn ontstaan. Sommige van deze deelprojecten doen onderzoek naar de bestrijding van kanker en aids. Anderen modelleren middelen voor betere schoonmaak drinkwater, middel om griep en verkoudheid te bestrijden. De beslissing over welke berekeningen prioriteit moeten krijgen, wordt samen met vooraanstaande wetenschappers uit verschillende landen genomen.

Het World Community Grid (WCG) is een vrijwillig gedistribueerd computerproject gecreëerd door IBM, waaruit vele subprojecten zijn ontstaan. Sommige van deze deelprojecten doen onderzoek naar de bestrijding van kanker en aids. Anderen modelleren middelen voor betere schoonmaak drinkwater, middel om griep en verkoudheid te bestrijden. De beslissing over welke berekeningen prioriteit moeten krijgen, wordt samen met vooraanstaande wetenschappers uit verschillende landen genomen.

PrimeGrid - vind priemgetallen

PrimeGrid is een vrijwillig gedistribueerd computerproject met als doel het vinden van priemgetallen(die alleen in 1 en zichzelf zijn verdeeld) van verschillende vormen. Sommige zijn belangrijk voor het testen van wiskundige hypothesen, andere om te testen software of cryptografie.

PrimeGrid is een vrijwillig gedistribueerd computerproject met als doel het vinden van priemgetallen(die alleen in 1 en zichzelf zijn verdeeld) van verschillende vormen. Sommige zijn belangrijk voor het testen van wiskundige hypothesen, andere om te testen software of cryptografie.

Er zijn zelfs veel projecten waarbij je de wetenschap kunt helpen met een deel van de kracht van je pc. Laten we een paar interessante en diverse opsommen, letterlijk op één regel:

sudoku@vtaiwan— het vinden van het minimumaantal begingetallen dat nodig is voor een enkele oplossing van de puzzel;

Leids Klassiek— numerieke oplossing van problemen uit de klassieke mechanica;

Zeventien of buste– het testen van een van de hypothesen van de wiskunde;

Renderboerderij- creatie van een renderingfarm voor iedereen - iedereen kan zijn 3D-modellen ontwikkelen en er een high-definition foto of video van maken;

Raadsel– Een poging om enkele onderschepte en nog steeds niet ontcijferde Duitse berichten uit de Tweede Wereldoorlog te ontcijferen;

LHC@home- een project waarmee je het gedrag van deeltjesbundels in de Large Hadron Collider kunt simuleren; deze gegevens worden vervolgens gebruikt om de installatie te kalibreren;

Magnetisme@home- een project om de magnetische configuraties van cilindrische nano-elementen te berekenen, gemaakt door Konstantin Metlov van het Donetsk Institute of Physics and Technology. Het project lost problemen op van statica, dynamica en thermodynamica voor magnetische nano-elementen met verschillende vormen.

Heel vaak vormen mensen met dezelfde hobby's groepen. Zo is het ook met vrijwillig gedistribueerd computergebruik. Er zijn veel groepen mensen die zich langs verschillende lijnen met elkaar verbinden - één universiteit, één land, vond de groep gewoon leuk. Er is een nationaal team in Oekraïne, waarvan de website distribution.org.ua is. De site heeft een forum waar discussies over verschillende onderwerpen worden gevoerd en waar u meer kunt krijgen gedetailleerde informatie over elk project. Er zijn vergelijkbare nationale teams in Rusland, Polen, Duitsland - in veel landen.

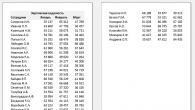

Om het interessanter te maken, organiseren mensen wedstrijden - ze meten hoeveel nuttig werk gedaan en hoeveel punten (credits of kasseien) ze hebben verdiend. Het aantal punten is afhankelijk van de prestaties van de computer, het aantal betrokken machines (meerdere computers kunnen onder één naam worden gebruikt) en de tijd hoe lang de computer berekeningen kan uitvoeren. Sommige projecten houden meerdere keren per jaar zogenaamde races of uitdagingen, waarbij teams strijden om te zien welk team in een bepaalde periode de meeste credits zal verdienen.

Het ‘nadeel’ van uw dergelijke hulp van de wetenschap kan een stijgende elektriciteitsrekening zijn. Dit is de kleine betaling waarmee je, samen met andere vrijwilligers, ziekten kunt verslaan en oplossen complexe taken en vorm een kaart van onze Melkweg. U vraagt zich misschien af: is het mogelijk om hier geld mee te verdienen? Nee, je kan het niet. Ja, zeker niet. Dit is vrijwillige hulp. Vrij.

In deze video vertel ik je hoe je verbinding kunt maken met het vrijwillige gedistribueerde computerproject

Als je vragen hebt, stel ze dan in de reacties. Bedankt voor het delen van het artikel over in sociale netwerken. Al het beste!

Nu bijna iedereen thuis een personal computer heeft, en sommigen hebben er meerdere, is het mogelijk efficiënt gedistribueerd computergebruik uit te voeren.Over de processor en bronnen.

Laten we eens nadenken over wat onze computer doet als we hem gebruiken? Het hart van de computer is CPU . Hij is het die alle wiskundige en logische bewerkingen uitvoert.Elk computerspel, elke film is tenslotte een opeenvolging van bewerkingen van verschuivingen, toevoegingen en overdrachten van individuele bits (dit is het kleinste stukje informatie op een computer). Hoe meer bewerkingen per seconde een processor kan uitvoeren, hoe sneller deze is. Bijna alles computer spelletjes gebruik 100% processorbronnen, d.w.z. De processor geeft maximale snelheid aan het spel. Maar bij het kijken van films, het bewerken van documenten, enz. ligt dat anders. Een film hoeft bijvoorbeeld niet de volledige processorbron te gebruiken, hij heeft slechts een beperkt deel van deze "bron" nodig, zodat de gebruiker bij het kijken geen "sprongen" en rekoefeningen ziet. Op moderne computers het kijken van een film verbruikt slechts 10-15 procent van de processor. En het bewerken van documenten is zelfs nog minder: 1-4 procent. Het blijkt. dat de processor het grootste deel van de tijd inactief is. En het is precies dit ongebruikte deel van zijn tijd en middelen dat kan worden gebruikt voor gedistribueerd computergebruik.

Wat is gedistribueerd computergebruik?

Grof gezegd is dit het proces van het afbreken van één grote berekening die vereist is de krachtigste computer, in vele kleine fragmenten, en deze fragmenten ter beschikking stellen voor verwerking door veel gewone computers. Het programma helpt dit te verwezenlijken BOINC (Berkeley Open Infrastructuur voor Netwerk Computing). - open systeem voor gedistribueerd computergebruik aan de Berkeley University ( dankzij hen voor FreeBSD =)))Wanneer je BOINC op je computer draait, gebeurt het volgende:

1. Uw computer vraagt een lijst met instructies op bij de server. Bovendien zijn de instructies afhankelijk van de mogelijkheden van uw computer. De server geeft bijvoorbeeld geen instructies die te veel RAM-geheugen van uw computer vereisen.

1. Uw computer vraagt een lijst met instructies op bij de server. Bovendien zijn de instructies afhankelijk van de mogelijkheden van uw computer. De server geeft bijvoorbeeld geen instructies die te veel RAM-geheugen van uw computer vereisen. 2. Uw computer downloadt het programma en de gegevens voor berekeningen.

3. Uw computer begint met berekeningen.

4. Uw computer genereert uitvoerberekeningsbestanden.

5. Uw computer stuurt de resultaten naar hoofdserver en vraagt gegevens op voor een nieuwe berekening. De cyclus herhaalt zich opnieuw.

Bovendien werkt BOINC met minimale prioriteit. Dit betekent dat het als laatste processorbronnen ontvangt, d.w.z. als geen enkel programma ze nodig heeft. Hierdoor verslechteren de systeemprestaties niet (en verbeteren ze niet =)).

Om je kennis te laten maken met het BOINC systeem, valt er nog maar één ding te zeggen:

Verschillende wetenschappers – die nieuwe medicijnen voor mensen uitvinden, ziekten bestuderen, de ruimte verkennen op zoek naar buitenaardse intelligentie, zwaartekrachtgolven van verre pulsars bestuderen, en andere onderzoekers – hebben onvoorstelbaar (op de schaal van een heel instituut) dure rekencentra nodig voor berekeningen en gegevensverwerking . Het BOINC-programma geeft je de mogelijkheid om onderzoekers te helpen hun problemen op te lossen.

U kunt BOINC downloaden en informatie vinden over projecten en prestaties op boinc.berkeley.edu

Aan welke projecten kan ik deelnemen?

- Climateprediction.net: - studie van klimaatverandering.

- http://einstein.phys.uwm.edu/: zoeken naar zwaartekrachtpulsen uitgezonden door pulsars.

- http://lhcathome.cern.ch/: verbetering van de CERN LHC-deeltjesversneller

Mogelijke voordelen van het gebruik van parallel computing:

1) Het verhogen van de telsnelheid, d.w.z. dezelfde hoeveelheid werk doen in minder tijd (in de eerste plaats interessant voor taken met tijdslimieten).

2) Promotie bandbreedte, d.w.z. doen groter volume tegelijkertijd werken (in de eerste plaats interessant voor taken die grote hoeveelheden gegevens bevatten).

3) Het vergroten van de macht, d.w.z. het oplossen van problemen met een groter volume (in de eerste plaats interessant voor problemen waarbij de modellen niet voldoende gedetailleerd zijn).

Gunstige resultaten aangegeven kan onbereikbaar zijn tegelijkertijd, met gebruikmaking van dezelfde reeks methoden en technologieën.

Het concept van parallellisme van berekeningen betekent in de eerste plaats hun gelijktijdigheid, dat wil zeggen het gelijktijdige gebruik van verschillende computerapparatuur (processors, kernen, enz.) om ze uit te voeren. De gelijktijdigheid van uitvoering kan worden gebruikt verschillende manieren. Zo kan bijvoorbeeld 1) dezelfde berekening gelijktijdig worden uitgevoerd met delen van dezelfde dataset afzonderlijk (bijvoorbeeld meteorologische problemen, gedistribueerde netwerken in transportproblemen, gedistribueerde controlesystemen in het algemeen); 2) er kunnen tegelijkertijd verschillende berekeningen worden uitgevoerd op één set gegevens (bijvoorbeeld het veeldeeltjesprobleem in de moleculaire dynamica of astrofysica); 3) Verschillende berekeningen kunnen een pijplijn vormen, waarbij elke computer gegevens in delen ontvangt, verwerkt en overdraagt naar de volgende computer (bijvoorbeeld interne implementatie van bewerkingen op echte getallen bij verwerkers).

Om berekeningen überhaupt op een parallelle/gedistribueerde manier uit te voeren, moeten ze worden vertaald in een vorm die geschikt is voor een dergelijke uitvoering: parallellisatie. Keuze specifiek model parallellisatie hangt af van de aard van de taak; scalaire berekeningen, waarvan de afzonderlijke delen onderling opeenvolgend moeten worden uitgevoerd, kunnen niet worden geparalleliseerd.

Verhaal

In 1973 schreven John Schoch en John Hupp van het Xerox PARC Research Center in Californië een programma dat 's nachts draaide in lokaal netwerk PARC en gedwongen draaiende computers om berekeningen uit te voeren.

In 1978 werkte de Sovjet-wiskundige Viktor Glushkov aan het probleem van gedistribueerd computergebruik via macropijplijnen. Hij stelde een aantal principes voor voor het verdelen van werk tussen processors. Op basis van deze principes ontwikkelde hij de ES-2701-computer.

In januari 1996 begon het GIMPS-project met het vinden van Mersenne-priemgetallen, ook met behulp van computers gewone gebruikers als een vrijwillig computernetwerk.

Op 28 januari 1997 werd de RSA Data Security-wedstrijd gelanceerd om het probleem van hacking op te lossen met behulp van een eenvoudige zoekmethode van de 56-bit informatie-encryptiesleutel RC5. Dankzij een goede technische en organisatorische voorbereiding kreeg het project, georganiseerd door de non-profit community distribution.net, al snel grote bekendheid.

Op 17 mei 1999 werd SETI@home, gebaseerd op Grid, gelanceerd en begin 2002 werd de ontwikkeling aan de Universiteit van Californië in Berkeley voltooid. open platform BOINC (Berkeley Open Infrastructure for Network Computing), ontwikkeld sinds april 2000, aanvankelijk voor SETI@Home, maar het eerste project op het BOINC-platform was het Predictor@home-project dat op 9 juni 2004 werd gelanceerd.

Beheer van computertaken

Het probleem van de distributie van verschillende computertaken binnenin gedistribueerd systeem verwijst naar het probleem van besluitvorming onder omstandigheden van onzekerheid. Dit probleem beschouwd in de beslissingstheorie en de onzekerheidstheorie.

Gedistribueerde besturingssystemen

Een gedistribueerd besturingssysteem, dat dynamisch en automatisch werk over verschillende machines van het systeem verdeelt voor verwerking, dwingt een reeks netwerkmachines informatie parallel verwerken. De gebruiker van een gedistribueerd besturingssysteem heeft over het algemeen geen informatie over op welke machine zijn werk wordt uitgevoerd.

Een gedistribueerd besturingssysteem bestaat als één besturingssysteem op schaal computersysteem. Elke computer in een netwerk waarop een gedistribueerd besturingssysteem draait, voert een deel van de functies van dit mondiale besturingssysteem uit. Een gedistribueerd besturingssysteem verenigt alle computers in een netwerk in de zin dat ze nauw met elkaar samenwerken effectief gebruik alle computernetwerkbronnen.

Als gevolg hiervan kan een netwerkbesturingssysteem worden beschouwd als een verzameling besturingssystemen van individuele computers waaruit het netwerk bestaat. Op verschillende computers netwerken kunnen dezelfde of verschillende besturingssystemen gebruiken. Alle computers in een netwerk kunnen bijvoorbeeld hetzelfde UNIX-besturingssysteem gebruiken. Een meer realistische optie is een netwerk waarop verschillende besturingssystemen draaien. Sommige computers draaien bijvoorbeeld op UNIX, andere op NetWare en de rest op Windows NT en Windows 98. Al deze Besturingssysteem opereren onafhankelijk van elkaar in de zin dat elk onafhankelijke beslissingen neemt over het creëren en beëindigen van zijn eigen processen en het beheer van lokale hulpbronnen. Maar in ieder geval moeten de besturingssystemen van computers die op een netwerk werken een onderling overeengekomen reeks communicatieprotocollen bevatten voor het organiseren van de interactie van processen die op verschillende computers in het netwerk draaien en voor het delen van de bronnen van deze computers onder netwerkgebruikers.

Als het besturingssysteem aparte computer stelt het in staat om op het netwerk te werken en kan het zijn middelen ter beschikking stellen normaal gebruik en/of de bronnen van andere computers op het netwerk gebruiken, dan wordt zo’n besturingssysteem van een aparte computer ook wel een netwerk-OS genoemd.

De term ‘netwerkbesturingssysteem’ wordt dus in twee betekenissen gebruikt: als een geheel van besturingssystemen van alle computers in het netwerk en als het besturingssysteem van een individuele computer die op het netwerk kan werken. Uit deze definitie volgt dat besturingssystemen zoals Windows NT, NetWare, Solaris en HP-UX netwerkbesturingssystemen zijn, omdat ze allemaal functies hebben waarmee hun gebruikers op het netwerk kunnen werken.

Links en notities

Het artikel maakt gebruik van materiaal van Wikipedia.Open literatuur

- Parallelle en gedistribueerde berekeningen: numerieke methoden / D.P. Bertsekas, J.N. Tsitsiklis. – Prentice Hall, 1989; Athena Scientific, 1997. – Toegangsmodus: .]