Дубли контента – это частично или полностью одинаковый текст, картинки и прочие элементы наполнения сайта, доступные по разным адресам страниц (URL). Наличие дублей может значительно затруднять поисковое продвижение сайта.

По оценке специалистов, дублированный контент – самая распространенная ошибка внутренней оптимизации, присутствующая на каждом втором веб-ресурсе.

Как проверить, есть ли дубли на вашем сайте, и каким образом от них избавиться? Об этом мы расскажем в новом выпуске нашей рассылки.

Какие бывают дубли

Дубли бывают четкие и нечеткие (или полные и неполные).

Четкие дубли – страницы-копии с абсолютно одинаковым контентом, содержимым мета-тега Description и заголовка Title, доступные по разным адресам. Например, у исходной страницы могут появиться следующие дубли:

- зеркало с WWW или без;

- страницы с разными расширениями (.html, .htm, index.php, GET-параметром «?a=b» и т. д.);

- версия для печати;

- версия для RSS;

- прежняя форма URL после смены движка;

- и так далее.

Нечеткие дубли – частично одинаковый контент на разных URL.

В качестве примеров таких дублей можно привести следующие варианты:

- карточки однотипных товаров с повторяющимся или отсутствующим описанием;

- анонсы статей, новостей, товаров в разных рубриках, на страницах тегов и постраничной разбивки;

- архивы дат в блогах;

- страницы, где сквозные блоки по объему превосходят основной контент;

- страницы с разными текстами, но идентичными Title и Description.

Чем опасны дубли для продвижения

1. Затрудняется индексация сайта (и определение основной страницы)

Из-за дублей количество страниц в базе поисковых систем может увеличиться в несколько раз, некоторые страницы могут быть не проиндексированы, т. к. на обход сайта поисковому роботу выделяется фиксированная квота количества страниц.

Усложняется определение основной страницы, которая попадет в поисковую выдачу: выбор робота может не совпасть с выбором вебмастера.

2. Основная страница в выдаче может замениться дублем

Если дубль будет получать хороший трафик и поведенческие метрики, то при очередном апдейте он может заменять основную (продвигаемую) страницу в выдаче. При этом позиции в поиске «просядут», т.к. дубль не будет иметь ссылочной популярности.

3. Потеря внешних ссылок на основную страницу

4. Риск попадания под фильтр ПС

И Яндекс, и Google борются с неуникальным контентом, в связи с чем могут применить к «засоренному» сайту фильтры АГС и Panda.

5. Потеря значимых страниц в индексе

Неполные дубли (страницы категорий, новости, карточки товаров и т. д.) из-за малой уникальности имеют шанс не попасть в индекс поисковиков вообще. Например, это может случиться с частью товарных карточек, которые поисковый алгоритм сочтет дублями.

Как найти и устранить дубли на сайте

Будучи владельцем сайта, даже без специальных знаний и навыков вы сможете самостоятельно найти дубли на вашем ресурсе. Ниже дана инструкция по поиску и устранению дублированного контента.

Поиск полных дублей

Самый быстрый способ найти полные дубли на сайте – отследить совпадение тегов Title и Description. Для этого можно использовать панель вебмастера Google или популярный у оптимизаторов сервис Xenu. Поиск ведется среди проиндексированных страниц.

Минусы: не все дубли можно (и нужно) удалять (например версии страниц с рекламными метками); трудоемкая работа, занимающая при большом количестве страниц много времени. Не исключает появления новых дублей. Вес с дублей не передается основной странице.

- Плюсы: не требует специальных навыков программирования.

6. Готовые решения для популярных CMS

Разработчики популярных CMS предусмотрели ряд решений, предотвращающих появление дублей. При этом вебмастерам при работе с движком необходимо внимательно выставлять настройки. Если вы что-то упустили из виду и дубли все же появились, никогда не поздно все исправить и устранить копии. Внятные инструкции по настройкам движка и использованию SEO-плагинов можно найти на профильных блогах и на форумах WordPress, Joomla, Drupal, Битрикс, а также других широко представленных CMS.

Полезные SEO-плагины для борьбы с дублями:

- WordPress: All in One SEO Pack, Clearfy;

- Drupal: Global Redirect, Page Title;

- Joomla: Canonical Links All in One, JL No Dubles.

7. Борьба на уровне движка

Универсальное решение для самых разных CMS – предупредить появление новых дублей на уровне движка. Необходимо задать такое условие, при котором в процессе обработки адресных ссылок CMS будет отличать «хорошие» от «плохих» и отображать в строке браузера только те, которые разрешены правилом. Это позволит избежать формирования страниц-синонимов (со знаком «/» и без него, с ненужным окончанием.html, GET-параметрами и проч.), однако не защитит от возникновения дублей, если у страниц не будут уникализированы Title и Description.

Для реализации данного метода в файле.htaccess необходимо включить следующее правило:

RewriteEngine on RewriteCond %{REQUEST_FILENAME} !-d RewriteCond %{REQUEST_FILENAME} !-f RewriteRule ^(.*)$ index.php

Кроме этого, следует реализовать необходимые проверки в самом движке.

Метод отличается высокой сложностью и требует обращения к специалистам по разработке.

- Минусы: крайне высокая степень сложности.

- Плюсы: предотвращает появление страниц-синонимов.

Поиск неполных дублей

1. Ищем при помощи вебмастера Google или сервиса Xenu

Алгоритм действий в этих сервисах абсолютно такой же, как и для поиска полных дублей. Единственное отличие заключается в том, что среди найденных дублей необходимо отобрать те страницы, которые имеют идентичные Title и/или Description, но совершенно разный контент.

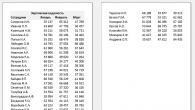

В результате поиска в Google мы обнаружили группу неполных дублей (Рис. 2).

Рис. 2. Совершенно разные новости с дублированными мета-данными

Рис. 2. Совершенно разные новости с дублированными мета-данными 2. Ищем в строке поиска Яндекса или Google

Страницы с частично похожим контентом, но разными мета-данными указанным выше способом выявить не удастся. В этом случае придется работать вручную.

Для начала условно выделите зоны риска:

- скудный контент (сквозные блоки по объему превосходят основной текст страницы);

- копированный контент (описание схожих товаров);

- пересечение контента (анонсы, рубрики/подкаталоги, фильтры, сортировка).

Из каждой группы выберите несколько страниц.

Для наглядной иллюстрации примера мы воспользовались одной из карточек товаров на сайте мебельного магазина, проходившего аудит в нашей рубрике «Экспертиза». Вероятность появления дублей здесь достаточно высока, так как в карточках преобладают картинки и сквозные блоки, а уникальный контент сведен к минимуму.

Указываем в строке поиска Google фрагмент текста из описания товара, заключенный в кавычки, и домен сайта с оператором site: (Рис. 3).

Дубликаты контента — одна из основных проблем низкого ранжирования сайта в поисковых системах. К данной проблеме приводит наличие на сайте страниц, которые полностью или частично идентичны друг другу. Естественно для поисковых систем наличие на сайте мусорных страниц представляет серьёзную проблему, так как приходится тратить на их обработку серверные мощности. Поисковым системам нет смысла тратить физические ресурсы на индексацию такого бесполезного контента. Поэтому они борются с такими сайтами, накладывая на них фильтр, либо занижает в ранжировании, что приводит к низким позициям по продвигаемым запросам.

Дубликаты и SEO

Наличие на сайте страниц дубликатов приводит к тому что:

- Полезный ссылочный вес распыляется на эти бесполезные страницы.

- Страница-дубликат после очередного апдейта вытесняет целевую страницу и та теряет позиции.

- Дублированный контент снижает уникальность всех страниц на которых он размещён.

- По мере того, как поисковая система борется с такими страницами, удаляя их из поиска — она может исключить и продвигаемую страницу.

Классификация дубликатов и решения по их устранению

Дубликаты бывают полными и частичными. Полные дубликаты — это когда страницы полностью идентичны. Соответственно, частичные дубли — это когда страницы совпадают не полностью. Полные дубликаты устраняют через robots.txt и настройку 301 редиректа. Частичные дубликаты устраняются путем проведения необходимых правок на сайте.

Привожу перечень чек-листов, которые нужно пройти, чтобы выявить и решить проблему дубликатов:

- Поиск дубликатов главной страницы сайта. Например, могут быть следующие варианты главной страницы: http://www.domen.com/, http://www.domen.com/index.php, http://www.domen.com, http://domen.com/, https://www.domen.com/, http://www.domen.com/index.html. Как видите вариантов много, но оптимальным является вариант http://www.domen.com/. Для устранения остальных копий главной страницы используется 301 редирект и закрытие в robots.txt (в случае с конструкциями вида https://www.domen.com/.

- Проверка фундаментального (золотого правила SEO) — каждая страница должна быть доступна только по одному адресу. Нельзя, чтобы адреса варьировались следующим образом: http://www.domen.com/stranica1/stranica2/ и http://www.domen.com/stranica2/stranica1/.

- Проверка на наличие переменных в урле. Их, в адрессе страницы, быть не должно. Например, генерация урлов вида: http://www.domen.ru/index.php?dir=4567&id=515 — это ошибка. Правильным будет следующий вариант урла: http://www.domen.ru/dir/4567/id/515.

- Проверка на наличие в урлах идентификаторов сессии. Например, урлы вида http://www.domen.ru/dir/4567/id/515.php?PHPSESSID=3451 — недопустимы. Такие урлы содержат бесконечное количество копий каждой страницы. Поэтому необходимо закрывать все идентификаторы сессий в robots.txt.

Дублированный контент или просто дубли - это страницы на вашем сайте, которые полностью (четкие дубли) или частично (нечеткие дубли) совпадают друг с другом, но каждая из них имеет свой URL. Одна страница может иметь как один, так и несколько дублей.

Как появляется дублированный контент на сайте?

Как для четких, так и для нечетких дублей есть несколько причин возникновения. Четкие дубли могут возникнуть по следующим причинам:

- Они появляются из-за CMS сайта. Например, с помощью replytocom в WordPress, когда добавление новых комментариев создает автоматом и новые страницы, отличающиеся только URL.

- В результате ошибок веб-мастера.

- Из-за изменения структуры сайта. Например, при внедрении обновленного шаблона с новыми URL.

- Делаются владельцем сайта для определенных функций. Например, страницы с версиями текста для печати.

Нечеткие дубли на вашем сайте могут появиться по следующим причинам:

Почему дублированный контент вредит сайту?

- Негативно влияет на продвижение в поисковой выдаче. Поисковые роботы отрицательно относятся к дублированному контенту и могут понизить позиции в выдаче из-за отсутствия уникальности, а следовательно, и полезности для клиента. Нет смысла читать одно и то же на разных страницах сайта.

- Может подменить истинно-релевантные страницы. Робот может выбрать для выдачи дублированную страницу, если посчитает ее содержание более релевантным запросу. При этом у дубля, как правило, показатели поведенческих факторов и/или ссылочной массы ниже, чем у той страницы, которую вы целенаправленно продвигаете. А это значит, что дубль будет показан на худших позициях.

- Ведет к потере естественных ссылок. Когда пользователь делает ссылку не на прототип, а на дубль.

- Способствует неправильному распределению внутреннего ссылочного веса. Дубли перетягивают на себя часть веса с продвигаемых страниц, что также препятствует продвижению в поисковиках.

Как проверить, есть у вас дубли или нет?

Чтобы узнать, есть у страниц сайта дубли или нет, существует несколько способов.

Нашли дубли? Читаем, как их обезвредить:

- 301-й редирект Этот способ считается самым надежным при избавлении от лишних дублей на вашем сайте. Суть метода заключается в переадресации поискового робота со страницы-дубля на основную. Таким образом, робот проскакивает дубль и работает только с нужной страницей сайта. Со временем, после настройки 301-ого редиректа, страницы дублей склеиваются и выпадают из индекса.

- Тег . Здесь мы указываем поисковой системе, какая страница у нас основная, предназначенная для индексации. Для этого на каждом дубле надо вписать специальный код для поискового робота , который будет содержать адрес основной страницы. Чтобы не делать подобные работы вручную, существуют специальные плагины.

- Disallow в robots.txt . Файл robots.txt - своеобразная инструкция для поискового робота, в которой указано, какие страницы нужно индексировать, а какие нет. Для запрета индексации и борьбы с дублями используется директива Disallow. Здесь, как и при настройке 301-го редиректа, важно правильно прописать запрет.

Как убрать дубли из индекса поисковых систем?

Что касается Яндекса, то он самостоятельно убирает дубли из индекса при правильной настройке файла robots.txt. А вот для Google надо прописывать правила во вкладке «Параметры URL» через Google Вебмастер.

Если у вас возникнут трудности с проверкой и устранением дублированного контента, вы всегда можете обратиться к нашим специалистам. Мы найдем все подозрительные элементы, настроим 301-й редирект, robots.txt, rel= "canonical", сделаем настройки в Google . В общем, проведем все работы, чтобы ваш сайт эффективно работал.

Многие владельцы сайтов уделяют внимание главным образом тому, чтобы контент был уникален по сравнению с другими ресурсами. Однако не стоит упускать из виду наличие дублированного контента в пределах одного сайта. Это тоже оказывает сильное влияние на ранжирование.

Что такое дублированный контент

Повторяющийся, или дублированный, контент – это совпадающие в рамках сайта объемные блоки текста на разных страницах. Не обязательно такое делается со злым умыслом – чаще возникает по техническим причинам, подробно разобранные ниже.

Опасность состоит в том, что часто дублированный контент невозможно увидеть невооруженным глазом, однако поисковик его прекрасно видит и реагирует соответствующим образом.

Откуда берется дублированный контент и где он чаще встречается

Основные причины возникновения такого явления:

- Изменение структуры сайта;

- Намеренное использование в конкретных целях (скажем, версии для печати);

- Ошибочные действия программистов и веб-мастеров;

- Неувязки с CMS.

Например, часто встречается ситуация: replytocom (ответ на комментарий) в WordPress автоматически формирует и новые страницы с разными URL-адресами, но не содержимым.

Обычно дублированный контент замечается при создании анонсов статьи на других страницах сайта, размещении отзывов, а также при одинаковых описаниях товаров, категорий, рубрик.

Почему дублированный контент – это плохо

У повторяющегося содержимого есть аналог из области экономики – банковский овердрафт. Только здесь расходуется так называемый краулинговый бюджет. Это число страниц ресурса, которое за конкретный промежуток времени сможет просканировать поисковая машина. Ресурс очень ценный, и лучше потратить его на действительно важные и актуальные страницы, чем на десятки дублей идентичного текста.

Таким образом, дублированный контент ухудшает поисковое продвижение. Кроме того, теряются естественные ссылки и неверно распределяется ссылочный вес внутри сайта. А также подменяются по-настоящему релевантные страницы.

Как найти дублированный контент на сайте (вручную, программы и сервисы)

Существуют специальные программы для анализа ресурсов. Из них пользователи особенно выделяют Netpeak Spider. Она ищет полные копии страниц, совпадения по тайтлу или дескрипшену, заголовкам. Другой вариант — Screaming Frog, которая обладает схожим функционалом и по сути отличается только интерфейсом. Еще есть приложение Xenu`s Link Sleuth, работающее схожим с поисковиком образом и способное довольно качественно прочесать сайт на наличие дубликатов.

К сожалению, нет инструментов, способных полноценно отслеживать все дубли текста. Поэтому, скорее всего, придется производить ручную проверку. Вот список возможных факторов, повлекших за собой проблему:

Разобрались, как найти дублированный контент. А лучшие помощники в борьбе с ним – это переадресация 301, теги Canonical URL, указания в robots.txt и параметры Nofollow и Noindex в составе мета-тега «robots».

Одним из способов на скорую руку проверить, если ли на сайте дублированный контент, является расширенный поиск в Яндексе или Гугле. Необходимо ввести адрес сайта и кусок текста со страницы, которую решили проверить. Также можно использовать многочисленные программы для проверки уникальности текста:

- Text.Ru;

- eTXT Антиплагиат;

- Advego Plagiatus;

- Content-Watch.

Как бороться и чистить дублированный контент

Всё та же справочная система Гугл дает ряд советов по предотвращению появления данной проблемы.

- 301. При структурных изменениях ресурса необходимо указывать редирект 301 в файле htaccess.

- Используйте единый стандарт ссылок.

- Контент для конкретного региона лучше размещать на доменах верхнего уровня, чем на поддоменах или в поддиректориях.

- Устанавливайте предпочтительный способ индексирования с помощью Search Console.

- Не используйте шаблоны. Вместо того, чтобы на каждой странице размещать текст о защите авторского права, лучше сделать ссылку, которая будет вести на отдельную страницу с этим текстом.

- Разрабатывая новые страницы, следите, чтобы до полной готовности они были закрыты от индексации.

- Разберитесь, как именно отображается ваш контент – могут быть отличия отображения в блогах и форумах.

- Если на сайте много схожих статей, лучше или объединить их содержимое в одно целое, или уникализировать каждую.

Поисковиками не предусмотрено никаких санкций по отношению к сайтам, имеющим дублированный контент по техническим причинам (в отличие от тех, кто делает это намеренно с целью манипулировать результатами поиска или вводить в заблуждение посетителей).

После того, как дубли удалены, осталось убрать их из поисковой выдачи. Яндекс делает это самостоятельно, при условии, что файл robots.txt настроен должным образом. Что касается Google: там придется вручную прописать правила в Вебмастере, на вкладке «Параметры URL».

Заключение

Борьба с дублированным контентом на сайте – важный аспект деятельности владельца любого сайта. Причин его возникновения довольно много, и столь же много способов устранения.

Однако главным правилом остается: размещать исключительно оригинальный контент, независимо от типа сайта. Даже если это крупный сетевой магазин с тысячами страниц.

ПОЛУЧАЙТЕ АНОНСЫ ПОДОБНЫХ ПОСТОВ СЕБЕ НА ПОЧТУ

Подпишитесь и получайте не чаще, чем раз в неделю что-нибудь интересное из мира интернет-маркетинга, SEO, продвижения сайтов, интернет-магазинов, заработка на сайтах.

Дублированный контент можно разделить на три большие категории : точный дубликат , где два URL-адреса имеют полностью идентичный контент, контент с небольшими отличиями (порядок предложений, немного другие изображения и т. д.) и кроссдоменные дубликаты , где точная или немного измененная копия существует на многих доменах.

Существуют две связанных концепции, которые не считаются Google тем же самым, что и дублированпый контент, но которые часто сбивают с толку издателей и неопытных SEO-специалистов:

- тонкий контент - как было отмечено ранее, это страницы, на которых очень мало контента. В качестве примера можно привести набор страниц, построенный на списке адресов организаций, в котором есть 5000 адресов, но каждая страница содержит только один адрес - всего несколько строк;

- нарезка контента- в эту категорию попадают страницы, которые незначительно отличаются друг от друга. Представьте себе сайт, продающий обувь Nike Air Мах, которая приходит в размерах 37, 37,5, 38, 38,5, 39, ... 46. Если у сайта есть отдельная страница для каждого размера обуви, то разница между всеми этими страницами будет незначительной. Подобный эффект Google и называет тонкой нарезкой.

Google не любит ни тонкий контент, ни тонкую нарезку. Любой из этих эффектов может быть выявлен алгоритмом «Панда». Как именно Bing отличает дубликацию контента, тонкий контент и нарезку контента не ясно, но точно известно, что издатели должны избегать создания этих типов страниц.

Дублированный контент может получиться по многим причинам, в том числе благодаря лицензированию контента вашего сайта, дефектам архитектуры сайта вследствие не оптимизированной под поисковики системы управления контентом или из-за наличия плагиата. В последние пять лет спамеры, испытывающие чрезвычайную необходимость в контенте, начали «выцарапывать» контент из легальных источников, переставлять слова посредством множества сложных процессов и размещать полученный текст на своих страницах, чтобы привлечь операции поиска из «длинного хвоста» и продемонстрировать контекстную рекламу, а также и для прочих бесчестных целей.

Таким образом, сегодня мы живем в мире «проблем дублированного контента» и «штрафов за дублирование контента». Приведем некоторые определения, которые будут полезны для нашего обсуждения.

- Уникальный контент- написан человеком, полностью отличается от любой другой комбинации букв, символов и слов во Всемирной паутине, не подвергался воздействию компьютерных алгоритмов обработки текста (таких как инструменты спамеров, использующие цепи Маркова).

- Фрагменты - это небольшие куски контента (например, цитаты), которые копируются и используются многократно. Они почти никогда не являются проблемой для поисковых движков, особенно когда включаются в более крупный документ с большим количеством уникального контента.

- Шинглы - поисковые движки ищут относительно небольшие сегменты фраз (пять- шесть слов) на других страницах во Всемирной паутине. Если два документа имеют слишком много общих шинглов, то поисковые движки могут интерпретировать эти документы как дублированный контент.

- Проблемы дублированного контента - эта фраза, как правило, служит для обозначения дублированного содержания, за которое сайт может быть оштрафован. Такой контент просто является копией существующей страницы, заставляющей поисковик выбирать, какую версию в индексе нужно отображать (это так называемый фильтр дублированного контента).

- Фильтр дублированного контента - ситуация, когда поисковик удаляет подобный контент из результатов поиска, чтобы предоставить лучшие результаты пользователю.

- Штраф за дублированный контент - штрафы (пенальти) применяются редко и только в очевидных ситуациях. Поисковые движки могут уменьшить рейтинг или запретить остальные страницы сайта, могут даже запретить весь веб-сайт.

Последствия дублированного контента

Предполагая, что ваш дублированный контент является результатом безобидного недосмотра со стороны ваших разработчиков, поисковый движок, скорее всего, отфильтрует все дублированные страницы (кроме одной), поскольку он хочет показать на страницах результатов поиска только одну версию такого контента. В некоторых случаях поисковый движок может отфильтровать результаты до включения их в индекс, а в других случаях - допустить страницу в индекс и отфильтровать ее уже при подготовке результатов поиска в ответ на конкретный запрос. В этом последнем случае страница может быть отфильтрована в ответ на некоторые определенные запросы и не отфильтрована для других.

Пользователи хотят видеть в результатах разнообразие (а не одни и те же результаты снова и снова). Поэтому поисковые движки стараются отфильтровывать дублированный контент, и это имеет такие последствия:

- робот поискового движка приходит на сайт с определенной сметой просмотра, выражающейся в количестве страниц, которые он планирует просмотреть в каждом конкретном сеансе. Каждый раз, когда он попадает на дублированную страницу, которая просто должна быть отфильтрована из результатов поиска, вы позволяете роботу потратить впустую некоторую часть его сметы на просмотр. Это означает, что будет просмотрено меньше ваших «хороших» страниц и приведет к тому, что в индекс поискового движка будет включено меньшее количество ваших страниц;

- несмотря на то, что поисковые движки стараются отфильтровать дублированный контент, ссылки на страницы дублированного контента все равно передают им «сок ссылок». Поэтому дублированные страницы могут получить рейтинг PageRank или «сок ссылок», а поскольку это не помогает им в рейтинге, то этот ресурс теряется впустую;

- ни один из поисковых движков не дал четкого объяснения, как его алгоритм выбирает ту версию страницы, которую будет показывать. Иначе говоря, если он обнаруживает три копии одного и того же контента, то какие две из них он отфильтрует? Какую покажет? Зависит ли это от поискового запроса? В итоге поисковый движок может показать не ту версию, которая вам нужна.

Несмотря на то, что отдельные специалисты по оптимизации могут поспорить с некоторыми из приведенных здесь положений, общая структура практически ни у кого не вызывает возражений. Однако по границам этой модели имеется несколько проблем.

Например, на вашем сайте есть группа товарных страниц, а также версии этих страниц для распечатывания. Поисковый движок может выбрать для показа в своих результатах именно версию для печати. Такое иногда случается, причем это может произойти даже тогда, когда страница для распечатывания имеет меньше «сока ссылок» и более низкий рейтинг, чем основная страница товара.

Для исправления такого положения надо применить атрибут ссылки rel=”canonical” ко всем дублированным версиям страницы, чтобы указать главную версию.

Второй вариант может появиться тогда, когда вы синдицируете свой контент (разрешаете перепечатку своего контента) сторонним организациям. Проблема состоит в том, что поисковый движок может выкинуть из результатов поиска ваш оригинал и предпочесть ему ту версию, которую использует человек, перепечатавший вашу статью. Есть три потенциальных решения этой проблемы:

- пусть человек, переопубликовавший вашу статью, установит обратную ссылку на исходную статью на вашем сайте с атрибутом rel=”canonical” . Это укажет поисковым машинам, что ваша копия страницы является оригиналом и любые ссылки, указывающие на синдицированную страницу, будут зачислены на вашу оригинальную страницу;

- пусть ваш партнер по синдикации закроет свою копию атрибутом noindex . В этом случае дублированный контент просто не будет индексироваться поисковой машиной. Кроме того, любые ссылки в этом контенте на ваш сайт будут по-прежнему передавать полномочия вам;

- пусть ваш партнер сделает обратную ссылку на исходную страницу на вашем сайте. Поисковики обычно это корректно интерпретируют и подчеркивают вашу версию контента. Однако следует отметить, что были случаи, когда Google ошибочно определяла авторство контента и назначала авторство сайту, который переопубликовал его, особенно если тот сайт имеет гораздо больше полномочий и доверия, чем истинный первоисточник контента.

Как поисковые движки распознают дублированный контент?

Процесс поиска дублированного контента во Всемирной паутине для движка Google мы проиллюстрируем примерами. В примерах, представленных на рис. 1-4, сделаны три допущения:

- страница с текстом - это страница, содержащая дублированный контент (а не просто его фрагмент, как это показано на рисунках);

- все страницы с дублированным контентом находятся в разных доменах;

- показанные далее шаги были упрощены, чтобы сделать процесс легким и понятным (насколько это возможно). Это, безусловно, не является точным описанием работы Google, но передает смысл.

Рис. 1

Рис. 2

Рис. 3

Рис. 4

Имеется несколько фактов, касающихся дублированного контента, которые заслуживают особого упоминания, поскольку они могут запутать веб-мастера, являющегося новичком в области проблем дублированного контента. Рассмотрим эти факторы.

- Местоположение дублированного контента - если весь этот контент находится на моем сайте, является ли он дублированным? Да, потому что дублированный контент может получиться как в пределах одного сайта, так и на разных сайтах.

- Процент дублированного контента - какой процент страницы должен быть дублирован, чтобы попасть под фильтрацию дублированного контента? К сожалению, поисковые движки никогда не раскрывают эту информацию, поскольку это нанесло бы ущерб их способности предотвращать саму проблему.

- Почти уверенно можно утверждать, что этот процент у всех движков постоянно меняется, и при выявлении дублированного контента производится не только прямое сравнение. Итог таков: чтобы считаться дубликатами, страницы не обязательно должны быть идентичными.

- Соотношение кода и текста - а что, если наш код очень большой, но на странице мало уникальных HTML-элементов? Не подумает ли Google, что все страницы являются дубликатами друг друга? Нет. Поисковым движкам нет никакого дела до вашего кода, их интересует контент ваших страниц. Размер кода превращается в проблему только тогда, когда он становится чрезмерным.

- Соотношение навигационных элементов и уникального контента - все страницы моего сайта имеют большую навигационную полосу, много верхних и нижних колонтитулов, но совсем мало контента. Не сочтет ли Google все эти страницы дублированными? Нет. Google (а также Yahoo! и Bing) учитывает элементы навигации еще до оценки страниц на дублирование. Они хорошо знакомы с компоновкой веб-сайтов и понимают, что наличие постоянных структур на всех страницах (или большом их количестве) - это совершенно нормально. Они обращают внимание на уникальные части страниц и почти совершенно игнорируют остальные.

- Лицензированный контент - что делать, если я хочу избежать проблем с дублированием контента, но у меня есть контент из других веб-источников, который я лицензировал для показа своим посетителям? Используйте код meta name = "robots” content="noindex, follow" . Поместите его в верхнем колонтитуле вашей страницы, и поисковые движки будут знать, что этот контент не для них. Это лучшая практика, поскольку люди все равно смогут посетить эту страницу и сделать на нее ссылку, а ссылки на этой странице будут сохранять свою ценность.

Другой вариант- получить эксклюзивные права на владение этим контентом и его публикацию.

Выявление и устранение нарушений авторских прав

Один из лучших способов отслеживания дублирования вашего сайта - это прибегнуть к помощи сайта CopyScape (copyscape.com), который позволяет моментально увидеть те страницы во Всемирной паутине, которые используют ваш контент. Не беспокойтесь, если страницы этих сайтов находятся во вспомогательном индексе или имеют значительно более низкий рейтинг, чем ваши, - если бы какой-то большой, авторитетный и богатый контентом домен попытался бороться со всеми копиями его материалов во Всемирной паутине, то ему потребовались бы, по крайней мере, два человека на полную рабочую неделю. К счастью, поисковые движки доверяют таким сайтам и поэтому признают их оригинальными источниками.

С другой стороны, если у вас есть относительно новый сайт или сайт с небольшим количеством входящих ссылок, а плагиаторы постоянно стоят в рейтинге выше вас (или вашу работу крадет какой-то мощный сайт), то вы можете кое-что предпринять. Один из вариантов- отправить запрос издателю с просьбой удалить контент, нарушающий авторские права. В некоторых случаях издатель просто не знал о нарушении авторских прав. Еще один из вариантов - написать хостинг-провайдеру. Хостинговые компании потенциально могут нести ответственность за организацию дублированного контента, поэтому они часто быстро реагируют на такие запросы. Просто убедитесь, что вы готовы предоставить как можно больше возможной документации, подтверждающей авторство контента.

Следующий вариант - отправить запрос о нарушении авторских прав (DMCA) в Google, Yahoo! и Bing. Этот же запрос вам следует отправить и той компании, у которой размещен сайт нарушителя.

Второй вариант - возбудить дело в суде против сайта-нарушителя или пригрозить это сделать. Если публикующий ваши работы сайт имеет владельца в вашей стране, то этот вариант, вероятно, является самым разумным первым шагом. Вы можете начать с более неформального общения и попросить удалить контент еще до того, как посылать официальное письмо от адвоката, поскольку до вступления в силу мер агентства DMCA могут пройти месяцы. Но если вам не отвечают, то у вас нет никаких причин откладывать более серьезные действия.

Очень эффективным и недорогим вариантом для этого процесса является ресурс DCMA.com .

Ситуация с реальным штрафом

Предыдущие примеры показывают работу фильтров дублированного контента, но это не штрафы, хотя в практическом смысле эффект тот же самый, что и от штрафов, - снижение рейтингов ваших страниц. Однако есть и такие ситуации, когда может появиться настоящий штраф. Например, этим рискуют агрегирующие контент сайты, в особенности если сам сайт добавляет мало уникального контента. При таком сценарии сайт может быть реально оштрафован.

Исправить это можно только уменьшением количества дублированных страниц, доступных пауку поискового движка. Это достигается путем их удаления, посредством добавления атрибута canonical в дубликаты, атрибута noindex в сами страницы, либо добавлением значительного количества уникального контента.

Пример контента, который может часто отфильтровываться, - это «тонкий» сайт-партнер. Так часто называют сайт, который продвигает продажи чужих товаров, чтобы заработать комиссионные, но не предоставляет новой информации. Такой сайт мог получить описания от изготовителя товаров и просто воспроизвести эти описания вместе со ссылкой на партнера, чтобы заработать на «кликах» или покупках.

Проблема возникает тогда, когда продавец имеет тысячи партнеров, использующих один и тот же контент, - а инженеры поисковых движков получили от пользователей данные о том, что (с их точки зрения) такие сайты не добавляют ничего ценного в их индексы. Поэтому поисковые движки пытаются отфильтровать такие сайты или даже исключить их из своих индексов. Партнерские модели применяет множество сайтов, но они также предоставляют и новый богатый контент, поэтому у них обычно нет проблем. Поисковые движки принимают меры только тогда, когда одновременно возникает и дублирование контента, и отсутствие уникального ценного материала.

Как избежать дублированного контента на сайте?

Как мы уже отмечали ранее, дублированный контент может создаваться многими способами. Внутреннее дублирование материала требует применения специфической тактики, чтобы получить наилучшие с точки зрения оптимизации результаты. Во многих случаях дублированные страницы - это такие страницы, которые не имеют ценности ни для пользователей, ни для поисковых движков. Если это именно так, попытайтесь полностью устранить эту проблему. Подправьте реализацию таким образом, чтобы на каждую страницу ссылался только один URL-адрес. Сделайте также 301-й редирект для старых URL-адресов на оставшиеся URL-адреса, чтобы помочь поисковым движкам как можно быстрее увидеть произведенные вами перемены и сохранить тот «сок ссылок», который имели удаленные страницы.

Если сделать это невозможно, то имеется еще много других вариантов. Далее представлена сводка указаний по самым простым решениям для самых разных сценариев:

- используйте файл robots.txt для блокирования пауков поисковых движков, чтобы они не ползали по дублированным версиям страниц вашего сайта;

- используйте элемент rel="canonical" - это второе решение (из лучших) для ликвидации дублированных страниц;

- используйте КОД , чтобы дать указание ПОИСКОВЫМ движкам не индексировать дублированные страницы.

Однако учтите: если вы используете файл robots.txt для предотвращения просмотра страницы, то применение атрибута noindex или nofollow на самой странице смысла не имеет. Поскольку паук не может прочитать эту страницу, то он никогда не увидит атрибуты noindex или nofollow . Помня об этих инструментах, рассмотрим некоторые специфичные ситуации дублированного контента.

- Системы управления контентом, создающие дублированный контент - иногда на сайте есть много версий идентичных страниц. Такое бывает из-за ограничений в некоторых системах управления контентом, которые адресуют один и тот же контент с более чем одним URL-адресом. Обычно это совершенно ненужное дублирование, которое не имеет ценности для пользователей, и лучшее решение- удалить дублированные страницы и сделать 301-й редирект для удаленных страниц на оставшиеся страницы. Если не получится, попробуйте другие способы (приведенные в начале этой статьи).

- Страницы для печати или множество вариантов сортировки - многие сайты предлагают страницы для печати, которые предоставляют пользователю тот же самый контент в адаптированном для принтера формате. Некоторые сайты электронной коммерции предлагают списки своих товаров с множеством возможных сортировок (по размеру, цвету, бренду и цене). Эти страницы имеют ценность для пользователя, но не имеют ценности для поисковых движков, и поэтому будут казаться им дублированным контентом. В такой ситуации необходимо либо использовать один из ранее приведенных в этом блоге вариантов, либо настроить таблицу CSS для печати (как это описано в посте yoast.com/added-print-css-style-sheet/ на сайте Yoast).

- Дублированный контент в блогах и системах архивирования- блоги представляют собой интересный вариант проблемы дублированного контента. Пост в блоге может появиться на нескольких разных страницах: на начальной странице блога, на странице пермалинков этого поста, на страницах архива и на страницах категорий. Каждый экземпляр поста представляет собой дубликат остальных экземпляров. Очень редко издатели пытаются справиться с проблемой присутствия поста как на домашней странице блога, так и на странице пермалинков. И, по-видимому, поисковые движки достаточно хорошо справляются с этой проблемой. Однако, возможно, есть смысл показывать на страницах категорий и архива только фрагменты постов.

- Генерируемый пользователями дублированный контент (повторные посты и т. д.) - многие сайты реализуют структуры для получения генерируемого пользователями контента, такие как блоги, форумы или доски объявлений. Это могут быть отличные способы разработки большого количества контента с очень низкой стоимостью. Проблема состоит в том, что пользователь может одновременно опубликовать один и тот же контент и на вашем сайте, и на нескольких других сайтах, что и приводит к появлению дублированного контента. Контролировать это сложно, но для уменьшения проблемы можно учесть следующее:

- нужно иметь четкую политику, которая уведомляет пользователей о том, что поставляемый ими на ваш сайт контент должен быть уникальным и не может быть размещен на других сайтах. Конечно, добиться этого трудно, но это поможет понять ваши ожидания;

- реализуйте ваш форум таким уникальным образом, который потребует иного контента. Дополнительно к стандартным полям для ввода данных добавьте также некие уникальные поля (отличающиеся от других сайтов), которые будет полезно видеть посетителям вашего сайта.

HTTPS-страницы - если вы используете протокол SSL (шифрованный обмен между браузером и веб-сервером, который часто применяется для электронной коммерции), то на вашем сайте есть страницы, начинающиеся с HTTPS : (вместо HTTP :). Проблема возникает тогда, когда ссылки на ваших HTTPS-страницах указывают на другие страницы сайта с использованием относительных, а не абсолютных ссылок (так что, например, ссылка на вашу домашнюю страницу становится https://www.ВашДомен.com вместо http://www.ВашДомен.com).

Если на вашем сайте имеется такая проблема, то для ее решения вы можете использовать элемент rel="canonical" или З01-е редиректы. Альтернативное решение- изменить ссылки на абсолютные: http://www.ВашДомен.com/content.html вместо /contenthtml), что заодно несколько усложнит жизнь тем, кто ворует ваш контент.