I tidligere innlegg har jeg nevnt zfs en rekke ganger. Videre viste det seg at det ikke krever barnlig både minne og en prosessor. Spørsmålet gjenstår - og hvorfor? Jeg må si med en gang at jeg ikke later som om jeg er fullstendig, osv. Hva som er zfs, finnes i Wikipedia. Hvis du er mer interessert, anbefaler jeg deg å google zfs administrasjonsveiledning(det ser ut til å ha vært på russisk). Min intensjon er å forklare hvorfor plutselig et filsystem på bedriftsnivå er hjemme. Ca. Leseren, spesielt den andre delen av innlegget, forventes å ha en trygg forståelse av for eksempel diskarrays. RAID5. Hvis det ikke er forståelse, er det neppe verdt å bygge slike matriser hjemme og lese denne teksten.

1. Filsystemets integritet... Alle har møtt en situasjon der filsystemet måtte repareres. Vellykket eller ikke veldig vellykket. zfs er bygget på en slik måte at den ikke en gang har et verktøy som Windows chkdsk eller Linux fsck. En situasjon der filsystemet havnet i en inkonsekvent tilstand er rett og slett umulig. Implementert gjennom Copy-on-write (vi skriver ikke data over de gamle, men velger en ny blokk, skriver der, hvis alt er i orden, erstatter vi pekeren fra de gamle dataene til de nye. For mer informasjon, se Google). Som et resultat vil ikke den logiske strukturen på disken forverres på grunn av at noe ble slått av på feil tidspunkt eller lyset ble kuttet av. Vel, med mindre det som ble spilt inn de siste 10 sekundene, vil gå tapt. (platen kan imidlertid fysisk svi ut når du spiller med strøm).

2. Sørg for at du ikke leser søppel og tenker at du leser data... Jern er ufullkommen. For eksempel, hvis kontaktene på SATA-kablene rasler, blir noe helt annet enn det som var i minnet skrevet til disken. Og ingen, bemerker jeg, vil vite om det lenge. Min yrkeserfaring er knyttet til trykkeribransjen. Mer enn en gang var det nødvendig å se et bilde opp til midten av et normalt ved utgangen - og deretter støy. zfs lagrer sjekksummen med hver datablokk. Når du leser dataene, matches beløpet automatisk. Det virker så enkelt ...

3. Tillit til at de lagrede dataene ikke er råtne... Ja, data har en tendens til å forverres under lagring. Noe som er godt kjent for de som har trodd på markedsføringen av 100 år gamle DVD-produsenter og spilt inn arkivene sine på dem. Dette er spesielt viktig for "kalde" data som har vært urørlige i lang tid. Arkiv, gamle bilder osv. Det ser ut til å være enkelt å sjekke dataene - du må lese dem og sammenligne kontrollsummen. For zfs er det klart - det er nok å lese filene. For regelmessige kontroller er det et team som sjekker alt i bakgrunnen.

4. Øyeblikksbilder av filsystemet. Enkel å huske tilstanden til filsystemet på et gitt tidspunkt, lagre slike øyeblikksbilder og rulle tilbake til dem om nødvendig. Beskytter mot tåpelige menneskelige handlinger. Copy-on-write-modellen bidrar ganske enkelt til en slik funksjonalitet - vi slipper ganske enkelt ikke blokker med slettede eller overskrevne data, men vi lagrer lenker til dem i et øyeblikksbilde. Som et resultat tar øyeblikksbildet så mye plass som det inneholder endrede data sammenlignet med nåværende øyeblikk, og ikke hele datamengden.

Alt var for data uten redundans, for eksempel en enkelt disk. Men zfs lar deg danne overflødige matriser, lignende (og bedre enn) RAID1 (speil), RAID5 (redundans i størrelsen på en disk), RAID6 (to), og til og med "RAID7" (som beholder data hvis noen tre disker i matrisen svikter). Arrays kan kombineres for å lage noe som RAID10 eller RAID50. Og hvorfor er zfs arrays bedre?

5. Maskinvareuavhengighet... For å lage hardware RAID5, spesielt RAID6, trenger du en dyr RAID-kontroller. zfs raidz er et programvare-RAID-alternativ, bare diskadgang er nødvendig, for eksempel SATA-porter. zfs raidz kan godt være bygget på porter til forskjellige kontrollere og fra disker av forskjellige modeller (det er fordeler og ulemper ved å bruke forskjellige diskmodeller). Og overført til nesten hvilken som helst maskinvare hvor du kan koble til disker. For eksempel byttet jeg gjentatte ganger disker mellom SATA-porter, importerte gjennomsiktig en matrise opprettet i IDE-modus på kontrolleren, i ACHI-modus og på SAS-kontrolleren. Selv om operativsystemet nummererer disker etter porter og definerer IDE-, ACHI- og SAS-disker på forskjellige måter, er zfs i stand til å jobbe alt dette lydløst (opp til visse grenser, selvfølgelig. Dumt kan det brytes.)

6. Fravær Opptakshull... (Wiki) Det vil si datadestruksjon hvis arraydisken ikke kan motta data. Dyrt RAID-kontroller er utstyrt med batterier, som lar mange dager lagre data som ikke hadde tid til å komme til disken, og skrive det til matrisen når det er mulig.

7. Diskfeil motstandsdyktighet... Anta at vi har samme RAID5 og zfs raidz1. I hver av dem mislykkes en av diskene, vi endrer den til en ny. Og under erstatningsprosessen (og det tar mange timer for store matriser) blir det ikke lest en blokk på en av de gjenværende diskene i matrisen.

For RAID5 er dette i de fleste tilfeller en katastrofe. Matrisen er erklært feil som uleselig, vi fører den til fagpersonene, som vil gjenopprette informasjonen for et engangsbeløp.

For zfs raidz1 forteller den hvilke filer de dårlige blokkene falt på, resten er synkronisert. Og hvis i det minste noe leses fra disken som byttes ut og den ikke kobles fra datamaskinen, vil informasjonen fra den også brukes til synkronisering. Og med stor sannsynlighet vil vi ikke miste data i det hele tatt.

8. Arbeider med nyttelast, ikke hele matrisen... Hvis jeg for eksempel bytter ut en disk i et RAID5-utvalg, avhenger gjenopprettingstiden av størrelsen på matrisen. Hvis i zfs raid1 - fra mengden informasjon som er skrevet til matrisen, blir ikke plassen som ikke brukes til data, synkronisert.

Det er fortsatt mange fordeler, men disse er mer interessante for meg for huset. I bedriftsapplikasjoner er det andre (datakomprimering, deduplisering ...). Jeg vil nevne de viktige for meg begrensninger.

1. Det er umulig å dyrke et raidz-utvalg på en disk... Du kan erstatte alle terabyte-disker med tritere - og øke volumet. Du kan bygge en annen raidz fra 3 (eller flere) disker og legge den til den eksisterende. Men du kan gjøre raidz1 fra 5 disker til raidz1 fra 6 bare ved å tømme informasjon et sted, ødelegge matrisen og opprette en ny.

2.Array kan ikke reduseres... Du kan bare øke. For eksempel er det mulig å erstatte terabyte skruer med to terabyte skruer i matrisen. Og på halv terabyte - det er umulig, selv om 1 kilobyte informasjon er lagret i matrisen.

Du kan koble en til matrisen - men du kan ikke koble fra. Alle slike prosedyrer - bare ved å lagre informasjon et sted utenfor, ødelegge matrisen og opprette en ny.

3. Ressursintensitet... zfs beregner kontinuerlig sjekksummer, noe som skaper belastning på prosessoren og spiser minne for cacher. I bedriftsapplikasjoner er det en mening - gigabyte minne per terabyte array. Hjemme er 330 atomer og 4 GB minne nok for meg (og tidligere fungerte det for 2 GB - jeg så ikke mye forskjell). Selv om jeg ikke har nok atom for fullstendig bruk av et gigabit-nettverk, dekker 40-50MB / s mine behov .. Men hvis maskinvaren er gammel og til og med mye svakere - er zfs ikke noe for deg.

Ja, jeg vil minne deg om at hvis du likte det - inn NAS4fri, som hele innleggssyklusen er viet til, NAS-ledelse, inkludert operasjoner med zfs, går gjennom et webgrensesnitt som er forståelig for en nybegynner.

I gjennomsnitt vises et nytt innlegg om NAS omtrent hver sjette måned, og snakker om hvordan du installerer systemet i henhold til dokumentasjonen. Vi vil komplisere oppgaven ved å knytte den til et reelt prosjekt og begrense budsjettet. I tillegg vil vi også prøve å spre sugerør for oss selv de stedene der den unge sysadminen ennå ikke har satt sin fot, og vi vil også ødelegge flere bransjemyter.Denne artikkelen er ikke for profesjonelle serverlagere, spillere eller andre overklokkere. For deg, kolleger, og så fungerer hele bransjen. Det er for nybegynnere, UNIX-entusiaster og fri programvareentusiaster. Alle har samlet gammelt jern. Alle trenger å lagre store volumer hjemme eller på kontoret. Men ikke alle har lett tilgang til serverteknologi.

Jeg håper virkelig at du vil finne noen nyttige ideer til deg selv og likevel lære av andres feil. Husk: systemet koster ikke så mye som du betalte for maskinvaren, men hvor mye tid og krefter du vil investere senere i testing og drift.

Hvis du ikke vil lese, se lenker og konklusjoner på slutten; kanskje du vil ombestemme deg.

FRASKRIVELSE

Informasjonen blir gitt av AS-IS uten ansvar for bruk av noen, hvor som helst, noensinne. Alle utilsiktede nevnte varemerker tilhører deres respektive eiere. Noen av dem trenger ikke lenger annonsering så mye at jeg kommer med tegneserienavn til dem.Anerkjennelser

Respekt for Andrey Alexandrovich Bakhmetyev, ingeniør og oppfinner. Jeg er stolt over at Andrei Alexandrovich underviste for meg på instituttet! Jeg ønsker ham lykke til i prosjektene!En oppgave

Så det er en liten bedriftsoppstart som genererer omtrent 50 GB filer per uke, med behov for å arkivere dem i flere år. Filene er store (ca. 10-20 MB hver) og kan ikke komprimeres av konvensjonelle algoritmer. Det opprinnelige datavolumet er omtrent 2 TB. Svært gamle data kan lagres frakoblet, koble til etter behov.Du må møte en veldig beskjeden det opprinnelige budsjettet til løsningen er 500 euro(i prisene sommeren 2013) og to uker for montering og testing .

For disse pengene må du bygge et system som lar en liten gruppe jobbe med filer i samme lokale nettverk fra forskjellige plattformer (Windows, Mac OS). Krever langsiktig arbeid uten sysadmin på nettstedet, feilbeskyttelse og grunnleggende funksjoner for.

Tradisjonelle måter

Selvfølgelig kan du kjøpe nettverkstilkoblet lagring: NetApp, QNAP, Synology og andre spillere lager dem, og dessuten gjør de det bra, selv for små bedrifter. Men € 500 er bare begynnelsen på en samtale for en tom boks, uten selve platene. Hvis du har 1000-2000 euro, er det bedre å kjøpe et ferdig produkt, og vi vil prøve å betale så mye som mulig med kunnskap og i det minste - med tid og penger.UPD (spoiler rev. 2 fra 2014-03-08):

Hvis du samler fra nytt jern, ikke fra søppel

Basert på totaliteten av dette innlegget og dets kommentarer, vennlig levert av samfunnet, foreslår jeg følgende algoritme for en enkel fire disker systemer:

- Hvis den doble størrelsen på den største tilgjengelige diskmodellen ikke er nok for de lagrede dataene, må du slutte å lese spoileren (eksempel: 4TB-modell, du må lagre 7TB data, og fortsett; hvis du trenger å lagre 10TB, så stopp)

- Vi velger et produkt fra MicroServer-linjen til den velkjente produsenten av servere Harlampy-Pankrat; f.eks. n36l, n40l, n54l, med fire drivbuer (det viktigste er å ha støtte for ECC-minne)

- Sørg for å fullføre serveren vår med minne paritetskontroll (ECC) med en hastighet på 1 GB for hver 1 TB lagrede data, men ikke mindre enn 8 GB (i henhold til FreeNAS anbefaling for disker opptil 4 TB, viser det seg bare 8 GB)

- Hvis vi ikke har ECC-minne, slutte å lese denne spoileren umiddelbart, vi leste innlegget til slutt

- Vi velger produsent stasjoner som bruker en oppdatert feiloversikt; for eksempel denne: http://habrahabr.ru/post/209894

- Vi velger billig linje SATA-stasjoner med obligatorisk tilstedeværelse av ERC, og hvorfor, vi leser her: http://habrahabr.ru/post/92701

- Vi velger kapasitet disker (2TB, 3TB eller 4TB) på bakgrunn av at det blir fire, og at bare halvparten vil være tilgjengelig for data (andre halvdel for RAID-redundans)

- Før du kjøper, sjekker vi nok en gang nøye og grundig kompatibiliteten til maskinvaren med hverandre, antall spor, brett, braketter og andre ting, men for FreeNAS er det viktigste å støtte all maskinvare med den nåværende FreeBSD-kjernen

- Velge en god oppstartbar flash-stasjon ved å lese fortsettelsen på dette innlegget (del 2: gode minner)

- Vi kjøper, puster inn aromaene til nytt jern, monterer, kobler sammen, lanserer; kreves for ZFS slå av alle maskinvare-RAID-er

- Lag et volum RAIDZ2 av fire disker, alltid med dobbel redundans (på en volumstørrelse på ca 12 TB er det en risiko for å møte en ond URE, les om den i dette innlegget. Hvis vi ikke er redd for URE og fortsatt samler RAIDZ på fire disker, sjekker vi størrelsen på den fysiske sektoren - på moderne disker er det 4KB, og i dette tilfellet vil det vise seg en helt latterlig 43Kb-stripe, som også vil slippe hastigheten på arrayet: forums.servethehome.com/hard-drives-solid-state-drives/30-4k -green-5200-7200-spørsmål.html)

- Tilsett salt, sukker, pepper, fengsel, baller, manus og lignende rømme etter smak

Men hva med skylagring, du spør? I skrivende stund ser populær skylagring for volumene våre dyrere ut enn vi ønsker. For eksempel vil kostnaden for å lagre en ubegrenset mengde data i 36 måneder på den velkjente tjenesten Drop Box koste mer enn et par tusen dollar, selv om du kan betale dem gradvis. Selvfølgelig er det tjenester som Amazon Glacier (takk AM for hintet) eller Openwork Windows, men for det første tar de ikke bare lagring, men også sirkulasjon (hvordan beregner man det på forhånd?), Og for det andre, la oss ikke glemme det virksomheten sitter på en 10Mbit internettopplinking, og terabyte-manøvrer vil ikke bare kreve visse anstrengelser for å administrere prosesser, men vil også være veldig kjedelige for brukerne.

Vanligvis, i slike tilfeller tar de en gammel datamaskin, kjøper store disker, installerer Linux (ikke nødvendigvis, noen konstruerer Windows 7), lager et RAID5-utvalg. Utmerket. Alt fungerer bra i omtrent seks måneder eller et år, men en solfylt morgen forsvinner serveren plutselig fra nettverket uten advarsel. Selvfølgelig har sysadmin jobbet i et annet selskap i lang tid (personalomsetning), det er ingen sikkerhetskopi (volumene er for store), og den nye sysadminen kan ikke fikse systemet (samtidig er det verdt skjeller ut den gamle sysadminen og Linux YYY dialekten, fordi han måtte bruke Linux ZZZ, da ville det definitivt ikke være noen problemer). Alle disse historiene gjentar seg lenge og på samme måte endres bare OS-versjoner og datavolumene vokser.

Bransjemyter

RAID5-myten

Den mest utbredte myten, som jeg selv trodde på inntil nylig, er at den andre påfølgende svikten i en rekke i praksis ikke kan være, ifølge teorien om sannsynlighet. Og her kan det, og hvordan! La oss simulere en reell situasjon: serveren jobbet i et par år, hvoretter en disk i matrisen mislykkes. Så langt er det greit, vi setter en ny plate, og hva skjer? Ja, array rekonstruksjon, dvs. langvarig maksimal belastning på allerede utslitte plater. I en slik situasjon er feil veldig mulig og oppstår.Men det er ikke alt. Det er også den metodiske sannsynligheten for en lesefeil, fastlagt av produsenten, som under visse omstendigheter nå praktisk garanterer at RAID5 ikke blir satt sammen etter en disksvikt.

Terabyte-myten

Du kan selvfølgelig betrakte alle diskprodusenter som nybegynnere, men en bransjespesifikk kilobyte de har tatt i bruk er 1000 byte, strengt i henhold til SI-systemet (den andre kilobyten, faktisk siden 1998, har blitt kalt kibibyte og betegnet KiB). Dette er imidlertid ikke alt. Faktum er at alle produserte spindelskiver har defekter som allerede er oppdaget på fabrikken, hvor antallet er tilfeldige, og at den faktiske tilgjengelige størrelsen "går". For budsjettmodeller går han selv innenfor samme serie med identiske produkter, både oppover og nedover. I mitt sett med fire identiske 2TB-disker viste to seg å være omtrent 2 GB mindre, og de to andre - omtrent 400 MB mer enn det nominelle volumet. De. en kilobyte, som en sinus i krigstid, varierer fra 999 byte 6 bits til ærlige 1000 byte, selv med en napp i slutten. Enten blir produktene levert til oss på markedet med utette ubåter, eller så er flommen skylden, men bitene forsvinner et sted.Ikke undervurder denne faktoren: Hvis erstatningen av en mislykket disk i matrisen viser seg å være minst en blokk kortere enn den nominelle størrelsen, kan det hende at den nedbrutte RAID-arrayet, teoretisk sett, ikke blir samlet inn til den optimale tilstanden, og vi vil få hodepine som lett kunne vært unngått i begynnelsen. Basert på dette betyr ikke mer bedre, det viktigste er konsistens.

Jeg antar at produsenter av serverutstyr løser dette problemet ved alltid å lage en teknologisk reserve og samtidig kunstig undervurdere mengden ledig plass i diskens firmware, derfor, i henhold til en viss produktkode, kan de alltid (innenfor rammen av support) få en disk som har samme kapasitet ... Dette er sannsynligvis en av grunnene til at Seagate-disken under det kjente servervaremerket Harlampy-Pankrat og dens "søsken" uten den ikke er akkurat det samme produktet. Men dette er bare min gjetning. Kanskje lederne på lagringsmarkedet har flere teknologiske trumfkort i ermene.

Prosjektrisiko

I ethvert prosjekt er det viktig å forstå risikoen, for til slutt bygger vi ikke for moro skyld, men for forretningssuksess. For å oppnå harmonien i Krepsondo (beklager, forretningskontinuitet) bygger vi først en forenklet risikomodell som tar hensyn til sannsynlige forstyrrelser og deres konsekvenser.Maskinvare

På et budsjett har vi ikke tilgang til serverutstyr, så både disker og kontrollere kan bare brukes billige, og dette er et territorium med spontane feil ut av det blå. Maskinvarerisiko inkluderer: mekanisk slitasje (spindelplater, vifter), elektrisk slitasje (spesielt for flashminne), feil i fastvaren til en disk eller kontroller, strømforsyning av dårlig kvalitet, disker av dårlig kvalitet, smuldrende RAID-maskinvare. Mangelen på reservedeler til enheten (reservedeler) som selges på grunn av foreldelse kan også betraktes som en risiko.Programvare

Programvarefeil inkluderer problemene med standardoperativsystemer, som har en tendens til selvdestruksjon og ikke den beste evnen til å helbrede seg selv etter strømbrudd, og som krever regelmessig administrasjon. La oss her legge til feil i rekonstruksjon av en RAID-array-programvare, feil i kontrollerdrivere, brukerhandlinger (forsettlig og utilsiktet), handlinger med skadelig kode.Tilgjengelig jern

Den gamle datamaskinen min fra rundt 2004 var tilgjengelig. utgivelse på et Socket 478 GA-8IPE1000MK hovedkort, med Pentium 4 @ 3GHz CPU og 1 GB RAM. ZEUS er skrevet på saken, den har så mange som seks interne rom 3,5 "(da er det mye), ett 3,5" for den arkaiske FDD, fire 5,25 ", to steder for kjølevifter og en 250W strømforsyning. ATI RADEON 8500-skjermkortet pleide å gjengi slike treff som Soldiers of Anarchy, men den oljebærende viften har lenge hylt som Baskervilles hund (selvfølgelig når den i det hele tatt snurrer). CPU-kjøling ble løst av Zalman CNPS5700D-Cu, som sugde oppvarmet luft fra varmeavlederen og blåste den ut gjennom en eksentrisk kanal inn i saken, hvorfra den måtte blåses ut igjen med en ny vifte.En dag ble jeg så lei av hele flyplassen at jeg bestemte meg for å kutte den bokstavelig talt: Jeg tok en elektrisk sag og kappet ut et rundt hull i saken (langs viftegrillen), og utvidet luftkanalen med et stykke plast flaske under Karma Doma mineralvann. Jeg fjernet den andre viften og reduserte hastigheten til den første (på CPU) reostat.

I en så litt punkform har hele denne materielle delen vært trist på sokkelen den dag i dag.

Å komplettere mitt kabinett av nysgjerrigheter var et hull på baksiden av saken på grunn av den gratis tolkningen av ATX-standardene fra produsenten av saken: det viste seg å være umulig å kjøre dekkpanelet dit uten fil, og jeg forlot saken. disse forsøkene.

Hovedkortet hadde en RAM-kontroller som ikke tillot å bytte parentes i STANDBY-modus (dette er når datamaskinen er slått av med knappen, men strømforsyningen er på). Det er til og med en spesiell LED-indikator RAM_LED, hvis oppgave var å advare sysadmin om tilstedeværelsen av spenning i kretsen:

Når RAM_LED er PÅ, ikke installer / fjern DIMM fra kontakten

Selvfølgelig, til slutt, ble kontrolleren dekket; og hvis du ikke flyttet minnet i kontakten på en bestemt sjamansk måte, så ikke hovedkortet det og begynte å knirke motbydelig. I squeak-katalogen kan dette signalet bety både et RAM-problem og et strømforsyningsproblem, noe som var helt forvirrende. For å fullføre bildet opprettet BIOS et spesielt skjevt miljø når jeg startet fra flash-stasjoner, og derfor startet jeg kategorisk ikke alle SYSLINUX-derivater (for referanse: dette er nesten ingen alternativ bootloader for CD / flash-stasjoner for et stort antall Linux varianter).

Så hvorfor gjør jeg dette?

Konklusjoner:

- En slik datamaskin er helt uegnet for en serveroppgave.

- Sex med gammel maskinvare er kategorisk kontraindisert for unge sysadminer.

Ideer

Utskifting av jern

Selvfølgelig passer ikke buggy-moren, den utslitte mekanikken og den gamle strømforsyningen i Krepsondo-filosofien (å, beklager igjen, forretningskontinuitet), og må derfor erstattes først og fremst og uten videre diskusjon. Harmonien i Krepsondo er viktigere for oss, så la oss si farvel til det gamle jernet, det har oppfylt sitt historiske oppdrag.Valget av erstatning for Socket 478 viste seg å være begrenset: ASRoсk P4i65G. Det ser ut til å være en god mor med grafikk ombord, tre PCI, to SATA og seks USB ombord. Maskinvareovervåking er basert på Winbond W83627 (støttes i lm-sensorpakken; senere viste det seg å være nyttig når du kalibrerer vifteheostaten i henhold til CPU-temperaturen til et løpende system).

Nå piper ingenting, lasting fra flash-stasjoner fungerer bra, noe som allerede er behagelig. Ombord hundre megabit for NAS-nettverket er ikke nok, så ett PCI-spor er umiddelbart opptatt av budsjettet D-Link DGE-530T, to PCI-er igjen til diskkontrollere. Vanligvis har de opptil fire porter, som sammen med to innebygde gir oss muligheten til å koble til ti stasjoner.

Jeg vil fortelle deg om den nye strømforsyningen senere, for nå bemerker jeg bare at 250W var nok for mitt Socket 478-baserte system. Derfor, etter å ha estimert kraftreserven på 200 W for spinning av spindelskiver, gikk jeg umiddelbart med på budsjettkilden FSP Group ATX-450PNR med en nominell verdi på 450 W som ble tilbudt meg i butikken. Overfladisk likte jeg den store 120mm-viften med lav hastighet, noe som betyr at det vil være mindre støy (UPD: ser fremover, ATX-450PNR, til tross for alle triks, taklet ikke oppgaven for hånden, og jeg anbefaler ikke å bruke det; se habrahabr.ru/post/218387).

Samtidig tok jeg tak i et par Zalman ZM-F1-FDB-vifter på et fasjonabelt hydrodynamisk lager: den første vil gå til CPU-kjøleren, den andre som blåser den første gruppen disker.

Egentlig gjenstår det å velge det viktigste.

Diskundersystem

Den viktigste oppgaven for NAS er valget av array (RAID) -modus. Siden budsjettet til løsningen ikke tillater oss å bruke serverutstyr, sukker vi og setter straks hardware RAID-kontrollere, SAS og andre Fibre Channel til side. Vi legger bort solid state-stasjoner der også. Siden vi har NAS på kjøkkenet vårt (beklager ordspillet), vil en tornete sti passere gjennom den magiske verdenen programvare RAID-løsninger basert på billige SATA-spindelstasjoner... Det er mye mer underholdende, men la øvelsene i Krepsondo hjelpe oss.Skiver

Etter min subjektive mening er SATA-produkter (sammenlignet med SAS / FC) med valget fortsatt mer forvirrende og mer blandet med markedsføring. Jeg så to konvensjonelle prisklasser for Seagate spindelstasjoner, som avviker med omtrent 40%. Den øvre regnes som en løsning for mellomstore bedrifter, og den nedre er for hjemmebrukere og småbedrifter. Hva er trusselen om å bruke de billigste platene? I følge de subjektive estimatene fra noen eksperter (link), svikter billige disker betydelig oftere enn dyre i den første driftsuken, og trenden fortsetter i løpet av året. Etter å ha gitt denne tabellen nøye her, gjentar jeg at dette er en veldig tilnærmet subjektiv vurdering av en av Internett-brukerne, uten å spesifisere spesifikke produkter:Ifølge samme bruker mislykkes omtrent en eller to av et dusin ett år gamle SATA-stasjoner i sitt andre år. Det sier seg selv at alle SATA oppfører seg merkbart dårligere enn SAS eller Fibre Channel, det kan man nesten ikke argumentere for. Som og med det tildelte budsjettet, noe som etterlater oss nesten ikke noe valg.

Jeg valgte Seagate ganske intuitivt, så jeg vil ikke beskrive denne prosessen.

OPP:

Siden hendelsene som ble beskrevet fant sted sommeren 2013, leste jeg ikke dette fantastiske innlegget: http://habrahabr.ru/post/209894/. Det følger at Seagate ikke er det beste valget, men leseren er absolutt nå varslet og bevæpnet. Takk habrocommunity, du er best!

Etter å ha analysert tilbudene i butikken flytende, bemerket jeg at prisen på budsjett 4TB-disker er nesten 90% høyere enn tilbudene på 2TB, dvs. enhetskostnaden for lagring av gigabyte vokste nesten lineært med volum. Hvorfor er dette så viktig? Faktum er at jeg ikke kunne finne en kontroller for PCI-bussen med garantert støtte for 4TB-stasjoner, og det var ingen måte å eksperimentere på. Dette ga et vanskelig valg: enten begrense stasjonene til 2 TB, eller forlate den gamle maskinvaren og bytte til PCI Express-bussen (ved kjøp av en ny datamaskin). Heldigvis er den nesten lineære avhengigheten av prisen på kapasiteten spart fra vanskelige avgjørelser, men jeg anbefaler leseren å alltid vurdere de totale kostnadene for diskundersystemet, fordi det i en NAS er avgjørende, og fordelen med store disker kan oppveie alt ellers.

Jeg likte ST2000DM001-modellen for prisen. Det var det mest budsjettvennlige alternativet i Seagate 2TB-linjen, bruker en ny 4K-sektorstørrelse og krever riktig initialisering (formatering) av filsystemet. Interessant, representanter for ST2000DM001 kommer over med både to og tre plater (på bildet - en variant med to).

Det ser ut til at de nye eierne av FreeNAS-prosjektet sparte ingen anstrengelser for dyp refaktorisering av koden, som sannsynligvis ble gitt på bekostning av å forlate noen "utdaterte" funksjoner (for eksempel RAID5). Uansett ser FreeNAS ut til å være en sterk utviklingsdriver for FreeBSD, og det er en klar interesse for å utvikle ZFS i en freeware-kjerne. Vel, vi ønsker lykke til til kollegaene våre.

Hvis vi sammenligner FreeNAS og dens forfedre NAS4free, så ser FreeNAS for meg subjektivt sterkere ut, til tross for fraværet av RAID5. Det er en viss følelse som ikke er lett å forklare med ord: Gjennom det NAS4frie grafiske grensesnittet blåser fremdeles lukten av kode som krever dyp refactoring ("kode med lukt"). Så hva er dette refactoring? Her er et enkelt eksempel: I motsetning til NAS4free, kan FreeNAS, selv når du kjører fra en flash-stasjon, bruke konfigurasjonsendringer uten å starte systemet helt på nytt. Og dette til tross for at rotsystemet er montert i skrivebeskyttet modus. Dette var et kraftig argument for meg. I tillegg byttet FreeNAS til å lagre konfigurasjonen i SQlite RDBMS, og NAS4free bruker fortsatt et enkelt, men ikke det mest pålitelige XML-format.

RAID5 eller ikke RAID5

Selv om RAID-matriser av UFS og GEOM-programvare ikke er så teknologisk avanserte som ZFS med RAIDZ (ved første øyekast ser det ut til at dette er en konkurranse mellom et sett med sviller mot en kabelstansbro), det er populære RAID0 / 1/5 moduser i GEOM. Imidlertid tillater moderne FreeNAS ikke å lage RAID5-volumer, og for kompatibilitet er bare de enkleste RAID0 (stripe) og RAID1 (mirror) -modusene igjen.Hvorfor det?

Det er sannsynligvis to grunner til dette, la oss kalle dem forenklet: mekanisk og matematisk (selv om de i spindelskiver er sammenflettet som bølgepartikkerdualitet).

La oss forestille oss en feil / erstatning av en disk i et 10 TB array etter to års drift: gjenoppbyggingsprosessen innen en uke (!) Vil plage allerede utslitte spindler (se ovenfor) RAID5-myten). Men med slikt stress kan det hende at gamle disker ikke varer en gang i tre dager, etter å ha slått ned matrisen helt, så begynner stresset med oss, og hva slags stress.

Du spør: hvordan er det, hvorfor en uke for gjenoppbygging? La oss se på representanter for to generasjoner av Seagate Barracuda (ved hjelp av materiale fra http://www.storagereview.com):

Hvis kapasiteten har økt omtrent 8 ganger, er hastighetene bare tre ganger. Ironien er imidlertid at vi på forhånd kan forestille oss hastigheten på RAID1-rekonstruksjon her, og til og med en så rask versjon på vår vintage PCI-kontroller vil ikke være så varm. I RAID5-matriser bestemmes hastigheten generelt av prosessorens matematiske evner, og ifølge forskjellige estimater er det omtrent en dag for hver TB med data (akk, jeg kan ikke gi lenker, beklager).

Men det er ikke alt, kjære leser. Stasjonene har en parameter kalt Unrecoverable Read Error Rate, som på moderne budsjett SATA-modeller er 1 sektor for hver hundre billioner biter. De. ut av hver 12TB innspilte disk, vil det si "beklager, herre, men det er absolutt umulig å gi tilbake den nødvendige sektoren; lesefeil ". Dette er en metodefeil som er fastlagt av produsenten og derfor teoretisk garanterer umuligheten av å rekonstruere et RAID5-array med en kapasitet på mer enn 12 TB på billige disker(For å være rettferdig bemerker vi at URE på SAS-disker er minst en størrelsesorden mindre, og henholdsvis det kritiske volumet er større). Grafskriftet til RAID5 ble skrevet av Robin Harris i artikkelen Why RAID 5 slutter å fungere i 2009.

Basert på utvalget av maskinvare, er den maksimale totale kapasiteten på diskene våre 20 TB (18 TB), så la oss nok en gang minne oss om veien til forretningskontinuitet gjennom den filosofiske fremgangsmåten til Krepsondo, sukk og husk RAID5 sammen.

Endelig valg: sammenleggbar matrise

Så jeg forlater både hardware RAID (dyrt), ZFS (dyrt) og programvare RAID5 (treg og upålitelig). Jeg velger FreeNAS med UFS-volumer basert på GEOM-teknologier: enkel, pålitelig og om nødvendig reparert som en Kalashnikov-overfallsgevær. Hva trenger du.La oss legge til en USB-minnepinne for å starte systemet - vi tildeler spindelplater til data fullstendig. Vi vil ikke at noen ved et uhell trekker ut den oppstartbare flash-stasjonen som stikker ut fra utsiden, så vi velger et budsjett-flash-stasjon med de minste dimensjonene (som det viste seg senere, var det dødelig og tankeløs avgjørelse: http://habrahabr.ru/post/214803/).

Av alternativene Stripe og Mirror velger jeg selvfølgelig Mirror (dvs. RAID1). Det resulterende disksystemet ser ut som et sett med flere uavhengige speilet volumer. Hvert speil er satt sammen fra et par 2TB-stasjoner (kontrollerbegrensning), initialisert og montert uavhengig. Maksimum mengde online lagrede data på ti disker vil være omtrent 10 TB i fem uavhengige volumer (mer presist, 9TiB).

Selv om dette designet kan virke litt vanskelig, er det virkelig berettiget med tanke på datavolumene og antall disker: ellers hadde vi fått en ikke-separerbar monolit med uoverkommelige rekonstruksjonstider i tilfelle feil.

La oss legge til en liten berøring her: siden det brukes billige forbrukerdisker, må du kunstig undervurdere volumet når du lager volumer, slik at du ikke har problemer med å bytte ut mislykkede disker med nye (med en flytende kapasitet på ca. 2 TB). La oss la de teknologiske "halene" være på slutten for bedre søvn.

På gjennomstrømningen av en vogn lastet med streamer-kassetter

Fra arkivlagringssynspunktet bør du ikke være opprørt over kapasiteten i det hele tatt: Vårt utvalg er sammenleggbart. Etter å ha brukt opp den tilgjengelige datamengden som er lagret på serveren online i volum nr. 1-5, kan vi koble fra det eldste volum nr. 1 manuelt, kaste ut diskene, installere to nye 2 TB disk og initialisere et nytt volum nr. 6. De gamle stasjonene kan deretter sendes til en USB-stasjon og kobles til den samme FreeNAS-serveren på forespørsel fra en bedrift, uten å demontere hele kabinettet. Du kan montere dem skrivebeskyttet. Hvis du vil, kan du koble dette til både Windows og Mac. I alle fall, husk: det er bedre å ikke riste den gamle spindelskiven for bagateller, ellers vil magnetisk sand falle fra HDA på grunn av alder.Det er også et interessant scenario med unionfs: Bytt fylte volumer til lesemodus og sett dem "ned" under filsystemet til det "øvre" volumet, så vil det være en illusjon av diskplasskontinuitet. Det er sant at unionfs er en abstrus og derfor farlig ting, og den skrivebeskyttede muligheten er sannsynligvis den eneste mer eller mindre gjennomkjøringen.

Det er det, volumene på arkivlagring er nå begrenset av volumet på et skap eller etuiet der gamle disker er lagret. Hvis denne saken også flyttes i rommet, vil båndbredden generelt gå utenfor skalaen.

Skrogteknikk

La oss tenke litt på primærkjøling, for platene våre ved 7200 o / min vil være lunke. Vi finner et sted for å blåse 3,5 ”-rommene, og med nesten kirurgiske vanskeligheter monterer vi vår Zalman ZM-F1-FDB-vifte der på vibrasjonsdempende gummibånd, som vi må trekke med fingrene gjennom de tynne spaltene. av saken. Fordøm forbrukerbygningene med passasjer og sprekker ...

Jeg husket en gammel komedie.

Soldaten blir spurt: "Hvorfor ser du så ille?" Han svarer: "Vel, det er en øyeoperasjon, men det gjøres gjennom anus, og jeg vil ikke la en eneste mann dra dit" ...

Den eksentrisk grønne plasten fra Karma Doma mineralvannflasken, som stikker ut fra baksiden av saken, har allerede fått mye nummenhet i øynene. Derfor demonterer vi CNPS5700D-Cu-kjøleren, tar luftkanalen med oss og går til matbutikken for å handle. Etter å ha prøvd på flaskene med forskjellige merker av mineralvann i tur og orden, er vi overbevist om at de passer perfekt til diameteren på to-litersflasken Ringing Aqua med den runde delen av luftkanalen CNPS5700D-Cu (de ble støpt på samme måte plante eller hva?).

Vi vil takke Stuck-School-selskapet for så god tilfeldighet, og etter å ha tilbrakt et par timer til med forskjellige skarpe gjenstander, får vi en del av en intrikat formet luftkanal laget av gjennomsiktig plast.

Vi setter en ny 80mm ZM-F1-FDB-vifte inn i kjøligere, dens hydrodynamiske lagre har en sammenlignbar ressurs, men roligere enn de sonore kulelagrene. I siste øyeblikk viser det seg selvfølgelig at hullet på skroget er en halv centimeter høyere enn nødvendig, så vi legger til et kronbladskjørt laget av teip, ideen om ble foreslått av flydesignere av krigere med en variabel trykkvektor.

Produktet vårt ser virkelig ut som en avbøybar dyse, men det ser ikke så punk lenger ut.

Endelig er tiden inne for å takle det stedet der jeg ikke klarte å løse den store kinesiske ingeniørplanen for ti år siden. La meg minne deg på at vi snakker om bakpanelet for ATX-kontakter som følger med hovedkortet, eller rettere sagt om umuligheten av å installere det her i dette sporet:

Det viser seg at rebusen er fullstendig løst med tang, vi bare bøyer profilen rundt omkretsen, centimeter for centimeter. Stikkontakten holder perfekt med hullene på kontaktene, og uregelmessighetene vil gå inn i saken og vil ikke bryte med vår tekniske estetikk:

For å unngå spaghettieffekten tar vi SATA-ledningene til hverandre med bånd, fordi det ikke er noe sted for pasta i serveresaker. Vi merker kablene ved hjelp av markører for tvunnet par. Vi fester vifteheostaten til saken på et ledig hovedkortben som har vist seg å være veldig på plass. De gamle diskene er fremdeles i tilfelle bedre kalibrering av luftstrømmen, men vi blir kvitt dem snart.

Igjen, styrt av hensyn til termisk effektivitet, vil vi sette sammen speiloppsett fra skiver gjennom minst ett rom, dvs. så det disker fra samme matrix viste seg ikke å være naboer i bukter og varmet ikke hverandre, spesielt ved lange gjenoppbyggingsoperasjoner. Vi merker også diskene, i det minste med volumnummeret. OPP: det er også bedre å plassere diskens serienummer ved å skrive den ut på en termobåndskriver, og i fravær av den, bare på en papirstripe under et gjennomsiktig tape. Når det er mer enn to disker, er det veldig nyttig for presserende og akutt arbeid.

Det gjenstår bare å slå på strømmen, måle temperaturen og kalibrere viftereostatene under belastning.

Spørsmål bygg NAS selv eller kjøp ferdige forårsaker alltid holivar i trange sirkler. Her er en fersk artikkel av Kirill Kochetkov Å velge en nettverksstasjon har allerede skapt tre sider med diskusjon. Hva er karakteristisk - helt dedikert til holivar. Kirill IMHO på grunn av den bredeste praksisen kjenner temaet til kjøpt NAS bedre enn noen andre i Runet. Men han anser det ikke som nyttig å diskutere emnet. Jeg må prøve :)

IMHO har spørsmålet i tittelen et veldig enkelt og ikke emosjonelt svar: Annet, avhenger av dine behov og ressurser. Og han får følelser av et forsøk ikke bare på å utstede et universelt svar, men å pålegge dette svaret på alle og alle.

Så, la oss spørre oss selv første spørsmål - hvorfor trenger du en NAS? Og det viser seg at det overveldende flertallet av NAS ikke er nødvendig i det hele tatt. Ja, de kan bruke den - hvis for eksempel en bror, en sønn osv. vil sette opp og gi. Men de vil ikke kjøpe en ny til seg selv (og vil tilpasse den) selv om den gamle forsvinner. De fleste menneskers filmbehov blir dekket av en TV, en vanlig datamaskin og i det mest avanserte tilfellet streamingtjenester, iTunes og Play. For sikkerhetskopiering, hvis det er gjort - med en USB-disk og skytjenester. Så la oss legge til side de som ikke trenger det diskuterte jernstykket i noen form.

Og i resten har vi et mye mindre mindretall som er i stand til å fortelle hvorfor de akkurat trengte NAS. Denne listen fortjener et eget innlegg (som jeg skal skrive neste gang), men foreløpig er det mer nyttig å tenke på denne listen selv. Mest sannsynlig vil listen være uten eksotisk, som alle andre. Last ned torrents, se filmer og lytt til musikk gjennom en mediespiller, smart TV eller HTPC. Sikkerhetskopier datamaskiner og mobile enheter. Lagre hjemmebilder. Da passer både den kjøpte og selvmonterte NAS for deg. Hvis det eksotiske er tilgjengelig (levende eksempler er virtualisering, bruk av spesifikk programvare som ikke er inkludert i leveransen av ferdig NAS) - så er dette et sterkt argument mot selvinnsamling. Ikke at dette er helt umulig på ferdig NAS. Men hvis du trenger virtualisering (hjemme!), Da eksisterer ikke problemet med å montere og konfigurere NAS selv for deg. På samme måte øker tilsynelatende vanlige behov, men i stor skala (ikke et par terabyte, men ti til tjue, videooverføring til forskjellige enheter osv.) Kravene til en ferdig NAS fra enkle hjemmeenheter til avanserte, eller til og med bedriftens. Hev sammen med prisen.

Men antar at du ikke har noe eksotisk. Så kommer inn i bildet ressursspørsmål... hvis du lettere å betale ekstra enn å grave i programvare og maskinvare - velg en ferdig NAS, det er nok av dem. Dessuten er det ikke så mye å betale i tillegg - omtrent prisen på en harddisk for hjemmekonfigurasjoner uten eksotiske. Hvis samle og konfigurere deg selv - for fornøyelse, så gjennomgår vi nøye ønskelisten, prøver å estimere margin for vekst, velger programvare, deretter, i henhold til kravene, maskinvare. Det er i den rekkefølgen, ikke omvendt. Uansett hvilken programvare og konfigurasjon du velger, er det ikke gudene som brenner pottene. Hvis du er i stand til å velge maskinvare for en kontormaskin og plassere en akse der, og også vet hvordan du googler og forstår hva du leser, har du de nødvendige ferdighetene til å lage din NAS. I tillegg til dyktighet trenger du tid. Minst en dag eller to. På det meste, hvis det blir en hobby - så mye du vil. Hvis tidsressursen er kritisk, går vi tilbake til det kjøpte alternativet igjen.

PS Som du kan se, er det ikke noe sted for holivar i selve valget. Det er i de psykologiske aspektene, som vi ikke vil diskutere her. Med ett unntak. Nesten alltid i starten er det en erstatning av begreper. Og i stedet for å sammenligne epler med epler, og ananas med ananas, er det en sammenligning av epler med ananas.

For noen år siden for jern selvmontert NAS betydde x86-plattform og grunnleggende hylle er ARM. Selvfølgelig spiser ARM mindre, varmer opp mindre og er mye svakere i ytelse. Men de siste årene har det blitt mulig å bygge videre på ARM også. På nyttårsaften kjøpte jeg for eksempel på Avito for 2500 + 300 + 300 + 200 = 3300 rubler + strømforsyning + etui + SD-kort, jeg fant i USB-lagringsboksen en boks for HDD, til overs fra kjøpet av en ekstern stasjon til en pris som er lavere enn den interne av samme modell. Jeg la en gammel en og en halv terabyte disk i esken, som ble unødvendig i en mediespiller med en NAS. Konfigurert nas4free (med zfs!), Inkludert en robot for automatisk nedlasting av nye episoder av TV-serier og for overføring av bilder frem og tilbake gjennom varme mapper, dvs. på en måte som er forståelig for husmoren. Og jeg tok slektningene mine til en annen by. Oppetid nærmer seg 5 måneder.

På samme måte trenger en ferdig NAS i dag ikke være basert på en svak prosessor - hvis belastningen av en eller annen grunn er over gjennomsnittet, er valget bredt nok. Så det er ikke et spørsmål om hvor mye energi den bruker, eller om det er nok ytelse i det avgjørende valget. Med mindre saken er eksotisk, kan begge alternativene oppfylle kravene.

Av programvare 99,99% av NAS-butikken er Linux-baserte bygg. Og i selvmontering kan du velge minst Win, fra Windows 7 innebygd standard, renset for alt søppel til Win Server 2016 Tech Preview, til og med * nix i hele sitt mangfold, fra Linux til FreeBSD og Solaris. Men er det en komparativ fordel? IMHO nesten ikke. For hvis programvarefunksjonaliteten til en kjøpt NAS ikke er nok for deg, har du heller uvanlige krav.

PPS UPD om spørsmålet du sannsynligvis vil stille - hvilken versjon har mer funksjonalitet?

IMHO - det samme, og det praktisk, det teoretisk.

Praktisk talt: du trenger ikke all funksjonalitet, men bare den du bruker. Og alt unntatt eksotisk i alle varianter er.

Teoretisk sett: en hypervisor støttes av tilstrekkelig kraftig maskinvare i både ferdige og selvmonterte NAS. Følgelig kan du sette Xpenology i en virtuell maskin på en selvmontering. (Dette er lovlig, fordi dette er en samling av koder publisert under GNU-lisensen. Synology hevder forresten ikke det motsatte.) Og å ha all funksjonaliteten som er i DCM og som ikke finnes i vertssystemet. På samme måte - tvert imot, vi legger noe på en ferdig NAS til en virtuell maskin - og fortsetter. Så det eneste spørsmålet er maskinvare, lese - om penger. denne tilnærmingen løser selvfølgelig ikke problemet med noen skytjenester fra NAS-produsenter. Men hvis (!) Du trenger dem, er det neppe noe unikt blant dem at det ikke er noen erstatning. De. igjen om penger. Og små.

Denne lille opplæringen vil hjelpe deg med å bygge en fullverdig NAS-server fra en gammel datamaskin. Hvis du er klar til å kjøpe nye komponenter og gjøre filoppbevaringen kompakt og gi den et mer moderne utseende og funksjonalitet, er artikkelen mer passende for deg. Vel, for de som liker ferdige løsninger, har jeg forberedt dette materialet:... La oss nå gå tilbake til den gamle PC-en og evaluere dens evner.

Gamle PC-krav

- SATA-kontakter på hovedkortet, siden harddisker med dette grensesnittet har det beste pris / ytelsesforholdet og har et mye større volum, i motsetning til IDE-harddisker.

- Antall kontakter for tilkobling av harddisker på hovedkortet og ledige spor i saken (muligheten til å installere HDD i 5,25-tommers brønner (spesialbokser)) For å montere HTPC bruker jeg slike bokser med 2 spor for 2,5 "HDD .. .

- Hvis det ikke er nok SATA-kontakter på strømforsyningen, kan du bruke spesielle IDE-SATA-adaptere.

Fremgangsmåten for å installere harddisken i saken

For å installere 3,5-tommers harddisker i 5,25-tommers optiske stasjonsbrønner, plasser dem i en spesiell ramme (se figur).

Slike tilfeller kan også lages i form av skinner som er festet til harddisken på begge sider.

Du kan også bruke den fem-tommers brønnen der den optiske stasjonen er installert, siden det ikke lenger er nødvendig i en serverløsning.

Installere programvaren

For å implementere en serverløsning, bruker vi programvare FreeNAS... Last ned ISO-bildet fra lenken for et 32-biters eller 64-biters system og brenn med minimumshastighet til en CD-R \ RW-plate. Hvis det ikke er noen plate, kan du installere den på en USB-flashstasjon. Hvordan lage en oppstartbar USB-flashstasjon er skrevet inn. Koble stasjonen midlertidig til PCen (som du fjernet tidligere eller bruk en USB-stasjon). Gå til BIOS og sett Boot-delen til å starte fra diskettstasjonen. Etter at du har installert programvaren og startet PCen på nytt, husk IP-adressen som vises på skjermen.

Sette opp en NAS-server

Koble NAS-serveren til nettverket ditt. Åpne nettleseren til arbeidsdatamaskinen din på dette nettverket og skriv inn adresselinjen: http: // "IP-adressen til din NAS". I vinduet som vises, skriv inn brukernavnet - admin og passordet - freenas. Gå til menyen «Oppbevaring | Volum | Opprett volum " og velg harddiskene som skal danne RAID-arrayet. Deretter aktiverer du ZFS-filsystemet.

Kan bli brukt:

- RAID 0- disk array med økt ytelse, uten feiltoleranse.

- RAID 1- speilet disk array, har høy pålitelighet

Vi vil bruke RAID 1 ettersom den er mer pålitelig. Trykk nå "Legg til volum" for å formatere stasjonene dine i en matrise.

Tilgang til NAS-serveren i det lokale nettverket

For å åpne tilgang til serveren, gå til menyen «Tjenester | Kontrolltjenester ", aktivere CIFS-tjenester og konfigurere tilgang i seksjonen «Deling | Windows-aksjer "... Som med alle nettverksmedier i et lokalt nettverk, utføres tilgang ved hjelp av Windows Utforsker (for eksempel \\ NAS for å få tilgang til roten eller \\ NAS \ Photos for å få tilgang til en bestemt delt mappe). Du kan også opprette snarveier ved å klikke på "Kart nettverksstasjon" -knappen i datamaskinvinduet (Windows 7) under oppdagelseslinjen.

P.S. Du kan alltid lage en ekstra matrise ved å legge til harddisker, og du kan også konfigurere tilgang for ekstern bruk av NAS-serveren din.

Noe informasjon om farene ved å bruke RAID

RAID er et overflødig utvalg av uavhengige harddisker. RAID er ikke et reservelagringssystem; det hjelper bare å forbedre komforten til datatilgang. Et RAID-system er et sett med harddisker kombinert i en matrise. Hvis harddisken mislykkes, kan du erstatte den og deretter gjenopprette RAID, og dataene dine vil være med deg, unntatt RAID 0-arrayet.

Ulemper med RAID 0

Denne modusen gir bare hastigheten på datatilgang. I Striping Mode blir data delt inn i blokker og skrevet til flere harddisker samtidig. Hvis en harddisk går i stykker, går alle data tapt.

Ulemper med RAID 1

I RAID 1-modus brukes dataspeilingsmetoden, det vil si at en identisk kopi av dataene er plassert på den andre disken. Det er en sårbarhet - en mulig funksjonsfeil i kontrolleren, som vil skade begge medier.

Ulemper med RAID 1 og RAID 5

Under RAID-gjenopprettingsprosessen er skrivehastigheten høy, og etter at en harddisk mislykkes, kan den føre til at en annen HDD mislykkes, og dermed tap av data.

En defekt RAID-kontroller kan også føre til harddiskfeil. I RAID-arrays brukes endringer på filer, og hvis data ved et uhell blir slettet eller endret, er handlingene irreversible.

Hei kjære lesere av dette fantastiske nettstedet! Jeg vil fortsette å beskrive arbeidet mitt med å montere en hjemmelaget NAS. Jeg skrev allerede om den første viktige komponenten i systemet mitt i kategorien Datamaskiner og nettbrett, dette er Asus DSL-N55U ADSL-modemet. Hvorfor jeg kjøpte den og generelt en kort bakgrunn om hvorfor jeg trenger en NAS i det hele tatt, kan du lese. Merk følgende! Mange bilder!

I dag vil jeg fortelle deg mer om kjøp av den andre like viktige komponenten (alle IMHO, noen trenger det ikke i det hele tatt) - saken. Generelt sett, for meg, spiller bekvemmeligheten ved å montere komponenter, deres kjøling, pålitelighet og utseende en stor rolle ... derfor passet ikke en boks fra den gamle systemenheten meg, jeg ville ha noe som ikke stor størrelse(mini-ITX), med muligheten til å installere minst fire harddisker (samlingen min har blitt for stor) og med et godt organisert kjølesystem (eller i det minste med muligheten til å organisere en selv), økonomisk.

Selvfølgelig, først og fremst, gjorde jeg oppmerksom på tilfeller av selskaper som er kjent for alle som er interessert i denne saken - Lian Li, Chenbro, Thermaltake. Chenbro og Thermaltake ble droppet fordi var betydelig dyrere eller det nødvendige formatet var ikke tilgjengelig (jeg ønsket å bruke mini ITX). Til slutt bestemte jeg meg for to saker: Lian Li PC-Q08 og Lian Li PC-Q25 (den første er billigere og kan praktisk brukes i fremtiden til en liten hjemmecomputer, den andre er mer praktisk for å bygge en NAS, men på grunn av den spesielle måten å feste sideveggene på, sier de at det rasler og krever litt penger). Mens jeg lette etter informasjon om disse sakene, så jeg på youtube flere anmeldelser av Prodigy-saken, som bare var i sortimentet til butikken der jeg skulle bestille. Jeg likte saken veldig godt, det er synd at det ikke var noen detaljerte anmeldelser om saken i det russiskspråklige delen av Internett. Som jeg sa tidligere, er begrensningen i tollfri import av varer fra utlandet i Republikken Hviterussland bare 120 euro (selvfølgelig mottatt med post), selv om vi inngikk en tollunion med Russland og Kasakhstan, så jeg bestemte meg å kjøpe denne saken fra de to tre som jeg valgte (spesielt siden den billigere Lian Li PC-Q08 forsvant midlertidig fra nettstedet fra salg, nå er det igjen).

Prodigy-saken kommer i fire farger - svart, hvit, oransje og rød, for meg selv valgte jeg svart som den mest praktiske. Sammen med kroppen (60 euro), slik at kjøpet var lønnsomt (selv om jeg vil være ærlig, siden jeg har et valg i byen, og det er nesten ingen slike bygninger i Hviterussland, ville jeg bare ha bestilt denne kroppen) Jeg bestilte 120 euro til vår grense en annen strømforsyningsenhet (37 euro) og en kjøler (23 euro) for prosessoren, med tanke på 5 euro-rabatten for det første kjøpet, viste det seg nøyaktig 115 euro, levering til Hviterussland og bankens provisjon for å betale med et VISA-kort - 28,55 euro. Jeg kjøpte en sak med de ovenfor beskrevne komponentene i den tyske nettbutikken Computeruniverse.ru.

Som et resultat, for mitt "hjem" NAS fikk jeg følgende konfigurasjon:

- Pentium G2020 (Box) prosessor, Scythe Shuriken Rev.B kjøler

- hovedkort ITX Asus P8H-77 I

- Prodigy-sak

- DDR3 1333 Samsung 2x4 Gb-minne, arvet fra BB ("storebror, dvs. stasjonær datamaskin"), installerte 16 Gb DDR3 AMD 1600 der

- Jeg hadde allerede Ippon 850 UPS, bare det er nødvendig å bytte batteri

- strømforsyning (med 80 PLUS bronsesertifisering - viktig ettersom vår NAS opererer 24/7)

- HDD WD Green 2x3 Tb, 2x2 Tb, 1x1.5 Tb for torrenter

- 4 Gb QUMO Nano flash-stasjon

Operativsystem - .

VIDEO:

En liten VIDEO med disse komponentene kan sees her:

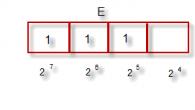

Jeg ønsket å avklare valget av nettopp et slikt sett med komponenter - først og fremst skyldes dette valget at de økte kravene til minne og prosessor er pålagt av ZFS-filsystemet som brukes som det viktigste i NAS4FREE OS og ALLTID TILGJENGELIG fra meg i utgangspunktet (minne og delvis harddisker). Svært kort hva er så spesielt med ZFS:

Tilleggsinformasjon

“Den største fordelen med ZFS er dens fullstendige kontroll over fysiske og logiske medier. ZFS vet nøyaktig hvordan data er plassert på disker, og kan gi rask tilgang til dem, kontrollere integriteten og minimere datafragmentering. Dette lar deg dynamisk tildele eller frigjøre diskplass på ett eller flere medier for et logisk filsystem. I tillegg er det en variabel blokkstørrelse, som den beste måten påvirker ytelse, parallellitet i lese / skrive-operasjoner og 64-bits kontrollsummer, og minimerer muligheten for usynlig datakorrupsjon. "

Selv om alle de valgte varene ble bestilt som "på lager", etter betaling på kontoret, så jeg at strømforsyningen var merket med et merke forventet om 1-2 dager ... men neste dag ble alt sendt. En uke senere var pakken i toll, og etter ytterligere 5 dager ble boksen brakt direkte til leiligheten. Den generelle boksen kjørte fint (inne i fabrikkboksen, alt er nytt i filmen), fra utseendet er det klart at den kan ha blitt rystet anstendig flere ganger, men ingenting revet osv. Nei.

Så jeg vil fortsette med saken.

For å gjøre det klart hva dette handler om noen få bilder.

Korte ytelsesegenskaper for saken fra produsentens nettsted:

Materialer Stål, plast

Farger (Int / Ekst.) Svart / Svart, Hvit / Hvit

Dimensjoner (BxHxD) 250 x 404 x 359mm

Innvendige mål (BxHxD) 250 x 310 x 340 = 26,35 liter

Hovedkortstørrelser Mini-ITX

5,25 "stasjonsbrønner x 1 (avtakbar)

3,5 "Drive Bays x 5 (3 + 2 modulær)

2,5 "Drive Bays x 9 (5 + 2 + 1 +1)

Kjølefront 120 mm x 2 (120 mm x 1 inkludert) eller 140/180/200 / 230 mm x 1 (valgfritt)

Kjøling bak 120 mm x 1 (inkludert) eller 140 mm x 1 (valgfritt)

Kjøletopp 120mm x 2 (valgfritt)

PCI-spor x 2

I / O USB 3.0 x 2, HD-lyd

Strømforsyning PS2 ATX (bunn, flerretning), PSU-burdybde 180mm, maks PSU-dybde 160mm

Ekstra FyberFlex ™ kompositthåndtak, SofTouch ™ overflatebehandling, filtrerte inntak, verktøyfri kjørelås

Generelle inntrykk av saken er veldig, veldig positive, IMHO systemet viste seg å ikke være veldig klumpete, ganske klumpete (jeg mener med antall harddisker som kan installeres) og stille (for å være ærlig, dette er med to installerte 140 mm vifter med lang hastighet, som er beskrevet nedenfor).

Når det gjelder montering i dette tilfellet - sammenlignet med hvordan jeg en gang samlet en HTPC i en mATX Thermaltake Lanbox Lite-sak, er dette bare en ferie av noe slag. Ingen anstrengelser, ingen forsøk på en eller annen måte å plassere noe, bare å passe inn osv., Selv om denne kroppen er mindre i volum. Stivheten i saken er tilstrekkelig, de øvre og nedre “håndtakene” i saken (som den ligner datamaskiner fra et veldig kjent selskap :-)) er laget av fleksibel soft-touch plast. Hovedkortet er installert horisontalt på plass (på grunn av dette er saken ganske bred) på de allerede loddede stativene, og det er praktisk talt ingen høydebegrensninger for en tårnkjøler, her vil alt avhenge av kompatibilitet med et bestemt hovedkort, dvs. i prinsippet er det mulig å bygge et system med passiv kjøling for prosessoren. Den monterte datamaskinen ser ut som et spor. vei:

Videre om kjøling - to 120 mm er inkludert. kjøligere med tilkobling til et 3-pinners hovedkort (du må ha adaptere for de som, i likhet med hovedkortet mitt, bare har to kontakter, en av dem tar prosessorens kjøler). Fordi Jeg har fem harddisker installert, og sommeren vår har vært ganske varm i det siste, standardviftene ble erstattet av 2x140 mm, den ene ved 900 rpm, den andre ved 1000 rpm - jeg koblet den til hovedkortet og satte den til "stille" i BIOS-modus, i denne modusen fungerer den ved 600 r / s. Nå (kopiering til en av NAS-diskene) er temperaturen på harddiskene 32 grader, prosessorens temperatur er opptil 41. Du må kanskje tenke på noe annet, tk. luftstrømmen går bare til kurven med 3 harddisker, og kanskje ikke (den vil være synlig om sommeren). En av de kjøpte 140 mm-viftene viste seg å være med blå bakgrunnsbelysning, og hvis dette er akseptabelt for en hjemmecomputer, er det irriterende om natten for en 24/7 fungerende NAS.

Jeg vil fortsette med kjøling - hele saken tillater installasjon av 1x120 (140) mm. bakvifte, 2x120 mm. eller vannkjøling ovenfra, 2x120 mm vifte foran, men forutsatt at kurven for en 5 "enhet fjernes eller 1x140 / 180/200/230 mm. vifte, dvs. det er fullt mulig å lage en nesten lydløs maskin. For eksempel , installer et stort tårn uten kjøler til prosessoren og 230 mm. kjøler for 600-900 o / min foran. Det er synd at jeg ikke fant en slik størrelse i byen min, men jeg kunne ikke kjøpe den på nettet butikk på grunn av tollgrensen (og jeg husket da saken allerede var kommet), kanskje jeg vil bestille med følgende bestillinger ...

Det som ellers er veldig praktisk med saken, er muligheten til å fjerne "unødvendige" deler - kurver for harddisker, et rom for en 5 "enhet. Det er 2 flyttbare filtre - ett på toppen og ett under strømforsyningen.

Det er lov å installere fem 3,5-tommers harddisker (i kurver, ved hjelp av glider med mulighet for ytterligere feste med en skrue, pinner i sleder i gummidempere) og to SSD-er på sideveggen eller ni 2,5 "harddisker - i kurver , på bunnen av saken og på sidedekslet. Avstanden mellom harddisker i en stor kurv er stor nok, noe som skal ha en god effekt på temperaturregimet.

Strømforsyningen kan brukes som standard, og dette er et stort pluss for saken, men helst ikke lenger enn 160 mm (selve rommet er lengre, og hvis enheten er modulær, tror jeg den vil stige 165 mm), den er installert på gummiføtter limt direkte på bunnen av saken, det er fortsatt plass på sidene ca 3 cm brede, hvor du kan legge ubrukte kabler - jeg gjorde nettopp det, skjulte de unødvendige nærmere bakveggen. Selv om jeg tidligere planla å kjøpe en strømforsyning av modulær type, slik at det var så få ledninger som mulig i saken, passet jeg alt inn i Prodigy uten spesielle vanskeligheter, og skjulte alle "haler", siden rommet og ganske vellykket design tillater den.

Det er hull for kabler på pallen til hovedkortet, noe som også er veldig gjennomtenkt og praktisk, sideveggene er skrudd på "lam" med store riflede hoder. Som det vil sees på bildet har jeg SATA-kabler, hovedstrøm, lyd og USB som stikker ut av kablene, dvs. Du kan helt få et vakkert etui som ikke er "rotete" med ledninger, hvis du ikke kobler til lyd og USB 3.0 til frontpanelet som ikke brukes i konstruksjonen av NAS (jeg har bare en vane med å ha alt tilkoblet) . For de som vil bruke saken som en spillmaskin eller HTPC - jeg liker at det endelig er USB 3.0 for det fremre (eller rettere, siden) eksterne panelet koblet til hovedkortkontakten, og ikke via en kabel til de bakre kontaktene, som , for eksempel i min i BB (HAF X).

Hva mer trenger du å huske på? Hvis du installerer samme kjøler som min, må du huske at den vil blokkere det eneste PCI Express-sporet, og du vil ikke kunne bruke det (for eksempel et skjermkort). Da jeg åpnet esken med saken, falt det ut flere plastbiter under føttene mine ved utpakking, det viste seg at under transport og risting brøt begrensningene for kurven med harddisker for 3 disker (de er plassert bak og , dessverre, er ikke synlige på bildet) og jeg måtte tukle litt med superlim, så vær forsiktig - når du kjøper i en offline butikk, sjekk dette punktet. Soft-touch materiale blir skittent ganske raskt, etter at jeg flyttet saken et par ganger, forblir fingeravtrykk synlig - de slettes med en fuktig klut. Jeg likte ikke hvordan sideveggene lukkes - ikke så tett som jeg vil, jeg liker at sidedekslene lukkes og holder normalt uten skruer, her er det nødvendig å skru veggene på "lammene".

Hva var uventet med korpset? Størrelsen. I videoen og bildet på Internett virket det for meg litt mindre, så det er bedre å estimere dimensjonene på noe lignende objekt, for eksempel en boks.

Bilder av den tomme saken og allerede nesten samlet kan sees i min, og hvordan jeg åpnet esken med saken i videoen kan sees her:

VIDEO:

Jeg vil supplere innlegget mitt, tk. stille i kommentarene om spørsmål som relaterer seg mer til det samlede systemet som helhet, og ikke spesifikt til korpuset. Nettverkskopihastigheter (Windows-klientdatamaskin, SMB2 og FTP-protokoller): til NAS - opptil 120 MB / s, fra NAS - opptil 70 MB / s. Jeg kan ikke si nøyaktig hvor mye systemet bruker, bare basert på omtrentlige beregninger - opptil 80 W (og alt avhenger av den valgte driftsmodusen til harddiskene - de er kontinuerlig på (mest å foretrekke for mekanikken til harddisken) , med spindelen som stopper osv.).

Nok et tillegg til innlegget. Nylig kjøpte jeg en ting (om enn noen ganger) som var nødvendig for husholdningen - det enkleste Xavax Energiekostenmessgerät wattmeter. Jeg vil sitere data om strømforbruket fra systemet i en vanlig modus når systemet starter (topp) og når du skriver om informasjon fra en disk til en annen:

typisk modus (torrenter) - 53,6 W

systembelastning - 82 W (maksimumsverdi)

overskrive bilder fra en disk til en annen - 63,6 W

I systeminnstillingene for energisparing er det verdt “ikke stopp harddisken”.

Og en liten video med den allerede monterte og konfigurerte NAS, på den kan du se hva web-skallet er for å administrere og konfigurere NAS4FREE:

VIDEO:

Takk for at du leser kreasjonen min til slutt. Hvis noen har avklaringer og ønsker, kan jeg rette innlegget mitt.

Takk igjen til alle som leste og takket for deres arbeid, bare hvis du skriver en personlig takk til alle, vil kommentarene være dobbelt så mange - og det vil ikke være praktisk å lese, takk.

P.S. Omtrent 5 euro rabatt (henvisning) for det første kjøpet i butikken: Jeg likte anmeldelsen +97 +205