Naviger i artikkelen

Dette er en instruksjon om hvordan du kobler til en iSCSI-disk Windows Server 2016... Når du bestiller en tjeneste fra SIM-Networks, vil du motta en melding som ligner på den nedenfor (vær oppmerksom på at verdiene til tallene i serveradressen kan avvike fra eksempelillustrasjonen, og i stedet for bokstaver X, Y eller Z meldingen vil indikere de virkelige verdiene for innstillingen din hans adgang):

"iSCSI Backup"-tjenesten er aktivert.

Tilgangsparametere:

- Serveradresse (iscsi-mål): 185.59.101.184

- Logg Inn:ÅÅÅ

- Passord: ZZZ

- Tilgang til tjenesten er for øyeblikket begrenset til kun én IP-adresse - XXX.XXX.XXX.XXX

ISCSI Drive Mapping

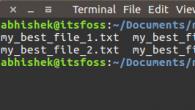

1. Gå til " Kontrollpanel -> Administrasjon"Og løp InitiativtakeriSCSI.

2. I kapittel " EgenskaperGjenkjenning"Og trykk på knappen" Oppdag portalen».

3. I vinduet som åpnes, fyll ut feltet " IP adresse " iSCSI-server.

4. Åpne delen av tilleggsparametere for å koble til serveren (klikk på " I tillegg"). Velg feltverdier" Lokal adapter"og" Initiativtakerens IP-adresse"Som på bildet nedenfor (hvor initiator-IP er IP-en til din lokale nettverksadapter som tilkoblingen til iSCSI-serveren er tillatt gjennom).

5. Lagre innstillingene, sørg for at du får et bilde som det nedenfor:

6. I kapittel " Egenskaper"ISCSI-initiator gå til" Avslutt objekter", Velg objektet som vises med en inaktiv tilstand og trykk på knappen" Å plugge».

7. I det åpne vinduet " Målforbindelse", Trykk på knappen" I tillegg …»

8. Fyll ut feltene i seksjonen som på bildet under. Parametrene "Navn" og "Hemmelig" er "Logg inn" og "Passord" fra brevet som ble sendt til deg ved aktivering av tjenesten.

9. Lagre innstillingene. Pass på at verdien av feltet " Stat"Oppdaget mål -" Tilkoblet"Som på bildet nedenfor. Gå ut av delen " Egenskaper»ISCSI Initiator, lagrer innstillingene.

Initialisere og formatere en iSCSI-stasjon

Den tilkoblede iSCSI-disken må klargjøres (initialiseres og formateres).

10. I kapittel " Administrasjon"Åpne" Databehandling».

11. Gå til delen " Diskbehandling».

12. Kontroller at disken din vises, statusen er " Frakoblet».

13. Velg fra kontekstmenyen elementet " på nett».

14. Initialiser platen.

15. Sjekk at diskstatusen er endret til "På nett" men den mangler partisjoner og filsystem.

16. Fra kontekstmenyen på en upartisjonert disk, velg " Lag enkelt volum».

17. Etter åpning" Enkle volumveivisere"Klikk på knappen" Lengre».

18. Angi størrelsen på partisjonen i det tilsvarende feltet, eller la standardverdien være uendret (hvis du trenger å bruke hele disken under én partisjon).

19. Tilordne en stasjonsbokstav for den nye partisjonen.

20. Velg filsystemtype og volumetikett.

ISCSI er designet for lagringsnettverk og er en metode for å få tilgang til blokkenheter over SCSI over TCP/IP. Dette gjør det mulig å sette opp rimelige lagringsnettverk (SAN) over konvensjonelle Ethernet-nettverk. Denne funksjonen er mye brukt i konstruksjonen av systemer med høy tilgjengelighet, og vi vil vurdere løsninger basert på iSCSI-lagring i denne syklusen. I dag skal vi se på å lage en slik butikk på Windows Server 2008 R2-plattformen.

Først noen få ord om de grunnleggende forskjellene mellom iSCSI og andre nettverkslagringssystemer. Storage Area Networks - SAN(Storage Area Network) sørger for overføring av data i nettverket i "rå" form ved bruk av SCSI-protokollen, akkurat som om de ble overført mellom systemet og den lokale disken på et lavt nivå. iSCSI-enheter oppfattes av systemet på omtrent samme måte som lokale disker - de må partisjoneres og formateres før bruk.

Samtidig kjent for alle nettverkstilknyttede lagringer - NAS (Network Area Storage) gir tilgang på filsystemnivå ved bruk av filoverføringsprotokoller som SMB eller NFS.

Enkelt sagt: NAS er delte nettverksmapper som er kjent for alle, SAN - stasjoner koblet over et nettverk. Dette fører til en annen viktig forskjell. En nettverksmappe kan betjene mange klienter. En SAN-enhet kan kobles til en enkelt klient, akkurat som en vanlig HDD kun kan kobles til én PC. Et unntak er klynger, når flere noder har tilgang til en SAN-enhet samtidig, i dette tilfellet brukes et ekstra abstraksjonsnivå - et klyngefilsystem, for eksempel Microsoft Cluster Shared Volumes (CSV) eller VMware VMFS.

Før du går i gang med den praktiske utviklingen av denne teknologien, bør du gjøre deg kjent med den aksepterte terminologien:

- ISCSI-initiator- klientdelen, sender forespørsler til iSCSI-målet, kan utføres i programvare, i form av en driver, eller i maskinvare, i form av en iSCSI-adapter;

- ISCSI-mål (iSCSI-mål, mål) - serversiden, aksepterer tilkoblinger fra initiativtakeren og gir ham tilgang til blokkenhetene knyttet til ham - virtuelle disker, LUN-er. Det kan implementeres både i programvare og som et maskinvarelagringssystem.

Ett iSCSI-mål kan knyttes til flere blokkenheter som vil være tilgjengelige for initiativtakeren som kobler til målet. Én initiativtaker kan kobles til flere mål og bruke alle tilknyttede enheter. Et enkelt mål kan også godta tilkoblinger fra flere initiativtakere, men hver enkelt enhet kan bare nås av én av initiativtakerne.

Et annet punkt, nå knyttet til den praktiske implementeringen av iSCSI-lagring. For SAN er det svært ønskelig å ha et separat nettverk isolert fra bedriftsnettverket.

Dette er nødvendig for å sikre tilstrekkelig SAN-båndbredde og for å unngå overbelastning av det vanlige nettverket med iSCSI-trafikk. Det gir heller ingen mening å organisere iSCSI i nettverk med en båndbredde lavere enn 1 Gbps.

Dette er nødvendig for å sikre tilstrekkelig SAN-båndbredde og for å unngå overbelastning av det vanlige nettverket med iSCSI-trafikk. Det gir heller ingen mening å organisere iSCSI i nettverk med en båndbredde lavere enn 1 Gbps.

Windows Server 2008 R2 inkluderer ikke rollen iSCSI Target, og du må laste ned Microsoft iSCSI Software Target for å distribuere den. Pakk den ut og installer pakken iscsitarget_public.msi fra x64-mappen. Installasjonen er ekstremt enkel og vi vil ikke fokusere på den.

Etter installasjonen, la oss gå til iSCSI Management Console: Start - Administrative verktøy - iSCSI Software Target... Først av alt, la oss lage en ny mål (mål)... For å gjøre dette, høyreklikk på ISCSI-mål - Lag iSCSI-mål.

En veiviser åpnes, der vi spesifiserer navnet på målet og beskrivelsen. Gi målene meningsfylte navn og ikke vær lat med å lage beskrivelser slik at du senere slipper å gjette hvorfor du har laget dette eller det målet.

En veiviser åpnes, der vi spesifiserer navnet på målet og beskrivelsen. Gi målene meningsfylte navn og ikke vær lat med å lage beskrivelser slik at du senere slipper å gjette hvorfor du har laget dette eller det målet.

Det neste trinnet må spesifisere ID-ene til iSCSI-initiatorene som vil få tilgang til målet. IQN er et spesielt formatnavn iqn.

Det neste trinnet må spesifisere ID-ene til iSCSI-initiatorene som vil få tilgang til målet. IQN er et spesielt formatnavn iqn.

- år-mnd- år for registrering av domenenavn;

- omvendt_domenenavn-domenenavn skrevet omvendt;

- unikt_navn- et unikt enhetsnavn, for eksempel, målet her vil inneholde navnet du spesifiserte, og initiativtakeren vil inneholde vertsnavnet.

For eksempel, i Microsofts programvareløsninger har IQN standardformatet iqn.1991-05.com.microsoft:unique_name.

For å finne ut IQN, la oss gå til iSCSI-initiatoren, i vårt tilfelle er det en server som kjører Windows Server 2012, men prosedyren vil være den samme for alle andre versjoner av Windows. Gå til Kontrollpanel - iSCSI-initiator, svarer vi bekreftende på forslaget om å sette den automatiske lanseringen:

Gå deretter til fanen i vinduet som åpnes Konfigurasjon hvor den nødvendige identifikatoren er plassert:

Gå deretter til fanen i vinduet som åpnes Konfigurasjon hvor den nødvendige identifikatoren er plassert:

Du kan kopiere det og spesifisere det når du setter opp et mål, men det er en annen måte. For å gjøre dette, gå til bokmerket Avslutt objekter, i felt En gjenstand skriv inn navnet på serveren med installert ISCSI-programvaremål og trykk Rask tilkobling.

Du kan kopiere det og spesifisere det når du setter opp et mål, men det er en annen måte. For å gjøre dette, gå til bokmerket Avslutt objekter, i felt En gjenstand skriv inn navnet på serveren med installert ISCSI-programvaremål og trykk Rask tilkobling.

Det er klart at vi foreløpig ikke vil koble oss til noe, men nå har vi en annen oppgave. Vi går tilbake til målserveren og klikker på siden som indikerer initiatoridentifikatoren knappen Oversikt.

Det er klart at vi foreløpig ikke vil koble oss til noe, men nå har vi en annen oppgave. Vi går tilbake til målserveren og klikker på siden som indikerer initiatoridentifikatoren knappen Oversikt.

Nå blir det klart hvorfor vi prøvde å koble til. iSCSI Target Server holder en liste over initiativtakerne som sist er koblet til den, og lar deg velge dem.

Nå blir det klart hvorfor vi prøvde å koble til. iSCSI Target Server holder en liste over initiativtakerne som sist er koblet til den, og lar deg velge dem.

Dette fullfører opprettelsen av målet, og vi kan opprette og binde en eller flere disker til det. For å gjøre dette, gå til element Enheter og velg i høyreklikkmenyen Lag virtuell disk.

Følgende veiviser åpnes, der vi spesifiserer plasseringen og navnet på den virtuelle disken, merk at du må spesifisere hele navnet på filen, sammen med utvidelsen .vhd.

Følgende veiviser åpnes, der vi spesifiserer plasseringen og navnet på den virtuelle disken, merk at du må spesifisere hele navnet på filen, sammen med utvidelsen .vhd.

Deretter vil vi angi ønsket størrelse i MB

Og iSCSI-målet (målet) som denne virtuelle disken vil bli koblet til.

Og iSCSI-målet (målet) som denne virtuelle disken vil bli koblet til.

Dette fullfører også plateoppsettet. Som et resultat av disse enkle trinnene fikk vi et konfigurert iSCSI-mål med en virtuell disk koblet til. La oss nå gå tilbake til initiativtakeren. Du kan dra nytte av rask tilkobling og automatisk koble til stasjoner fra oppdagede mål. Men husk at målet vårt ikke bare er å koble til stasjoner, men også å skille SAN og det lokale nettverket til bedriften.

Dette fullfører også plateoppsettet. Som et resultat av disse enkle trinnene fikk vi et konfigurert iSCSI-mål med en virtuell disk koblet til. La oss nå gå tilbake til initiativtakeren. Du kan dra nytte av rask tilkobling og automatisk koble til stasjoner fra oppdagede mål. Men husk at målet vårt ikke bare er å koble til stasjoner, men også å skille SAN og det lokale nettverket til bedriften.

Gå derfor til bokmerket Gjenkjenning og trykk Oppdag portalen, skriv inn servernavnet med iSCSI-målrollen.

Så går vi tilbake til bokmerket Avslutt objekter, velg det oppdagede målet, som er i tilstanden Ikke aktiv, og trykk Egenskaper.

Så går vi tilbake til bokmerket Avslutt objekter, velg det oppdagede målet, som er i tilstanden Ikke aktiv, og trykk Egenskaper.

I det åpne vinduet i feltet Målportalens IP-adresse velg adressen som tilhører lagringsnettverket ditt:

I det åpne vinduet i feltet Målportalens IP-adresse velg adressen som tilhører lagringsnettverket ditt:

Vi går tilbake og trykker Å plugge... Tilknyttede enheter finner du i snap-in Diskbehandling.

Vi går tilbake og trykker Å plugge... Tilknyttede enheter finner du i snap-in Diskbehandling.

Den videre algoritmen for å jobbe med dem er ikke forskjellig fra å jobbe med en vanlig disk: vi kobler til, markerer, formaterer.

Den videre algoritmen for å jobbe med dem er ikke forskjellig fra å jobbe med en vanlig disk: vi kobler til, markerer, formaterer.

I denne artikkelen undersøkte vi det enkleste alternativet for å sette opp et lager. I våre påfølgende materialer vil vi gå tilbake til individuelle innstillinger uten å berøre det generelle emnet om å lage et depot.

I denne artikkelen undersøkte vi det enkleste alternativet for å sette opp et lager. I våre påfølgende materialer vil vi gå tilbake til individuelle innstillinger uten å berøre det generelle emnet om å lage et depot.

05.10.2012

Vil du ha tilgang til nettverkslagringen din litt raskere? Prøv å bruke det innebygde Windows-verktøyet. iSCSI-protokollen lar deg koble til et eksternt lagringsvolum over nettverket som om volumet var en lokal stasjon.

Marco Chiappetta. Få fart på NAS-enheten din med iSCSI. PC World, september 2012, s. 86.

Vil du ha tilgang til nettverkslagringen din litt raskere? Prøv det innebygde Windows-verktøyet. iSCSI-protokollen lar deg koble til et eksternt lagringsvolum over nettverket som om det var en lokal disk.

ISCSI står for Internet Small Computer System Interface. SCSI-teknologi (uten i) har lenge vært brukt for å koble ulike periferiutstyr til datasystemer, men som oftest utveksler den data med lagringsenheter som harddisker eller båndstasjoner. iSCSI-protokollen lar deg koble til et eksternt lagringsvolum over nettverket som om det var en lokal disk. Enkelt sagt, iSCSI oversetter SCSI-kommandoer over IP-nettverk (Internet Protocol). Denne teknologien ligner en virtuell SATA-kabel (eller SCSI) og bruker en nettverkstilkobling for å kommunisere mellom systemet og lagringsvolumet.

Hvordan er iSCSI forskjellig fra alle andre nettverkstilkoblede stasjoner med den tilordnede stasjonsbokstaven? På mange måter vil sluttresultatene være like. Men takket være iSCSI ser det monterte volumet ut som en lokal blokklagringsenhet for operativsystemet som kan formateres til hvilken som helst filsystemstandard du ønsker.

Et iSCSI-grensesnitt krever to hovedkomponenter: en nettverkstilkoblet lagring (NAS) eller server med et volum konfigurert som et iSCSI-mål, og en iSCSI-initiator, som gjør at systemet kan kobles til målet.

Hvis du har en NAS-enhet koblet til en Windows-PC, er dette sannsynligvis tilstrekkelig. Så godt som alle NAS-servere tilbyr muligheten til å konfigurere iSCSI-mål. Og Microsoft har et verktøy for å lage en iSCSI-initiator i alle versjoner av Windows siden Vista. Initiatoren kan kjøres på en datamaskin med en operativsystemversjon på minst Windows 2000.

For å demonstrere hvordan iSCSI fungerer, ta en Thecus N2200XXX dual-drive NAS-server som kjører et tilpasset iSCSI-kompatibelt Linux OS og et Windows 7 Ultimate desktop-system. Ethvert Windows-basert system lager en iSCSI-kompatibel enhet når den samhandler med NAS-en.

.jpg)

iSCSI fordeler og ulemper

Som nevnt ovenfor er iSCSI-nettverksmålet representert på systemet som en lokal disk. Derfor kan du ikke bare formatere den i filsystemstandarden til datamaskinens operativsystem, men også sørge for at programmer som krever en lokal disk startes fra iSCSI-volumet. Denne fleksibiliteten er svært viktig for små bedrifter fordi mange programmer ikke er nettverksbevisste. ISCSI-teknologi hjelper til med å løse dette problemet.

I noen tilfeller kan iSCSI forbedre ytelsen ved å koble store diskarrayer til klientsystemer uten behov for spesiell maskinvare og kabler (noe som kan føre til betydelige besparelser). I denne artikkelen vil vi imidlertid begrense oss til en vurdering av mellomstore forbrukersystemer.

Det skal bemerkes at iSCSI-teknologi har visse ulemper. Systemoppsettet er ikke altfor komplisert, men nettverksressurssøk alene vil ikke være nok til å konfigurere iSCSI-målet og initiatoren. For å unngå datakorrupsjon eller tap, bør bare én initiativtaker kobles til målet om gangen. Hvis du bruker høyytelsesservere og diskstasjoner, vil ytelsen være begrenset av hastigheten på nettverkstilkoblingen. Derfor ser det ut til at det beste valget er en tilkobling med gigabit-hastigheter og høyere - trege nettverkstilkoblinger kan nøytralisere alle fordelene med iSCSI.

Installasjon

Følgende er trinnene du må ta for å bruke iSCSI-teknologi med Thecus N2200XXX NAS. For andre enheter og servere vil trinnene være de samme.

1. Gå inn i NAS-serverens konfigurasjonsmeny, velg RAID-modus og reserver plass for iSCSI-volumet. Jeg brukte RAID 1-speiling med to 2TB-stasjoner. Halvparten av den tilgjengelige kapasiteten ble allokert til EXT4-filsystemet, og den andre halvparten var ubrukt. (I den tredje fasen ble den ubrukte kapasiteten satt til side for iSCSI.)

.jpg)

2. Etter å ha tildelt plass for RAID, må den formateres. Når formateringsprosessen er fullført (avhengig av stasjonskonfigurasjonen, kan dette ta flere timer), kan du begynne å tildele ubrukt plass til iSCSI-målet. (Hvis all tilgjengelig plass vil bli reservert for iSCSI, trenger du ikke formatere diskarrayen på dette stadiet.)

.jpg)

3. La oss nå konfigurere iSCSI-målet. Jeg klikket først på koblingen Space Allocation i Lagring-menyen i venstre rute og deretter på Legg til-knappen på iSCSI-målfanen. Et nytt vindu vises på skjermen der du må velge ønsket størrelse på iSCSI-målet, aktivere det og gi det et navn.

.jpg)

Og hvis du vil legge til et ekstra lag med sikkerhet, kan du samtidig konfigurere parametrene til Challenge Handshake Authentication Protocol (CHAP).

4. Hvis du bestemmer deg for ikke å allokere all tilgjengelig plass til et enkelt iSCSI-mål, kan du tilordne logiske enhetsnumre (LUN-er) til flere mål. Dette vil tillate flere systemer å kobles til en enkelt NAS-enhet eller server, og hvert klientsystem vil motta sitt eget iSCSI-mål.

Sette opp målet

Etter at iSCSI-målet er opprettet, må du koble til det via iSCSI-initiatoren på Windows-klient-PCen. Klikk på Start-knappen, skriv inn iSCSI i søkefeltet og trykk på tasten (eller gå til Start-menyen til Kontrollpanel og under System og sikkerhet velg Administrative Tools og deretter iSCSI Initiator). Hvis det vises en melding på skjermen om at iSCSI-tjenesten ikke kjører, aktiver den til å starte og vinduet iSCSI Initiator Properties vises på skjermen.

Gå til Discovery-fanen og klikk Discover Portal-knappen. I vinduet som åpnes skriver du inn IP-adressen til NAS-enheten eller serveren som er vert for iSCSI-målet. Det er ikke nødvendig å endre portnummeret (med mindre iSCSI-portnummeret ble definert tidligere). Som standard foreslår systemet port 3260. Hvis du tidligere har aktivert CHAP-autentisering, må du klikke på Avansert-knappen og angi CHAP-legitimasjonen din. Ellers klikker du OK og IP-adressen til NAS-enheten eller serveren vil vises i listen over målportaler.

Hvis målet ikke er på denne listen, kontroller at IP-adressen er angitt riktig og at riktig port er åpen på brannmuren.

Etter at serveren vises i listen over mål, går du til fanen Mål. iSCSI-målet du opprettet tidligere skal vises i målgruppen i midten av vinduet. Klikk på objektet og klikk på "Koble til"-knappen. I måltilkoblingsvinduet som vises på skjermen, velg alternativet Legg til denne tilkoblingen til listen over favorittmålobjekter og klikk OK. Klikk deretter OK igjen i vinduet iSCSI Initiator Properties.

På et klientsystem koblet til et iSCSI-mål, må du formatere målet ved å bruke samme prosedyre som du ville gjort for en hvilken som helst lokal stasjon. Klikk på "Start"-knappen, høyreklikk på "Datamaskin" og velg "Administrer" fra kontekstmenyen. Klikk på koblingen Diskbehandling i Lagring-delen av Computer Management-verktøyet. Dialogboksen "Initialiser disk" vises. Sørg for at alternativet "Select disk" er merket og velg ønsket partisjonstype (jeg brukte MBR - Master Boot Record). Klikk OK.

Følg instruksjonene på skjermen for å angi størrelsen på volumet, tilordne en bokstav til stasjonen og spesifisere filsystemet og volumetiketten. Klikk på Fullfør-knappen. Når formateringen er fullført, vises en ny stasjonsbokstav. Nå kan du overføre filer og kjøre programmer fra NAS-en din uansett hvor den er.

Sammenligning av ytelse

For å evaluere ytelsen til min iSCSI-tilkoblede eksterne NAS, sammenlignet jeg iSCSI-målet med en standard tilkoblet NAS ved å bruke to referanser.

ATTO Disk Benchmark viste ikke mye forskjell mellom en kartlagt nettverksstasjon og en iSCSI-enhet, selv om stasjonen viste litt høyere gjennomstrømning. Dette er imidlertid en relativt enkel test som kun evaluerer sekvensiell dataskriving.

Men CrystalDiskMark-testen analyserer driften av enheter i både sekvensiell og tilfeldig tilgangsmodus, og opererer med to filer av forskjellige størrelser. Resultatene viste at iSCSI-målet presterte betydelig raskere. iSCSI-enheten og den standard kartlagte nettverksstasjonen hadde samme skrivehastighet, men iSCSI-lesningene var 30–40 % raskere.

Testing har vist at tilgang til en NAS-enhet og formatering av den slik at den ligner en lokal disk, samt muligheten til å kjøre programmer, ikke er de eneste fordelene iSCSI-teknologien gir. Den akselererer også leseoperasjoner. Så hvis du har å gjøre med NAS-enheter hjemme eller på kontoret, vil iSCSI forbedre ytelsen betydelig (og helt gratis).

Fortsetter emnet nyttig bruk av gammel servermaskinvare, denne gangen, la oss snakke om bruk av modellserveren IBM System x3200 4362 som en nettverkslagring tilgjengelig via protokollen iSCSI som iSCSI-mål... V vi har allerede vurdert en slik server som et lager for sikkerhetskopiering av virtuelle maskiner med programvarededuplisering fra Quadstor ... Men i vårt tilfelle ble situasjonen forverret av det faktum at det på noen avsidesliggende steder der den ble utplassert , virtuelle maskiner som ble sikkerhetskopiert over tid, fikk en ekstra disk for lagring av innhold for distribusjonspunktet SCCM ... Og som du vet, kan innholdet på disker som brukes til innholdsdistribusjon i SCCM endre seg veldig aktivt til tider (nye oppdateringer lastes ned , utløpte oppdateringer fjernes, noe distribusjonsprogramvare er lastet inn osv.). Derfor, gitt det faktum at programvaren som brukes Veeam Backup Free Edition ikke tillater deg å ekskludere individuelle virtuelle disker som tilhører denne VM fra sikkerhetskopien av en virtuell maskin, var det nødvendig å løse problemet med å øke diskplass på de samme IBM-serverne. Parallelt oppsto spørsmålet om nytten av deduplisering, som ved hyppig skiftende innhold mister sin effektivitet.

"Kirsebæret på toppen" i den beskrevne situasjonen var at serveren, som i vårt tilfelle brukes som et iSCSI Target (fra Quadstor-implementeringen), har et meget beskjedent diskbur - kun 4 SAS / SATA 3.5 "spor, to av som er opptatt under verten Linux OS.

Her vil vi vurdere en av de mulige løsningene på settet med de beskrevne problemene og begrensningene, som består i å erstatte en fullverdig Linux OS-installasjon med en spesialisert en lastet fra en USB-stasjon og kjører i RAM.Linux-distribusjon av prosjektet Enterprise Storage OS (ESOS). I kjernen er ESOS en moderne Linux-kjerne optimalisert for arbeid i RAM med integrert prosjektprogramvare. , et eksempel på bruken som vi allerede har .

Den generelle arrangementsplanen vil se slik ut:

- Vi fjerner diskene med liten kapasitet som vertsoperativsystemet er installert på fra diskkurven, og legger på dette stedet diskene med større kapasitet (alle diskene i kurven vil ha samme kapasitet)

- På maskinvare-RAID-kontrollernivå definerer vi hver av de fire diskene som er koblet til diskholderen som en uavhengig enhet.

- Forbereder en oppstartbar USB-stasjon med ESOS

- Vi laster serveren med ESOS og lager en programvare RAID-array fra alle diskene i papirkurven.

- Konfigurer iSCSI Target i ESOS og koble til disken på serversiden av iSCSI Initiator

- Konfigurere en ekstra nettverksforbindelse mellom servere og aktivere Multipath

Serverkonfigurasjon

I vårt eksempel vil vi vurdere å bygge den enkleste konfigurasjonen ved å bruke iSCSI av to servere, hvorav den ene fungerer som et mål iSCSI-mål på basen ESOS v 1.3.5 og den andre fungerer som initiativtaker vert iSCSI-initiator på basen Windows Server 2012 R2... For å forbedre tilgjengeligheten og ytelsen vil det opprettes en flerveisforbindelse mellom målet og den initierende verten ( flerveis). For å skille iSCSI-trafikk fra serveradministrasjonstrafikk er det installert en ekstra to-ports nettverksadapter på hver server.

1 ) Server for rollen iSCSI Target(KOM-AD01-ESOS01)

Modellserver IBM System x3200 4362 med et diskbur for 4 LFF HDD SAS / SATA-stasjoner og en ekstra installert nettverksadapter HP NC380T PCI Express Dual Port Multifunction Gigabit Server Adapter (394795-B21). Denne serveren vil kjøre ESOS oppstartbar fra en USB-pinne. Alle 4 diskene fra serverens diskbur vil bli brukt av ESOS for å organisere en programvare RAID-array, som igjen vil bli presentert for initiatorverten.

2 ) Server for rollen iSCSI-initiator (KOM-AD01-VM01)

Modellserver HP ProLiant DL380 G5 fungerer som en OS-basert Hyper-V-virtualiseringsvert Windows Server 2012 R2 Standard... I tillegg til den grunnleggende konfigurasjonen, er det i tillegg installert et nettverksadapter på serveren HP NC380T PCI Express Dual Port Multifunction Gigabit Server Adapter (394795-B21). Disken som er koblet til denne serveren fra ESOS-serveren via iSCSI-protokollen, vil bli brukt til sikkerhetskopieringsoppgaver til Hyper-V virtuelle maskiner.

Den enkleste ordningen for å koble nettverksgrensesnittene til servere vil se slik ut:

Konfigurere en RAID-kontroller på en IBM-server

Uavhengig av servermodellen og RAID-kontrolleren som brukes i vårt tilfelle, kan vi si at bruken av ESOS-distribusjonssettet, som ikke krever en dedikert disk for driften, i enhver diskkonfigurasjon vil tillate bruk av alle diskkurvressursene for nyttig diskplass. I noen situasjoner kan dette argumentet være betydelig.

I vårt eksempel er 4 identiske SATA 7200 1TB-stasjoner installert i diskholderen.

For å koble oss fra de svært beskjedne egenskapene til maskinvare-RAID-kontrolleren som serveren vår er utstyrt med, og i fremtiden bruke mulighetene til å bygge en programvare-RAID-array basert på ESOS, må vi få hver disk til å se ut som en separat fysisk enhet for ESOS. Derfor, i det innebygde verktøyet for å administrere RAID-kontrolleren, sletter vi alle eksisterende logiske RAID-disker slik at hver disk presenteres som en separat enhet.

Noen RAID-kontrollere, for eksempel HP Smart Array, tillater ikke at kartlagte disker oversettes som frittstående diskenheter. I slike tilfeller må du opprette et separat RAID-0-volum for hver enkelt stasjon. I vårt tilfelle er alt enklere, siden kontrolleren er installert på serveren vår LSI Logic SAS1064ET er ganske primitiv og viser alle disker som separate enheter hvis disse diskene ikke er inkludert i hardware RAID.

Forbereder ESOS USB-oppstartbar stasjon

Last ned den nyeste ESOS stallgrenen (gren 1.x.x) fra prosjektsiden ESOS - Pakkenedlastinger ... På samme side kan du finne en beskrivelse av andre ESOS-grener (master - under utvikling og 0.1.x - foreldet).

I prosessen med å skrive denne artikkelen var versjonen som ble brukt 1.3.5 (25.01.2018 ) tilgjengelig på lenken esos-1.3.5.zip ... Ved publiseringstidspunktet har jeg allerede klart å jobbe med den nyere versjonen 1.3.6 (04/12/2018).

Siden ESOS er et RAM-orientert system, vil det starte fra en ekstern stasjon koblet til via en vanlig USB-port. Det vil si at vi trenger en USB-stasjon med en størrelse på 4 GB og mer. Hvis du planlegger å bruke hovedgrenen, så for en vellykket oppdatering mellom versjoner, i henhold til anbefalingene i dokumentet Oppgradering , kan USB-lagringsenheten kreve opptil 5 GB ekstra plass. I vårt tilfelle har vi for ESOS med hell brukt stasjoner med varierende grader av "kjeller" i størrelse fra 8 GB og mer.

Standard påloggingsinformasjon:

- Brukernavn: rot

- Passord: esos

Når du logger inn, startes et spesielt skall automatisk Tekstbasert brukergrensesnitt (TUI), som forenkler arbeidet med systemet så mye som mulig. Det øvre området av TUI inneholder hovedfunksjonsmenyen som lar deg utføre alle de grunnleggende oppgavene for å konfigurere serveren som lagring for SAN-er.

De primære oppgavene til det første oppsettet er å endre standard brukerpassord. rot og nettverkskonfigurasjon, for mulighet for fjernarbeid med systemet.

Gå til menyelementer System > Bytt passord og angi et nytt passord for brukeren rot.

Gå deretter til System > Nettverksinnstillinger og velg elementet for å konfigurere grunnleggende nettverksparametere Generelle nettverksinnstillinger

I skjemaet som åpnes, spesifiser vertsnavnet, DNS-domenenavnet, IP-adressen til standardgatewayen og DNS-serveradressene.

Etter å ha endret nettverksinnstillingene, vil ESOS tilby å starte nettverkstjenesten på nytt for at endringene skal tre i kraft. Inntil vi har gjort alle minimumsnettverksinnstillingene, kan vi nekte å starte nettverkstjenesten på nytt.

La oss gå tilbake til System > Nettverksinnstillinger, velg nettverksadapteren som skal brukes til fjernkontroll av ESOS og konfigurer IP-parametrene. I vårt eksempel er konfigurasjonen statisk og ESOS-administrasjonsgrensesnittet er satt til IP-adresse 10.1.2.201/24. Nettverksmasken og kringkastingsadressen, slik jeg forstår det, må spesifiseres, ellers kan det oppstå feil ved lagring av innstillingene.

Etter å ha lagret endringene som er gjort, vil vi igjen motta et spørsmål om omstart av nettverket. Nå skal vi svare bekreftende på dette spørsmålet.

Nettverket vil bli startet på nytt, og i tilfelle vellykket bruk av de spesifiserte innstillingene, vil vi kunne eksternt koble til ESOS ved hjelp av SSH-protokollen.

For formålet med dette innlegget hopper vi over andre innstillinger som finnes i ESOS, for eksempel tidsinnstilling, sending av e-postkonfigurasjon, administrering av flere brukere, etc. I stedet vil vi kun fokusere på de punktene som er relevante i sammenheng med oppgaven vår. Før jeg kobler til ESOS-serveren vår via SSH, vil jeg imidlertid gjøre en liten kosmetisk digresjon angående TUI-fargeskjemaet.

Det er to fargevalg i TUI ESOS-grensesnittet - det standard lyse, holdt i blå og turkise toner, som vises i skjermbildene ovenfor, og alternativet - mørkt, holdt i de beste tradisjonene fra "fangehullet med et stearinlys" . Ingen av alternativene, etter min mening, er vellykket, siden når du kobler til serverkonsollen eksternt med redusert fargegjengivelse (for eksempel når du kobler til via funksjonen ), noen steder i TUI er det en effekt av tekstsammenslåing med bakgrunnen. Og hvis du kobler til TUI ESOS ved å bruke PuTTy SSH-klienten fra et Windows-system, blir standardfargeskjemaene generelt, etter min mening, til noe "surt".

Siden vi hovedsakelig vil jobbe med ESOS, selvfølgelig, ved å bruke en ekstern SSH-tilkobling, så er det spesielt for PuTTy-klienten en enkel løsning - å bruke tilpassede fargeskjemaer på siden av SSH-klienten for enhver smak og farge. Vi vurderte eksempler på en slik setting tidligere i innlegget. ... Deretter, for å jobbe med ESOS via SSH, vil vi bruke PuTTy-skjemaet - Skumring.

Opprette et programvare-RAID i ESOS

Etter å ha fullført den innledende grunnleggende ESOS-konfigurasjonen, fortsetter vi til konfigurasjonen av serverdisksystemet. La oss lage en programvare RAID-array (implementert på grunnlag av Linux Software RAID/mdraid) av de 4 platene vi har til rådighet. For å gjøre dette, gå til menyen Programvare RAID > Legg til Array

I listen over blokkenheter som er tilgjengelige for inkludering i programvare RAID, merker vi diskene som vi skal lage en RAID-array fra.

Etter å ha valgt diskene, klikk Tast inn... RAID-oppsettskjermen vises. Gi matrisen et tradisjonelt navn mdraid, for eksempel md0... La oss velge et RAID-nivå (i vårt tilfelle er det RAID5) og en blokkstørrelse. I vårt tilfelle er arrayet satt sammen for oppgaven med å sikkerhetskopiere store filer av virtuelle maskindisker, så vi valgte den største blokkstørrelsen.

Etter å ha trykket på knappen OK initialiseringsprosedyren for RAID-arrayet vil starte. Gå til navigasjonsmenyen i Programvare RAID > Linux MD-status og sjekk statusen til den opprettede RAID-matrisen.

Her kan vi vente på fullføringen av å bygge RAID-arrayet, eller vi kan fortsette å konfigurere serveren vår, siden faktisk diskkapasiteten til arrayet allerede er tilgjengelig for oss.

ISCSI-målkonfigurasjon

For at diskkapasiteten til RAID-arrayet som er opprettet av oss skal presenteres for virtualiseringsverten over nettverket ved hjelp av iSCSI-protokollen, på ESOS-serveren må du opprette iSCSI-mål... For å gjøre dette, i navigasjonsmenyen, gå til Mål > Legg til iSCSI Target... I skjemaet for å lage et mål vil vi angi navnet iSCSI-kvalifisert navn (IQN).

I vårt tilfelle brukte vi standardnavnet i formatet iqn.2018-03.esos.<имя сервера>: Det eneste jeg endret i navnet var å fjerne kolon på slutten av navnet.

Når den er lagret, vil iSCSI Target-informasjonen vises på ESOS-hovedskjermen, men målet vil bli deaktivert.

For å aktivere målet, gå til navigasjonsmenyen i Mål > Muliggjøre/Deaktiver mål, fra listen over mål, velg målet vi nettopp opprettet og endre egenskapene Funksjonshemmet på Aktivert.

Sørg for at målstatusinformasjonen er endret på hovedskjermen for TUI.

Fra listen over kringkastingsmoduser for enheter, hvis beskrivelse finnes i dokumentet36_Devices_and_Mappings - SCST I/O-moduser , velg modusen av interesse for oss. I vårt eksempel brukes modusen vdisk_blockio som gir direkte tilgang til blokkering av enheter og eliminerer bruken av mellomliggende Linux-bufringsmekanismer.

Etter å ha valgt modus, åpnes et vindu for valg av blokkenheter som er mulige for denne modusen. Vi velger vårt RAID-array.

Etter det åpnes skjemaet for å konfigurere SCST-parametere for den virtuelle blokkeringsenheten. vdisk_blockio... Vi vil indikere ethvert kort og forståelig navn på enheten. Dette navnet vil bli vist videre på siden av virtualiseringsverten som fungerer som en iSCSI-initiator i enhetsbehandlingen. Derfor brukte jeg det forkortede verts- og RAID-enhetsnavnet for navnet - ESOS01-MD0. Resten av parameterne kan stå på standardverdiene.

Vi lagrer innstillingene til den virtuelle blokkeringsenheten og fortsetter med å beskrive vertene som har lov til å koble til iSCSI-målet vi opprettet. Men før vi kan beskrive vertene, må vi opprette en vertsgruppe. Gå til menyen Verter > Legg til gruppe

Velg iSCSI-målet vi opprettet tidligere, som den opprettede vertsgruppen vil tilhøre.

Angi et hvilket som helst vertsgruppenavn, for eksempel Group1, og klikk Tast inn

Så vertsgruppen er opprettet og tilordnet iSCSI-målet. Nå må vi beskrive hver vert som skal fungere som iSCSI-initiator med tilordningen av denne verten til den opprettede vertsgruppen. I vårt tilfelle vil det bare være én slik vert - vår virtualiseringsvert Hyper-V OS basert Windows Server 2012 R2.

Før du legger til initiatorverten til ESOS, finn ut navnet. Initiativtakers navn på vår virtualiseringsvert. Du kan finne (og, om ønskelig, endre) dette navnet i Windows Server Kontrollpanel ved å ringe appleten iSCSI-initiator og åpne fanen Konfigurasjon

Som du kan se, i vårt tilfelle er vertsnavnet til initiativtakeren iqn.1991-05.com.microsoft:kom-ad01-vm01.holding.com.

Gå tilbake til TUI ESOS og legg til initiatorverten i menyen Verter > Legg til initiativtaker

I dette tilfellet vil vi bli spurt hvilket SCST-mål den tilførte verten tilhører. Vi velger det eneste målet som vi tidligere har opprettet og inkludert.

Deretter velger vi den tidligere opprettede vertsgruppen som den tilføyde initiatorverten vil være bundet til.

Og til slutt, skriv inn IQN til initiativtaker-verten, som vi fant ut tidligere, og klikk Tast inn

Så på dette stadiet i ESOS har vi allerede et opprettet SCST-mål (i vårt tilfelle et iSCSI-mål), vi har en virtuell SCST-blokkenhet (en programvare RAID-array kringkastes), vi har beskrevet en gruppe verter og en initiatorvert (iSCSI Initiator) er bundet til denne gruppen ... Nå trenger vi bare å kartlegge den virtuelle SCST-blokkenheten til vertsgruppen. For å gjøre dette, gå til navigasjonsmenyen i Enheter > Kart til vertsgruppe.

Velg den virtuelle blokkeringsenheten SCST.

Velg den virtuelle blokkeringsenheten SCST.

Velg SCST-målet.

Velg vertsgruppen som initiativtakerverten ble inkludert i.

Deretter åpnes konfigurasjonsskjemaet LUN-a, som vil bli kringkastet til nettverket. Angi LUN-nummeret (som standard er den første kringkastings-LUN tildelt nummeret 0) og lagre innstillingene ved å klikke OK.

Du kan se den endelige konfigurasjonen av kringkastingen av virtuelle SCST-enheter ved å gå til menyen Enheter > LUN/Gruppeoppsett

La oss nå bestemme hvordan vi skal skille iSCSI-nettverkstrafikken fra ESOS-serveradministrasjonstrafikken. Vi vil gjøre det på en slik måte at vi fullstendig skiller disse typer trafikk på tvers av forskjellige nettverksgrensesnitt.

For å gjøre dette vil vi konfigurere på ESOS-serversiden og på iSCSI Initiator-klientsiden separate nettverksgrensesnitt med IP-adressering forskjellig fra adresseringen som brukes til serveradministrasjon. For eksempel, i vårt tilfelle, brukes 10.1.2.0/24-nettverket til å administrere serverne, og for å skille iSCSI-trafikk bruker vi derfor et lite dedikert subnett for 6 verter - 192.168.168.0/29 (på nettverksutstyrsnivå, du kan i tillegg isolere dette nettverket til et eget VLAN).

Først, la oss konfigurere et dedikert iSCSI-nettverksgrensesnitt på ESOS-serversiden ved å gå til navigasjonsmenyen under System > Nettverksinnstillinger og velge riktig nettverksadapter.

La oss angi den statiske IP-adressen 192.168.168.1/29 på dette grensesnittet, angi subnettmasken, kringkastingsadressen og økt størrelse MTU- 9000 (teknologi Jumbo ramme må støttes av nettverksadapteren) for å forbedre ytelsen ved overføring av store datamengder.

Når vi lagrer innstillingene, vil vi svare ja på spørsmålet om å starte nettverket på nytt (alle nettverksforbindelser med ESOS vil gå midlertidig tapt).

Etter å ha fullført prosedyren for omstart av nettverket, vil vi motta et sammendrag av statusen for bruk av de nye innstillingene.

La oss nå gå videre til oppsett på vertssiden for initiativtakeren.

ISCSI-initiatorkonfigurasjon

På siden av virtualiseringsverten vår basert på Windows Server, som vi vil motta diskkapasitet til fra ESOS-serveren via iSCSI-protokollen, vil vi konfigurere en dedikert nettverksadapter for bruk i arbeid med iSCSI-protokollen.

Deaktiver alt bortsett fra det vi trenger på dette dedikerte grensesnittet når du arbeider med iSCSI. La oss for eksempel bare la protokollstøtte være TCP/IPv4 og QoS.

Ved å velge en protokoll TCP/IPv4 med knappen Egenskaper angi IP-adressen fra nettverket som vi definerte for iSCSI-trafikk, for eksempel 192.168.168.3/29. La adressen til standard gateway og DNS-servere være tomme. Åpne avanserte innstillinger med knappen Avansert.

I fanen DNS deaktiver standard DNS-registreringsalternativet, og på VINNER deaktiver støtte LMHOST og NetBIOS over TCP/IP.

La oss gå tilbake til hovedfanen for egenskapene til nettverksgrensesnittet og kalle opp dialogen for å konfigurere parametrene til nettverkskortet ved å klikke Konfigurer.

I skjemaet som åpnes, på fanen avanserte innstillinger Avansert finn muligheten til å støtte store pakker Jumbo pakke og velg den maksimalt mulige verdien (i vårt eksempel er det 9014). I fanen Strømstyring deaktiver systemets evne til å deaktivere denne nettverksadapteren i strømsparingsmoduser - La datamaskinen slå av denne enheten for å lagre modus.

Lukk alle vinduer og lagre med knappen OK.

La oss nå sjekke tilgjengeligheten til ESOS-serveren gjennom det dedikerte nettverksgrensesnittet. Først med verktøyet tracert for å sikre at trafikken rutes direkte mellom servere.

tracert -d 192.168.168.1Bruk deretter verktøyet ping ved å aktivere flagget forby fragmentering (alternativ - f) og spesifisere størrelsen på overførte pakker (alternativ - l)

ping 192.168.168.1 -f -l 8000

I tilfelle at et sted, for eksempel på bryteren som ESOS-serverne og initiatorverten vår er koblet til, er støtte ikke aktivert Jumbo ramme, vi kan få meldinger" Pakken må være fragmentert, men DF-sett. "I vårt tilfelle var testen vellykket, så du kan fortsette til prosedyren for å koble til en iSCSI-disk.

La oss gå til Windows Server-kontrollpanelet, ring appleten iSCSI-initiator og åpne fanen Oppdagelse trykk på knappen Oppdag portalen... I vinduet for oppdagelsesinnstillinger, spesifiser IP-adressen til ESOS-serveren fra nettverket for iSCSI-trafikk og klikk på knappen Avansert.

I form av avanserte oppdagelsesinnstillinger, velg som lokal adapter Microsoft iSCSI-initiator og den tidligere konfigurerte IP-adressen fra nettverket for iSCSI-trafikk er 192.168.168.3. Lagre innstillingene ved å klikke OK til vi går tilbake til hovedappletvinduet.

Etter det, gå til fanen Mål hvor i seksjon Oppdaget mål den tidligere nevnte skal vises IQN vår ESOS-server med status Inaktiv... Det vil si at systemet oppdaget det, men det er ikke koblet til ennå. For å koble til iSCSI Target, bruk knappen Koble.

Etter det, gå til fanen Mål hvor i seksjon Oppdaget mål den tidligere nevnte skal vises IQN vår ESOS-server med status Inaktiv... Det vil si at systemet oppdaget det, men det er ikke koblet til ennå. For å koble til iSCSI Target, bruk knappen Koble.

I tilkoblingsvinduet som åpnes, vær oppmerksom på at tegnet for å legge til et tilkoblet mål til listen over favorittmål er aktivert - Legg til denne tilkoblingen til listen over Favorittmål(for påfølgende automatisk tilkobling til målet i tilfelle server omstart). trykk på knappen Avansert.

I form av avanserte tilkoblingsinnstillinger vil vi eksplisitt indikere nettverksgrensesnittene fra nettverket for iSCSI-trafikk, som skal brukes til å overføre iSCSI-trafikk for denne sesjonstilkoblingen. Det vil si som Initiativtaker IP velg fra listen adressen til iSCSI-grensesnittet som er tildelt på vår vert 192.168.168.3, og som Målportal-IP velg fra listen adressen til iSCSI-grensesnittet som er tildelt på ESOS-serveren - 192.168.168.1.

Lukk og lagre vinduet Avanserte innstillinger og Koble til målet og sørg for at tilkoblingsstatusen er endret til Tilkoblet

La oss se på fanen Favorittmål og sørg for at det tilkoblede målet er på favorittlisten.

Pass på at i "Enhetsbehandling" / Enhetsbehandling (devmgmt.msc) I kapittel Harddisker det er en ekstra SCSI-disk med navnet som vi tidligere definerte på ESOS-serveren for den virtuelle SCST-blokkenheten.

Det neste trinnet er å initialisere den iSCSI-tilkoblede disken. For å gjøre dette, gå til diskadministrasjonskonsollen Diskbehandling (diskmgmt.msc), velg den tilsvarende disken og bytt den til tilstanden på nett.

Etter at disken har endret status, vil vi initialisere disken og formatere den etter vår smak, for eksempel i NTFS-filsystemet, og sette en hvilken som helst volumetikett vi forstår. Fra nå av, i Windows grafiske grensesnitt, vil denne disken bli tilgjengelig for oss for standard filoperasjoner.

På dette stadiet, hvis vi ser inn i konsollen til ESOS-serveren, vil vi se informasjon om tilkoblingsøkten til den initierende verten nederst på TUI.

Dette fullfører det grunnleggende oppsettet med den enkleste iSCSI-konfigurasjonen.

Enkleste ytelsestest

Etter å ha koblet til disken via iSCSI, er det tilrådelig å utføre i det minste noen enkle ytelsesmålinger for å forstå hva vi fikk til slutt og hva som kan forventes av en slik disk.

Det er ikke verdt å stole på tallene som Windows Utforsker viser oss når du kopierer store filer fra den lokale disken på serveren til iSCSI-disken, siden vi ikke vil se objektiv informasjon der. For eksempel, i mitt tilfelle, når du kopierte flere store ISO-filer (med forskjellig innhold), ble hastigheten angitt i området 150-160 MB / s, noe som skiller seg betydelig fra den virkelige tillatte hastigheten til en iSCSI-kobling mellom mine to servere ved 1Gbit/s (~ 125MB/s). I tillegg vises hastigheten, mer eller mindre lik sannheten, når du kopierer den første filen, og når du kopierer påfølgende filer, øker den litt (kanskje filsystembufferen og andre andre cacher på forskjellige nivåer er inkludert i arbeidet) .

For alle slags målinger vil du alltid bruke noen "native" verktøy som ikke krever installasjon av tilleggsprogramvare, men dette er dessverre ikke alltid mulig. På Windows-klientsystemer brukes verktøyet til å evaluere ytelsen til forskjellige undersystemer, inkludert disken. WinSAT ( winsat disk ), men jeg fant ikke dette verktøyet i Windows Server 2012 R2. Derfor

Jeg kopierte to filer, WinSAT.exe og WinSATAPI.dll, fra Windows 10 x64-klient-OSet som jeg har for hånden, fra % windir% \ System32-katalogen til den samme katalogen på serveren. Nå kan du prøve å bruke dette verktøyet ved å kjøre det fra kommandolinjen med administratorrettigheter.

Her etter nøkkelordet disk alternativet –drive spesifiserer bokstaven til stasjonen vi ønsker å teste, og –count-alternativet spesifiserer antall testsykluser.

Slik jeg forstår det, tillater ikke dette verktøyet testing med store datablokker (mer enn 1 MB), det vil si at det er mer egnet for testsituasjoner med et stort antall små filer. I vårt tilfelle er situasjonen motsatt - sikkerhetskopiering av disker på virtuelle maskiner innebærer et lite antall filer av en betydelig størrelse.

Et annet enkelt verktøy er verktøyet Diskspd(DiskSpd: Et robust verktøy for lagringsytelse ), som erstattet verktøyetSQLIO Disk Subsystem Benchmark Tool (SQLIO) ... Vi laster ned verktøyet, pakker det ut på serveren og kjører det med et sett med parametere som tilsvarer konteksten for oppgaven vår.

cd / d C: \ Verktøy \ Diskspd-v2.0.17 \ amd64fre \ Diskspd.exe -d60 -b1M -s -w100 -t1 -c100G T: \ io1.dat T: \ io2.datParametrene vi bruker betyr:

-d60: Testutførelsestid 60 sekunder

-b1M: Operer i 1MB blokker

-s: Utfør sekvensielle tilgangsoperasjoner

-w100: Gjør en full skrivetest (ingen lesetest)

-t1: Antall tråder med arbeid med målet (med filen T: \ io.dat)

-c100G: Lag 100 GB filer

På slutten vises navnene på filene som er generert for testen.

Litt avvikende merker jeg at vi i skrivende stund bruker programvare for oppgaven med å sikkerhetskopiere Hyper-V virtuelle maskiner Veeam Backup & Replikering Derfor, når jeg velger en blokkstørrelse for å utføre tester, vil jeg gå ut fra spesifikasjonene til denne programvaren. Som jeg forsto av dokumentetDatakomprimering og deduplisering , VBR bruker 1024MB blokker i sikkerhetskopieringsoperasjoner på SAN, og dette er blokkstørrelsen vi skal bruke for testing.

For sammenligning, la oss kjøre testen på nytt med det samme settet med betingelser, men øke varigheten til 5 minutter.

Det er tydelig her at under langvarig belastning, synker indikatorene merkbart. Jeg kan anta at dette skyldes det faktum at flaskehalsen i dette tilfellet beveger seg fra området av nettverksundersystemet til området med trege disker som brukes på vår ESOS-serverside.

For fans av grafiske verktøy kan et annet enkelt gratisverktøy være nyttig for å utføre slike overfladiske tester av ytelsen til diskundersystemet på Windows. ATTO Disk Benchmark... Du kan laste den ned fra lenken: Diskbenchmark ... Grensesnittet til verktøyet er enkelt og greit, og det er sannsynligvis ingenting å kommentere.

Om noen mer komplekse testverktøy, som f.eks IOmeter , jeg sier ikke, siden det innenfor rammen av vår oppgave ikke er noe mål å forholde seg til benchmarks som sådan. Og indikatorene for enkle verktøy oppnås bare for å ha et sammenligningsgrunnlag i fremtiden, når mellom ESOS-serveren og Hyper-V-verten vil vi ikke ha en kobling, som på dette stadiet av konfigurasjonen, men to koblinger og den involverte flerveismekanismen.

Konfigurere Multipath

Så vi har en disk koblet til via iSCSI og noen grunnleggende standarder for ytelsestester, som vi kan bygge videre på. La oss nå prøve å forbedre disse indikatorene ved å legge til en gigabit-nettverksadapter til til ESOS-serveren og initiatorverten og kombinere arbeidet deres ved å bruke Multipath-mekanismen på initiatorvertssiden.

La oss starte med å konfigurere ESOS-serveren. I hovednavigasjonsmenyen, gå til System > Nettverksinnstillinger, velg en ekstra nettverksadapter som skal brukes for en iSCSI-tilkobling til og konfigurer IP-parameterne. I vårt eksempel brukes en statisk konfigurasjon og det ekstra ESOS iSCSI-grensesnittet er satt til IP-adressen 192.168.168.2/29, og størrelsen økes i tillegg MTU.

Vi lagrer nettverksinnstillingene i ESOS og fortsetter med å konfigurere en ekstra nettverksadapter på siden av initiatorverten, det vil si serveren vår basert på Windows Server med iSCSI Initiator.

Vi konfigurerer, analogt med det første, det andre iSCSI-grensesnittet, og setter det til IP 192.168.168.4/29

Deaktiver det tidligere konfigurerte grensesnittet med adressen 192.168.168.3 (iSCSI-disken vil falle av) og sørg for at de ekstra konfigurerte iSCSI-grensesnittene til ESOS-serveren og initiatorverten kan se hverandre.

I kontrollpanel-appleten iSCSI-initiator i fanen Oppdagelse legg til en ekstra deteksjonsbane, spesifiser en haug med 192.168.168.2 - 192.168.168.4

Siden tidligere opprettet vi en iSCSI-tilkobling til målet uten det aktiverte flagget flerveis, så nå ville det være mer riktig for oss å deaktivere denne forbindelsen og opprette den på nytt, men med det aktiverte flagget flerveis.

Fjern først den tidligere opprettede tilkoblingen fra oppstart på fanen Favorittmål

La oss nå gå til fanen Mål og koble fra (disken, initialisert og tilkoblet i iSCSI-systemet, vil forsvinne fra Windows)

Deretter kobler vi til iSCSI-målet igjen, men denne gangen med alternativet aktivert Aktiver multi-path(og ikke glem knappen Avansert lag en eksplisitt haug med grensesnitt 192.168.168.1 - 192.168.168.3 )

Etter å ha sørget for at målet har kommet inn i tilstanden igjen Tilkobletåpne egenskapene for å legge til en ekstra tilkobling på et ekstra dedikert grensesnitt

I fanen Mål la oss gå til knappen Egenskaper til egenskapene til det tilkoblede målet, og bruk knappen Legg til økt for å sette opp en annen tilkobling.

Forresten, her ved knappen MCS vi vil være i stand til å sikre at den første etablerte økten faktisk bruker det dedikerte nettverksgrensesnittet vi spesifiserte.

Så ved å bruke knappen Legg til økt legg til en ekstra tilkobling til iSCSI Target og spesifiserer som grensesnitt et ekstra par med grensesnitt som vi konfigurerte tidligere (192.168.168.2 - 192.168.168.4 )

Nå skal en post om den andre økten vises i listen over økter.

Vi vil også se den opprettede tilleggsøkten på ESOS-serversiden.

På siden av initiativtaker-verten, la oss se på "Enhetsbehandling"-snap-in / Enhetsbehandling (devmgmt.msc) og sørg for at i delen Harddisker en ekstra SCSI-disk med samme navn (ESOS01-MD0) har dukket opp.

Det vil si at nå, på Windows-serversiden, ser vi faktisk den samme disken som to separate enheter. For at systemet skal kunne jobbe med denne disken som en enkelt enhet, ved å bruke begge iSCSI-nettverkskoblingene til ESOS-serveren, må vi aktivere støtte MPIO til iSCSI... For å gjøre dette, gå til Windows Kontrollpanel, åpne appleten MPIO og i fanen Oppdag Multi-Paths slå på alternativet Legg til støtte for iSCSI-enheter... Etter det trykker vi på knappen Legge til og vi svarer bekreftende på spørsmålet om å starte serveren på nytt.

Etter omstart, la oss se på Enhetsbehandling-konsollen igjen og sørge for at iSCSI-disken vår nå vises som en enkelt enhet og har et navn ... Multi-Path Disk Device... La oss åpne egenskapene til disken og på fanen MPIO sjekk at disken er tilgjengelig på to måter.

Mer detaljert informasjon om tilkoblingsruter kan sees i kontrollpanelets applet iSCSI-initiator.

Her ved knappen MPIO vi vil se informasjon om tilkoblingene som brukes.

Dette fullfører det grunnleggende oppsettet av Multipath.

Nå, for å evaluere endringene i hastigheten på arbeidet med en iSCSI-disk, som vi mottok som et resultat av organisering av den andre lenken og oppsett av Multipath, vil vi gjennomføre en enkel test av lineær skriving av store filer til disk, ved å analogi med det vi gjorde tidligere:

Diskspd.exe -d60 -b1M -s -w100 -t1 -c100G T: \ io1.dat T: \ io2.dat

Etter hva Diskspd viser oss i dette tilfellet, ble hver fil i gjennomsnitt skrevet med en hastighet på ~225MB/s, som er lik 1800Mb/s. Det vil si at vi som et resultat får en hastighet nær den totale gjennomstrømningen til to organiserte iSCSI-lenker.

Samme test, men lengre i tid (5 minutter):

Diskspd.exe -d300 -b1M -s -w100 -t1 -c100G T: \ io1.dat T: \ io2.dat

Gjennomsnittsverdien på ~ 48,5 MB / s, oppnådd når du arbeider med hver fil, ser betydelig bedre ut enn de tidligere oppnådde 16 MB / s på en enkelt iSCSI-kobling.

Basert på disse enkle målingene kan vi forstå at takket være organiseringen av Multipath-forbindelsen, økte vi ikke bare tilgjengeligheten, men fikk også forbedrede ytelsesindikatorer. Og dette er bra.

ESOS USB Flash Hot Swap

Tatt i betraktning at når vi setter sammen budsjettløsningen beskrevet i rammen av vårt eksempel, kan vi bruke billige USB-stasjoner, i noen tilfeller kan det være nødvendig å erstatte denne stasjonen (for eksempel hvis den feiler). Tatt i betraktning at ESOS er et Linux-system som er fullt tilpasset for å fungere i RAM, er det en veldig enkel operasjon å erstatte en USB-stasjon, hvis korrekt behandling implementeres av utvikleren av dette systemet.

Faktisk erstattes stasjonen i noen få enkle trinn:

- På et allerede lastet og kjørende ESOS-system kan du når som helst fjerne USB-stasjonen (stasjonen som må byttes) som dette systemet ble startet opp fra.

- Vi klargjør en ny ESOS USB-pinne ved å bruke standardmetoden beskrevet i avsnittet "Forberede en oppstartbar ESOS USB-pinne" ovenfor, og installerer denne pinnen i en kjørende ESOS-server.

- Vi kaller prosedyren for å synkronisere ESOS-konfigurasjonen som kjører i RAM med filsystemet på USB-stasjonen. Menyelement System > Synkroniseringskonfigurasjon

Etter det er det tilrådelig å starte serveren på nytt og sørge for at systemet starter opp fra den nye USB-stasjonen. Under den første oppstarten fra den erstattede USB-stasjonen, vil ESOS utføre noen serviceprosedyrer, og i løpet av noen få minutter vil serveren være klar til å fungere, etter å ha lastet inn konfigurasjonen vi konfigurerte tidligere.

Etter beskrivelsen av dokumentet å dømme 13_Oppgradering ESOS-serveren oppgraderes til en nyere versjon på nøyaktig samme enkle måte, noe som i stor grad forenkler vedlikeholdet av et slikt system.

Konklusjon

Avslutningsvis vil jeg si at i vårt eksempel, takket være ESOS-systemet, klarte vi å presse maksimalt ut av diskkurven til en utdatert server på alle måter og få på virtualiseringsverten en diskkapasitet som er ganske tolerabel i ytelse for oppgaven med å sikkerhetskopiere virtuelle maskiner. Og jeg kan bare takke ESOS-utvikleren for arbeidet som er gjort og ønske prosjektet videre vellykket utvikling.

Sammendrag: hvordan open-iscsi (ISCSI-initiator i linux) fungerer, hvordan den konfigureres, og litt om selve ISCSI-protokollen.

Tekster: Det er mange artikler på Internett som forklarer ganske godt hvordan man setter opp et ISCSI-mål, men av en eller annen grunn er det praktisk talt ingen artikler om å jobbe med en initiativtaker. Til tross for at mål er teknisk mer komplisert, er det mer administrativt bråk med initiativtakeren – det er mer forvirrende begreper og lite åpenbare arbeidsprinsipper.

ISCSI

Før vi snakker om iSCSI - noen få ord om forskjellige typer ekstern tilgang til informasjon i moderne nettverk.NAS vs SAN

Det er to metoder for å få tilgang til data på en annen datamaskin: fil (når en fil blir forespurt fra en ekstern datamaskin, og ingen bryr seg om hvilke filsystemer det gjøres), typiske representanter for NFS, CIFS (SMB); og blokk - når blokker blir forespurt fra en ekstern datamaskin fra diskmedier (ligner på hvordan de leses fra en harddisk). I dette tilfellet lager den anmodende part et filsystem på blokkenheten for seg selv, og serveren som gir blokkenheten vet ikke om filsystemene på den. Den første metoden kalles NAS (nettverksbasert lagring), og den andre kalles SAN (lagringsområdenettverk). Navnene indikerer generelt andre tegn (SAN betyr et dedikert nettverk før lagring), men det hendte at NAS er filer og SAN er blokkenheter over nettverket. Og selv om alle (?) forstår at dette er feil navn, jo lenger, jo mer blir de fikset.scsi over tcp

En av protokollene for tilgang til blokkenheter er iscsi. Bokstaven "i" i tittelen refererer ikke til Apple-produkter, men til Internet Explorer. I kjernen er det "scsi over tcp". Selve SCSI-protokollen (uten bokstaven "i") er en veldig kompleks design, siden den kan fungere gjennom forskjellige fysiske medier (for eksempel er UWSCSI en parallellbuss, SAS er en seriell buss - men de har samme protokoll). Denne protokollen lar deg gjøre mye mer enn bare å "plugge disker til datamaskinen" (som oppfunnet i SATA), for eksempel støtter den enhetsnavn, tilstedeværelsen av flere koblinger mellom blokkenheten og forbrukeren, støtte for bytte (ja , en SAS-svitsj, slik er i naturen), kobler flere forbrukere til en blokkenhet, etc. Med andre ord, denne protokollen ble rett og slett bedt om som grunnlag for en nettverksblokkeringsenhet.Terminologi

Følgende vilkår er tatt i bruk i SCSI-verdenen:mål er den som leverer blokkenheten. Den nærmeste analogen fra den vanlige dataverdenen er en server.

initiativtaker- klienten, den som bruker blokkeringsenheten. Analog av klienten.

Wwid- Unik identifikator for enheten, dens navn. En analog av et DNS-navn.

LUN- nummeret på "stykket" av disken som er tilgjengelig. Den nærmeste analogen er en partisjon på en harddisk.

ISCSI bringer følgende endringer: WWID forsvinner, i stedet kommer konseptet IQN (iSCSI Qualified Name) - det vil si et rent navn som ligner graden av forveksling med DNS (med mindre forskjeller). Her er et eksempel på IQN: iqn.2011-09.test: navn.

IETD og open-iscsi (Linux-server og klient) bringer et annet veldig viktig konsept som oftest ikke er skrevet om i iscsi-manualene - portalen. Portal er, grovt sett, flere mål som annonseres av én server. Det er ingen analogi med www, men hvis en webserver kan bli bedt om å liste opp alle virtuelle verter, ville det vært det. Portal spesifiserer en liste over mål og tilgjengelige IP-er som kan nås (ja, iscsi støtter flere ruter fra initiativtaker til mål).

mål

Denne artikkelen handler ikke om mål, så jeg gir en veldig kort beskrivelse av hva mål gjør. Han tar en blokkeringsenhet, legger navnet og LUN til den og publiserer den på portalen sin, hvoretter han lar alle (godkjenning til å smake) få tilgang til den.Her er et eksempel på en enkel konfigurasjonsfil, jeg tror det vil fremgå tydelig av den hva målet gjør (en konfigurasjonsfil som bruker IET-eksemplet):

Mål iqn.2011-09.example: data IncomingUser brukernavn Pa $$ w0rd Lun 0 Path = / dev / md1

(komplekst skiller seg fra enkel bare i eksportalternativer). Derfor, hvis vi har et mål, vil vi koble det sammen. Og det er her den vanskelige delen begynner, fordi initiativtakeren har sin egen logikk, den ser slett ikke ut som en triviell montering for nfs.

Initiativtaker

Open-iscsi brukes som initiativtaker. Så det viktigste er at han har det driftsmoduser og tilstand... Hvis vi utsteder en kommando i feil modus eller ignorerer tilstanden, vil resultatet være ekstremt nedslående.Så, driftsmodusene:

- Søkemål (oppdagelse)

- Koble til målet "y

- Arbeide med et tilkoblet mål

Litt om staten. Etter oppdagelsen åpen-iscsi husker alle funnet mål (de er lagret i / etc / iscsi /), med andre ord, oppdagelse er en permanent operasjon, IKKE i det hele tatt hensiktsmessig, for eksempel dns-løsning. Funnet mål kan fjernes for hånd (forresten en vanlig feil er når open-iscsi , som et resultat av eksperimenter og innstillinger, en haug med funnet mål "er, når du prøver å logge på som mange feil kryper ut på grunn av det faktum at halvparten av målet" er gamle konfigurasjoner linjer som ikke har eksistert på serveren på lenge, men jeg husker open-iscsi) Dessuten lar open-iscsi deg endre innstillingene til det huskede målet "a" - og dette "minnet" påvirker videre arbeid med målet "s selv etter at daemonen er omstartet/startet på nytt.

Blokker enhet

Det andre spørsmålet som plager mange til å begynne med, er hvor ender det opp etter tilkobling? open-iscsi oppretter, men en nettverkstilkoblet, men BLOKKERT SCSI-klasseenhet (det er ikke for ingenting jeg sier det), det vil si at den får en bokstav i / dev / sd-familien, for eksempel / dev / sdc. Den første fribokstaven brukes, fordi for resten av systemet er dette en blokkenhet - en typisk harddisk, ikke forskjellig fra den som er koblet til via usb-sata eller bare direkte til sata.Dette utløser ofte "hvordan kan jeg finne ut navnet på blokkeringsenheten?" Panikk. Den skrives ut i den detaljerte utgangen til iscsiadm (# iscsiadm -m session -P 3).

Autorisasjon

I motsetning til SAS / UWSCSI, er iSCSI tilgjengelig for alle å koble til. For å beskytte mot slike, er det en pålogging og passord (kapittel), og deres overføring til iscsiadm "y er en annen hodepine for nybegynnere. Det kan gjøres på to måter - ved å endre egenskapene til det tidligere funnet målet" og registrere pålogging / passord i konfigurasjonsfilen open-iscsi.Årsaken til denne vanskeligheten er at passordet og påloggingsprosessen ikke er attributter til brukeren, men til systemet. ISCSI er en lavkostversjon av FC-infrastrukturen, og begrepet "bruker" i sammenheng med en person ved tastaturet gjelder ikke her. Hvis sql-basen din er på iscsi-blokkenheten, vil du selvfølgelig at sql-serveren skal starte seg selv, og ikke etter et minutt med operatørens personlige oppmerksomhet.

konfigurasjonsfil

Dette er en veldig viktig fil, fordi den i tillegg til påloggingen/passordet også beskriver oppførselen til open-iscsi når den finner feil. Det kan gi en feil "tilbake" ikke umiddelbart, men med en pause (for eksempel omtrent fem minutter, som er nok til å starte serveren på nytt med data). Den kontrollerer også påloggingsprosessen (hvor mange ganger du skal prøve, hvor lenge du skal vente mellom forsøkene) og eventuell finjustering av selve arbeidsprosessen. Vær oppmerksom på at disse parameterne er ganske viktige for arbeid, og du må forstå hvordan iscsi-en din vil oppføre seg hvis du fjerner strømledningen i 10-20 sekunder, for eksempel.Rask referanse

Jeg liker egentlig ikke å sitere lett funnet mana og linjer, så jeg vil gi et typisk scenario for bruk av iscsi:Først finner vi målet vi trenger, for dette må vi vite IP / dns-navnet til initiativtakeren: iscsiadm -m discovery -t st -p 192.168.0.1 -t st er kommandoen send targets.

Iscsiadm -m node (liste funnet for pålogging)

iscsiadm -m node -l -T iqn.2011-09.eksempel: data (pålogging, det vil si koble til og opprette en blokkenhet).

iscsiadm -m sesjon (liste hva som er koblet til)

iscsiadm -m session -P3 (gi den ut, men mer detaljert - helt på slutten av utgangen vil det være en indikasjon på hvilken blokkenhet som tilhører hvilket mål).

iscsiadm - m session -u -T iqn.2011-09.example: data (logg ut av en spesifikk en)

iscsiadm -m node -l (logg inn på alle oppdagede mål)

iscsiadm -m node -u (logg ut av alle mål)

iscsiadm -m node --op delete -T iqn.2011-09.eksempel: data (fjern mål fra funnet).

multisti

En annen sak som er viktig i seriøse beslutninger er støtten til flere ruter til kilden. Det fine med iscsi er at den bruker en vanlig ip, som kan behandles på vanlig måte, som all annen trafikk (selv om den i praksis vanligvis ikke rutes, men bare byttes - lasten er for tung der). Så iscsi støtter multipath i "no resist"-modus. I seg selv kan ikke open-iscsi koble til flere IP-er av ett mål "a. Hvis det er koblet til flere IP-er for ett mål" a, vil dette føre til at flere blokkenheter vises.Det finnes imidlertid en løsning - dette er multipathd, som finner disker med samme identifikator og behandler dem som forventet i multipath, med tilpassbare retningslinjer. Denne artikkelen handler ikke om multipath, så jeg vil ikke forklare mysteriet med prosessen i detalj, men her er noen viktige punkter:

- Når du bruker multipath, sett små tidsavbrudd - veksling mellom dårlige baner bør være raskt nok

- Under forhold med en mer eller mindre rask kanal (10G og høyere, i mange tilfeller gigabit), bør belastningsparallellisme unngås, siden muligheten til å bruke biokoalesing går tapt, som i noen typer belastning kan treffe målet "y.