Hallo! Dagens innlegg handler om det såre punktet for de fleste nybegynnere nettstedbyggere. Jeg måtte svare på det samme spørsmålet veldig ofte i kommentarene - hvordan fjerne sider fra søk som ble indeksert tidligere, men på grunn av de nåværende omstendighetene ble slettet og ikke lenger eksisterer, men som fortsatt er i indeksen til søkemotorer. Eller det er sider i søket som er forbudt å indeksere.

I kommentarene vil du ikke utvide for mye, derfor, etter neste spørsmål, bestemte jeg meg for å være spesielt oppmerksom på dette emnet. La oss først finne ut hvordan slike sider kan vises i søket. Jeg vil gi eksempler basert på egen erfaring, så hvis jeg glemmer noe ber jeg deg supplere.

Hvorfor er lukkede og slettede sider i søket

Det kan være flere årsaker, og jeg skal prøve å trekke frem noen av dem i form av en liten liste med forklaringer. Før jeg starter vil jeg gi en forklaring på hva jeg mener med "ekstra" (lukkede) sider: tjeneste eller andre sider som er forbudt å indeksere etter regler eller en meta-tag.

Ikke-eksisterende sider søkes av følgende årsaker:

- Det vanligste er at siden er slettet og ikke lenger eksisterer.

- Manuell redigering av adressen til en nettside, som et resultat av at et dokument som allerede er i søket blir utilgjengelig for visning. Spesiell oppmerksomhet bør rettes mot dette punktet for nybegynnere som på grunn av sin lille kunnskap avviser ressursens funksjon.

- Fortsetter tanken om strukturen, la meg minne deg på at som standard, etter å ha installert WordPress på en hosting, oppfyller den ikke kravene til intern optimalisering og består av alfanumeriske identifikatorer. Det faller på CNC, mens mange ikke-fungerende adresser vises, som vil forbli i indeksen til søkemotorer i lang tid. Bruk derfor den grunnleggende regelen: hvis du bestemmer deg for å endre strukturen, bruk en 301-viderekobling fra gamle adresser til nye. Det ideelle alternativet er å fullføre alle sideinnstillingene FØR du åpner den, en lokal server kan være nyttig for dette.

- Serverdrift er ikke riktig konfigurert. En ikke-eksisterende side skal returnere en feilkode på 404 eller med en 3xx-kode.

Ekstra sider vises i indeksen under følgende forhold:

- Sidene ser ut til å være lukket, men faktisk er de åpne for søkeroboter og søkes uten restriksjoner (eller robots.txt er ikke stavet riktig). For å sjekke PS tilgangsrettigheter til sider, bruk de riktige verktøyene for.

- De ble indeksert før de ble lukket på tilgjengelige måter.

- Disse sidene er koblet fra andre nettsteder eller interne sider innenfor samme domene.

Så vi fant ut årsakene. Det er verdt å merke seg at etter å ha eliminert årsaken, kan ikke-eksisterende eller ekstra sider forbli i søkebasen i lang tid - alt avhenger av frekvensen eller frekvensen av robotens besøk på nettstedet.

Hvordan fjerne en side fra Yandex søkemotor

Til fjern URL fra Yandex bare følg lenken og skriv inn adressen til siden du vil fjerne fra søkeresultatene i tekstfeltet i skjemaet.

Hovedbetingelsen for en vellykket sletteforespørsel:

- siden må være stengt fra indeksering av robotregler eller en noindex-metatag på denne siden - hvis siden eksisterer, men ikke skal delta i søket;

- når du prøver å få tilgang til en side, skal serveren returnere en 404-feil - hvis siden er slettet og ikke lenger eksisterer.

Neste gang roboten gjennomsøker nettstedet, vil sletteforespørslene bli utført og sidene forsvinner fra søkeresultatene.

Hvordan fjerne en side fra Googles søkemotor

For å fjerne sider fra, gjør vi det samme. Åpne Verktøy for nettredaktører og finn Fjern URL-er i rullegardinlisten for optimalisering og følg koblingen.

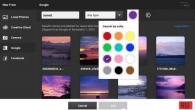

Foran oss er et spesielt skjema som vi oppretter en ny forespørsel om sletting med:

Klikk fortsett og følg de videre instruksjonene, velg årsaken til slettingen. Etter min mening er ikke ordet "grunn" helt egnet for dette, men det er ikke poenget ...

Av alternativene som presenteres, har vi tilgjengelig:

- sletting av en sideside fra Googles søkeresultater og fra søkemotorens hurtigbuffer;

- sletter bare siden fra hurtigbufferen;

- slette en katalog med alle adresser inkludert i den.

En veldig praktisk funksjon for å slette en hel katalog når du må slette flere sider om gangen, for eksempel fra én kategori. Du kan overvåke statusen til sletteforespørselen på samme side av verktøyene med muligheten til å avbryte. For en vellykket sletter sider fra google det stilles samme vilkår som for. Forespørselen fullføres vanligvis på kort tid, og siden forsvinner fra søkeresultatene umiddelbart.

Når det gjelder utlasting av indekserte sider, har Yandex endelig gjort det som måtte gjøres.

Og nå har vi fått et veldig godt verktøy som du kan få veldig interessant informasjon med.

I dag vil jeg fortelle deg om denne informasjonen, og du kan bruke den til å markedsføre nettstedene dine.

Gå til Yandex.Webmaster, i delen "Indeksering"

Og her er et bilde foran deg (klikk for å forstørre):

Disse dataene fra de ekskluderte sidene gir oss mye informasjon.

Vel, la oss starte med omdirigering:

Vanligvis er en omdirigering ikke full av problemer. Dette er den tekniske komponenten av nettstedets arbeid.

Dette er en vanlig versjon av siden. Jeg vil ikke si at dette ikke er så kritisk. Det er bare det at Yandex på to sider anså den andre siden for å være mer relevant.

Og Yandex skrev til og med en kommentar: Siden dupliserer siden http: // site /? P = 390 som allerede er presentert i søket. Angi den foretrukne adressen for roboten ved å bruke en 301-omdirigering eller rel = "canonical"-attributtet.

Dette kan brukes på følgende måte: Noen ganger flyr sidene på nettstedet du markedsfører ut og omvendt kommer inn i indeksen til duplikatene deres. I dette tilfellet trenger du bare å registrere den kanoniske url-en på begge disse sidene på den du promoterer.

Deretter legger du til begge disse sidene i "Omgå roboten på nytt".

Dette er siden i metataggene som den kanoniske url-en til ønsket side er registrert til.

Alt er bra her, og dette er den normale prosessen på nettstedet.

Yandex skriver også et hint her: Siden er indeksert på den kanoniske URL-adressen http: // site /? P = 1705, som ble spesifisert i rel = "canonical"-attributtet i kildekoden. Korriger eller fjern det kanoniske attributtet hvis det er feil. Roboten vil spore endringene automatisk.

Dette skjer vanligvis når du har slettet noen sider, men ikke angitt omdirigeringen. Eller 404-feil ble ikke levert.

Dette gjør ingen skade for nettstedspromotering.

Vel, det kommer til det mest interessante. Siden med utilstrekkelig kvalitet.

De. sidene på nettstedet vårt tok av fra Yandex-indeksen fordi de ikke er av høy kvalitet.

Dette er selvfølgelig det viktigste signalet til nettstedet ditt om at du har globale problemer med disse sidene.

Men ikke alt er så enkelt som det ser ut til.

Ofte er dette sider med paginering, søk eller annet søppel. Og disse sidene er korrekt ekskludert fra indeksen.

Men noen ganger hender det at produktkort på nettbutikker er ekskludert fra indeksen. Og de er ekskludert i tusenvis. Og dette betyr utvilsomt at det er noen alvorlige problemer med produktkortsidene dine.

Jeg har sett gjennom mange nettbutikker i løpet av en uke og nesten alle har lignende. Dessuten blir siden ut observert i titusenvis.

Det kan være slike problemer at vi har flere identiske sider hvor produktet rett og slett har en annen farge. Og Yandex mener at dette er én side.

I dette tilfellet kan du enten lage én side med et valg av farger på én side eller endre andre sider.

Men det er selvfølgelig verdt å si at dette er en GLOBAL hjelp for alle nettbutikkeiere. De gjorde det klart for deg hvilke sider som har fløyet bort og hvorfor.

Her må du jobbe med kvaliteten på disse sidene. Kanskje disse sidene dupliserer andre, men kanskje ikke.

Noen ganger mangler rett og slett tekst på slike sider. Og på noen er det ingen pris, og Yandex fjerner slike sider fra indeksen.

Og jeg la også merke til at hvis statusen "Produktet er utsolgt" vises på produktkortsiden, fjernes denne siden også fra Yandex-indeksen.

Generelt, så jobb.

Jeg vil fortelle deg om andre interessante triks på mandag på seminaret mitt -

Og mer. Mange kjenner denne trablaen med Yandex.Advisor:

De. du betalte for et klikk fra Direct, og Yandex.Advisor tar din betalte klient til Yandex.Market.

Dette er faktisk en alvorlig sak.

Slik jeg forstår det, vil ikke Yandex endre noe.

Ok, da endrer jeg det selv.

Denne Yandex.Advisor gjelder først og fremst nettbutikker. Og nettbutikker er først og fremst basert på motorer: Bitrix, Joomla, Webasyst.

Så for disse motorene skriver jeg en rådgiverblokkering. De. når du installerer denne plugin-en på motoren din, vil ikke Yandex.Advisor fungere på nettstedet ditt.

Til alle som kommer til seminaret mitt, jeg vil senere kaste disse pluginene gratis.

Jeg har valgt de mest populære motorene som de er installert på. Dette er ikke nødvendig for tjenestesider. Men for DEM er det det.

Hvis du har spørsmål, så still spørsmål.

Hei venner! Jeg håper du hadde en god hvile i maiferien: du løp ut i naturen, spiste grillmat og gikk rundt i den blomstrende naturen. Nå må vi tilbake til aktivt arbeid =).

I dag vil jeg vise resultatene av ett lite eksperiment for å fjerne alle nettstedssider fra Yandex og Googles søkemotorer. Dens konklusjoner vil hjelpe når du velger en av metodene for å forby indeksering av hele ressursen eller dens individuelle deler.

Jeg sto overfor oppgaven med å stenge nettstedet for indeksering uten å miste funksjonaliteten. Det vil si at ressursen skal fungere, men fjernes fra indeksen til søkemotorer. Selvfølgelig er den sikreste måten å ganske enkelt slette prosjektet fra hostingen. Dokumentene vil returnere en 404-feil og til slutt "forlate" fra søkemotordatabasen. Men oppgaven min var annerledes.

- finne ut hvilken metode for å forby indeksering som er mer prioritert for søkemotorer;

- observere dynamikken til hastigheten;

- faktisk slett prosjekter fra PS-databasene.

Eksperimentet involverte 2 steder (alle over et år). For det første: det er 3000 sider i Yandex-indeksen, Google - 2090. For det andre: Yandex - 734, Google - 733. Hvis du ikke fjerner ressursen fra hostingen, gjenstår 2 populære alternativer: metanavnet = "robots"-taggen og forbudet i robots.txt.

For det første nettstedet ble det lagt til en linje på hver side:

For det andre ble følgende robots.txt kompilert:

Bruker agent: *

Disallow: /

Eksperimentet startet 14. desember og pågikk til 9. mai. Dataene ble tatt omtrent for datoene for Yandex-oppdateringer.

resultater

Nedenfor er grafene over dynamikken til antall indekserte sider. Første nettsted # 1 (metode for å fjerne metanavn = "robots" tag).

Som du kan se, oppførte søkemotorene seg i omtrent samme scenario. Men det er også forskjeller. I Yandex ble ressursen fullstendig slettet 10. februar, da det fortsatt var 224 sider igjen i Google. Hva kan jeg si, etter 5 måneder er det fortsatt 2 dusin dokumenter igjen. Google er veldig følsom for indekserte sider og ønsker ikke å gi slipp på dem.

Nettsted nr. 2 (filforbudsmetode - robots.txt).

Her utviklet situasjonen seg mer interessant. Yandex raskt nok (på mindre enn en måned) slettet alle sider. Google, derimot, kastet ut rundt 100 dokumenter fra indeksen i løpet av en måned, så ytterligere 200 en måned senere og nærmest frøs på plass.

4. april ble jeg lei av å vente og endret forbudsmetoden fra robots.txt til metanavn = "roboter". Det lønnet seg – etter en måned var det bare 160 sider igjen i Google-databasen. Omtrent det samme antallet er fortsatt i dag.

Et poeng til er bemerkelsesverdig. Til tross for at sidene ble fjernet fra indeksen i lang tid, begynte trafikken fra søkemotorene å falle mye raskere.

Det viser seg at PS forstår at nettredaktøren har forbudt ressursen eller dens dokumenter for indeksering, men av en eller annen grunn fortsetter de å holde dem der.

konklusjoner

- Yandex elsker å jobbe med robots.txt mer;

- Google elsker å jobbe med metanavn = "roboter" mer. På grunn av det faktum at Google ikke liker robots.txt så mye, vil metoden med taggen være universell. Du kan ikke kombinere metoder, fordi ved å ikke tillate en ressurs i robots.txt, vil søkeedderkoppen ikke kunne lese reglene for metanavn = "roboter".

- Runet Mirror fjerner dokumenter raskt nok med en hvilken som helst metode. En utenlandsk søkemotor gjør dette motvillig - det er svært vanskelig å oppnå fullstendig fjerning fra databasen.

Her er et lite eksperiment. Ja, selvfølgelig, utvalget er veldig lite, men det var også i stand til å bekrefte mine antakelser. I applikasjonsmessige termer kan dette brukes når det er behov for å lukke visse dokumenter for indeksering: det er å foretrekke å bruke metanavn = "roboter" i stedet for direktiver i robots.txt.

Hvilke observasjoner har du om dette emnet? Del opplevelsen din i kommentarene!

Hvordan fjerne en side fra indeksen til søkemotorer, og generelt hvorfor er det nødvendig? I denne artikkelen vil vi gå gjennom alle alternativene og svare på vanlige spørsmål.

Hvorfor fjerne side(r) fra indeksen?Det kan være mange grunner til å fjerne en eller flere sider fra indeksen. De vanligste er:

- Siden er et duplikat (for eksempel kan sidene site.ru/cat/stranica.html og site.ru/cat/stranica være duplikater). Og som alle vet, er duplikater i indeksen onde som skader nettstedet som helhet.

- Siden har sluttet å eksistere (informasjonen er for eksempel ikke lenger relevant).

Hastigheten på fjerning avhenger ikke av oss. Den maksimale perioden er ca. 60..90 dager. Etter min erfaring er den gjennomsnittlige fjerningsperioden i området 25..35 dager. Hvis vi indikerer manuelt gjennom Yandex Webmaster- eller Google Webmaster-panelet at siden må slettes, vil prosessen gå raskere. Det viktigste her er at søkeroboten besøker den forbudte siden på nettstedet, og så, når indeksen er oppdatert, vil den ekskludere den fra søkeresultatene.

Måter å fjerne en side fra indeksen

I alternativene som er diskutert nedenfor, vil siden eksistere (den vil være åpen for brukere), men vi vil forby den (slette den) i søkemotorindeksen.

1. Gjennom metakoden

Det er praktisk å blokkere sider fra å indeksere ved å bruke robots.txt fordi du umiddelbart kan spesifisere hele delen i bulk eller forby indeksering av en gruppe sider av samme type. Søkemotorer sier imidlertid tydelig at robotfilen ikke er obligatorisk for dem når det gjelder utførelse. De. søkemotoren kan i teorien legge igjen et dokument i indeksen som er lukket i roboter. Riktignok kjenner jeg ikke til slike eksempler.

3. Gjennom panelet til webansvarlig for søkemotorer

Både i Yandex og Google i webmasters panel er det en slik mulighet. Men hvis du sletter siden på denne måten, må du forstå at siden først må lukkes ved å bruke en av metodene ovenfor, ellers vil ingenting skje. Med en slik sletting antyder vi bare for søkeroboter at de definitivt må gå til disse sidene i neste gjennomgang.

3.1. Yandex webansvarlig panel

Sidens adresse er http://webmaster.yandex.ru/delurl.xml. Etter å ha kommet inn på denne siden, trenger du bare å angi i skjemaet adressen til siden du vil fjerne fra indeksen.

3.2. Google Webmaster Panel

Sideadresse - https://www.google.com/webmasters/tools/... For å komme til det nødvendige skjemaet, velg et nettsted fra listen (hvis du har flere nettsteder) og velg deretter fanen "Google Index" -> "Fjern URLer".

I Google kan du umiddelbart registrere en katalog med URL-er (akkurat som i robots.txt).

4. X-Robots-Tag-overskrifter

Denne metoden brukes kun av Google. Forbudsoppføringen må være i http-overskriftene:

X-Robots-Tag: noindex, nofollow

5. Gjennom en omdirigering eller 404-feil

Du kan også fjerne en side fra indeksen ved å bruke en omdirigering eller returnere en 404-feil fra siden. I et slikt tilfelle vil søkemotorene også fjerne sidene fra indeksen.

Vi har dekket de viktigste måtene å fjerne en side fra indeksen. Som jeg skrev ovenfor, er fjerningshastigheten forskjellig i hvert tilfelle. Men en ting er sikkert – det er ikke raskt. Uansett vil det ta minst 5-7 dager.

Nesten alle nettredaktører, spesielt i den innledende fasen av å lage et prosjekt, møtte behovet for å fjerne nettsider fra søkemotorindeksen. Selv til tross for at prosedyren ved første øyekast er ganske enkel, har mange fortsatt problemer.

Noen ganger må eieren av en nettressurs skjule et dokument fra søkemotorer av følgende årsaker:

- nettstedet er under konstruksjon og kom inn i SERP ganske ved et uhell;

- innholdet på siden er ikke lenger relevant;

- dokumentet dupliserer en annen side som allerede er på nettstedet;

- indeksen inkluderer tjenestesider der personopplysningene til klientene er plassert.

For å unngå slike tilfeller vil vi i dag snakke om 4 effektive måter å fjerne en side fra indeksen til søkemotorer.

Hvordan lukker jeg en side fra søkemotorer ved å bruke panelet for nettredaktører?

Denne metoden for å blokkere tilgang til sidene på nettstedet ditt for søkeroboter regnes som en av de enkleste. Dessuten er dette verktøyet ideelt for de tilfeller der visse nettadresser må fjernes snarest.

Yandex

For å gjøre dette trenger du Yandex.Webmaster-tjenesten. Vi har fortalt deg hvordan du legger til et nettsted på dette nettstedet for å øke hastigheten på indekseringen. Følg lenken https://webmaster.yandex.ru/tools/del-url/ og legg til adressen til en bestemt side i det tilsvarende feltet, og klikk deretter på "Slett".

Med en høy grad av sannsynlighet vil Yandex be deg om å fremskynde prosessen med å slette en side fra systemdatabasen. For å gjøre dette, må du først lukke den fra roboter gjennom en fil eller en robots-meta-tag, eller få serveren til å returnere en 404-feil. Vi vil snakke om hvordan du gjør dette litt senere.

Det vil ta flere timer eller til og med dager før robotene sletter dokumentet fra databasen. Dette skyldes det faktum at systemet må spore statusen og sørge for at den ikke endres lenger.

Logg inn på siden Googles verktøy for nettredaktører... Legg til nettstedet ditt i indeksen først hvis du ikke allerede har gjort det. Finn så fanen "Google Index" der, og under den "Fjern nettadresser". I vinduet som vises, velg alternativet for å opprette en sletteforespørsel, og skriv inn adressen til dokumentet som skal slettes i feltet. Send deretter inn forespørselen din.

Server 404 feil

Hver bruker som lette etter den nødvendige informasjonen på Internett, havnet sikkert på siden der han ga feil 404 - "Side ikke funnet"... Dette betyr at dokumentet du lette etter ble fjernet fra ressursen.

Nettredaktøren kan for eksempel gjøre dette i nettstedets kontrollpanel. For søkemotorer betyr dette at du konfigurerer svarserveren til denne siden slik at koden vises på en bestemt adresse 404 ikkefunnet... Og når roboten besøker den gitte URL-en igjen, vil serveren informere ham om at siden ikke lenger eksisterer. Dette gjør det klart for søkemotorer at dokumentet er fjernet fra siden, og de vil fjerne det fra søkeresultatene slik at besøkende ikke går til det og leser 404-feilen.

De karakteristiske egenskapene til denne metoden inkluderer:

- Enkelt oppsett med bare noen få klikk.

- Fullstendig forsvinning av dokumentet fra nettressursen. På grunn av dette anbefales det ikke å bruke denne metoden i tilfelle en tjenesteside (konfidensiell informasjon om klienter, etc.) må fjernes fra indeksen.

- Det er også verdt å ty til et annet alternativ for å skjule siden, for eksempel en 301-viderekobling hvis innkommende koblinger fører til den.

Viktig! Siden faller ut av søkeindeksen, ikke på grunn av at den er fjernet fra ressursen, men på grunn av ytterligere reindeksering. Derfor, for å fjerne den, må du vente ca. 2 uker til roboten besøker ressursen igjen.

For webansvarlige er denne metoden en av de mest praktiske, men den besøkende liker kanskje ikke 404-feilen, og det er en risiko for at brukeren som ser den, slutter å besøke nettstedet. Men det er en vei ut av denne situasjonen også.

På en lapp. Svært ofte er nettstedbyggere engasjert i en interessant utforming av siden der 404-feilen ikke ble funnet tar av. De legger ut nyttig informasjon der og tilbyr å besøke andre sider av ressursen, noe som helt sikkert vil tiltrekke seg oppmerksomheten til den besøkende. Dette vil gjøre denne siden mer attraktiv for brukeren, noe som helt sikkert vil ha en positiv effekt på hans rangering og anerkjennelse.

Endring av robots.txt-filen

En annen vanlig metode som brukes av webansvarlige. Den lar deg skjule individuelle dokumenter og hele seksjoner. I robotfilen din kan du ikke bare nekte, men også la søkeroboter indeksere et nettsted eller bestemte sider. Slike kommandoer leveres av Disallow-direktivet.

For å skjule en side fra søkemotorer, må du få tilgang til rotmappen til nettstedet. Robots.txt-dokumentet inneholder i hovedsak 2 linjer:

- Bruker-middel. Navnet på roboten til en bestemt søkemotor, som du forbyr å gjennomsøke siden, er angitt her, eller en kode er skrevet Bruker agent: *, gjelder for alle roboter samtidig.

- Ikke tillat. URL-en til siden som skal slettes er skrevet her.

Sammen lager de en kommando til søkemotorer for den angitte nettadressen. Om nødvendig kan du skjule flere dokumenter på én ressurs i én fil samtidig, og de vil ikke påvirke hverandre på noen måte.

Dette er for eksempel hvordan vi forteller alle søkeroboter om ikke å indeksere indeks- og passordsidene på nettsiden vår.

User-agent: * Disallow: / index Disallow: / passord

Når du skriver denne kommandoen, må du vente på neste indeksering. Du bør vite at alle endringer i robotfilen er veiledende for søkemotorer, så ikke bli overrasket om objektet fortsatt forblir i indeksen, men er merket for å være skjult gjennom robots.txt. Men hvis statusen til dokumentet ikke endres etter en viss tid, vil det fortsatt bli slettet fra søkemotordatabasen.

Viktig! Hvis det er eksterne lenker på de eksterne sidene, vil de forbli tilgjengelige for å klikke på dem. Dette skyldes det faktum at kommandoene i robotfilen faktisk ikke fjerner objektet fra søkeresultatene, men bare skjuler det fra resultatene.

Robots Meta Tag

Hvis du ikke går inn på detaljer, er denne metoden lik den ovenfor, bare alle kommandoer er skrevet i html-koden til nettstedet inne i head-taggene:

Alle endringer vil også bli gjort etter indeksering. Fordelen med å bruke metarobot-taggen er at du kan fjerne flere nettadresser fra søket ved å bruke den uten å måtte endre robotene. Denne metoden er ideell for nybegynnere nettstedbyggere som gradvis oppretter nye sider.

Det er også et flott alternativ når du trenger å lukke en side fra Yandex-indeksen, men samtidig holde den tilgjengelig på Google. Eller når du vil fjerne et objekt fra søket, men la informasjonen være tilgjengelig på selve siden.

Et eksempel på lukking av en URL kun for Yandex:

Viktig!Å skrive metakoder skiller seg fra å endre robots.txt ved at du kan bruke dem til å fjerne et objekt fra søk, selv om eksterne lenker fører til det. Dette tilrettelegges av noindex-metakoden. Men hvis nettstedet ditt ikke er bygget på WordPress, vil prosedyren være mer komplisert. Faktum er at WP har en spesiell Yoast SEO-plugin som lar deg slette sider med metakoder.

Konklusjon

Hvis du plutselig trenger å fjerne en bestemt side på nettstedet ditt fra søkeindeksen, kan du enkelt bruke alle metodene som er angitt i denne artikkelen. Velg den som er mer praktisk for deg, men ta samtidig hensyn til de karakteristiske egenskapene til hver av dem. Generelt, hvis du vil lukke dokumentet så snart som mulig, bruk flere alternativer samtidig.