Здравейте! Днешната публикация е за болезнената точка за повечето начинаещи създатели на сайтове. Трябваше да отговарям на един и същ въпрос много често в коментарите - как да премахнете страници от търсенекоито бяха индексирани по-рано, но поради текущите обстоятелства бяха изтрити и вече не съществуват, но все още са в индекса на търсачките. Или има страници в търсенето, които са забранени за индексиране.

В коментарите няма да разширявате твърде много, затова след следващия въпрос реших да обърна специално внимание на тази тема. Първо, нека да разберем как могат да се появят такива страници в търсенето. Ще дам примери въз основа на собствения си опит, така че ако забравя нещо, моля да го допълните.

Защо се затварят и изтриват страници в търсенето

Причините може да са няколко и аз ще се опитам да подчертая някои от тях под формата на малък списък с обяснения. Преди да започна, ще дам обяснение какво имам предвид под "екстра" (затворени) страници: услуги или други страници, които са забранени за индексиране от правила или мета-таг.

Несъществуващи страници се търсят по следните причини:

- Най-често срещаното е, че страницата е изтрита и вече не съществува.

- Ръчно редактиране на адреса на уеб страница, в резултат на което документ, който вече е в търсене, става недостъпен за разглеждане. Особено внимание трябва да се обърне на този момент за начинаещи, които поради малкото си познания пренебрегват функционирането на ресурса.

- Продължавайки мисълта за структурата, нека ви напомня, че по подразбиране, след инсталиране на WordPress на хостинг, той не отговаря на изискванията за вътрешна оптимизация и се състои от буквено-цифрови идентификатори. Той пада върху CNC, докато се появяват много неработещи адреси, които ще останат в индекса на търсачките за дълго време. Затова приложете основното правило: ако решите да промените структурата, използвайте пренасочване 301 от стари адреси към нови. Идеалният вариант е да завършите всички настройки на сайта ПРЕДИ да го отворите, локален сървър може да ви бъде полезен за това.

- Работата на сървъра не е конфигурирана правилно. Несъществуваща страница трябва да върне код за грешка 404 или с код 3xx.

Допълнителни страници се появяват в индекса при следните условия:

- Страниците изглеждат затворени, но всъщност са отворени за роботи за търсене и се търсят без ограничения (или robots.txt не е изписан правилно). За да проверите правата на PS за достъп до страници, използвайте съответните инструменти за.

- Те бяха индексирани, преди да бъдат затворени по достъпни начини.

- Тези страници са свързани от други сайтове или вътрешни страници в рамките на същия домейн.

И така, разбрахме причините. Струва си да се отбележи, че след отстраняване на причината несъществуващи или допълнителни страници могат да останат в базата за търсене за дълго време - всичко зависи от честотата или честотата на посещение на робота на сайта.

Как да премахнете страница от търсачката Yandex

За премахване на URL от Yandexпросто следвайте връзката и в текстовото поле на формуляра поставете адреса на страницата, която искате да премахнете от резултатите от търсенето.

Основното условие за успешна заявка за изтриване:

- страницата трябва да бъде затворена от индексиране от правилата на роботите или мета-таг без индекс на тази страница - ако страницата съществува, но не трябва да участва в търсенето;

- при опит за достъп до страница сървърът трябва да върне грешка 404 - ако страницата е изтрита и вече не съществува.

Следващия път, когато роботът обходи сайта, заявките за изтриване ще бъдат изпълнени и страниците ще изчезнат от резултатите от търсенето.

Как да премахнете страница от търсачката на Google

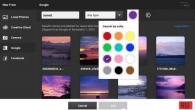

За да премахнем страници от, ние правим същото. Отворете Инструменти за уеб администратори и намерете Премахване на URL адреси в падащия списък Оптимизация и следвайте връзката.

Пред нас е специална форма, с която създаваме нова заявка за изтриване:

Щракнете върху Продължи и следвайки допълнителните инструкции, изберете причината за изтриването. Според мен думата "причина" не е съвсем подходяща за това, но не това е въпросът ...

От представените опции имаме на разположение:

- изтриване на страница на страница от резултатите от търсенето с Google и от кеша на търсачката;

- изтриване само на страницата от кеша;

- изтриване на директория с всички адреси, включени в нея.

Много удобна функция за изтриване на цял каталог, когато трябва да изтриете няколко страници наведнъж, например от една категория. Можете да наблюдавате състоянието на заявката за изтриване на същата страница на инструментите с опция за отмяна. За успешен изтриване на страници от googleса необходими същите условия като за. Заявката обикновено се изпълнява за нула време и страницата изчезва незабавно от резултатите от търсенето.

По отношение на разтоварването на индексирани страници, Yandex най-накрая направи това, което трябваше да се направи.

И сега имаме много добър инструмент, с който можете да получите много интересна информация.

Днес ще ви разкажа за тази информация и можете да я приложите за популяризиране на вашите сайтове.

Отидете на Yandex.Webmaster в секцията "Индексиране"

И ето снимка пред вас (щракнете за уголемяване):

Тези данни на изключените страници ни дават много информация.

Е, нека започнем с пренасочване:

Обикновено пренасочването не е изпълнено с никакви проблеми. Това е техническият компонент от работата на сайта.

Това е нормален преглед на страницата. Не бих казал, че това не е толкова критично. Просто Yandex от две страници смята, че втората страница е по-подходяща.

И Yandex дори написа коментар: Страницата дублира страницата http: // сайт /? P = 390, която вече е представена в търсенето. Посочете предпочитания адрес за робота, като използвате пренасочване 301 или атрибута rel = "canonical".

Това може да се използва по следния начин: Понякога страниците на сайта, който рекламирате, излитат и обратното попадат в индекса на техните дубликати. В този случай просто трябва да регистрирате каноничния URL адрес на двете страници на тази, която популяризирате.

След това добавете и двете страници към „Повторно заобикаляне на робота“.

Това е страницата, в мета таговете, на която е регистриран каноничният url към желаната страница.

Тук всичко е наред и това е нормалният процес на сайта.

Yandex също пише намек тук: Страницата е индексирана на каноничния URL адрес http: // site /? P = 1705, който е посочен в атрибута rel = "canonical" в изходния код. Коригирайте или премахнете каноничния атрибут, ако е неправилен. Роботът ще проследи промените автоматично.

Това обикновено се случва, когато сте изтрили някои страници, но не сте задали пренасочването. Или грешка 404 не е била доставена.

Това не вреди на промоцията на уебсайта.

Е, стига се до най-интересното. Страница с недостатъчно качество.

Тези. страниците на нашия сайт излязоха от индекса на Yandex, защото не са с високо качество.

Разбира се, това е най-важният сигнал към вашия сайт, че имате глобални проблеми с тези страници.

Но не всичко е толкова просто, колкото изглежда.

Често това са страници с пагинация, търсене или друг боклук. И тези страници са правилно изключени от индекса.

Но понякога се случва картите с продукти в онлайн магазина да бъдат изключени от индекса. И те са изключени от хиляди. А това несъмнено означава, че има някои сериозни проблеми със страниците на вашите продуктови карти.

Разгледах много онлайн магазини за една седмица и почти всички имат подобни. Освен това изходът на страницата се наблюдава в десетки хиляди.

Възможно е да има такива проблеми, че да имаме няколко еднакви страници, където продуктът е просто с различен цвят. И Yandex вярва, че това е една страница.

В този случай тук или направете една страница с избор на цветове на една страница, или модифицирайте други страници.

Но, разбира се, си струва да се каже, че това е ГЛОБАЛНА помощ за всички собственици на онлайн магазини. Изясниха ви кои страници са отлетяли и защо.

Тук трябва да работите върху качеството на тези страници. Може би тези страници дублират други, но може би не.

Понякога текстът просто липсва на такива страници. А на някои няма цена и Yandex премахва такива страници от индекса.

И също така забелязах, че ако състоянието „Продуктът е изчерпан“ се показва на страницата на продуктовата карта, тогава тази страница също се премахва от индекса на Yandex.

Като цяло, тогава работа.

За други интересни трикове ще ви разкажа в понеделник на моя семинар -

И още. Много хора знаят тази трабла с Yandex.Advisor:

Тези. сте платили за щракване от Direct и Yandex.Advisor отвежда платения ви клиент към Yandex.Market.

Това всъщност е потресаващ случай.

Както разбирам, Yandex няма да промени нищо.

Добре, тогава сам ще го сменя.

Този Yandex.Advisor засяга предимно онлайн магазини. А онлайн магазините се основават предимно на двигатели: Bitrix, Joomla, Webasyst.

Така че за тези двигатели пиша блокер на съветници. Тези. когато инсталирате този плъгин на вашия двигател, Yandex.Advisor няма да работи на вашия сайт.

За всеки, който дойде на моя семинар, по-късно ще изхвърля тези плъгини безплатно.

Избрах най-популярните двигатели, на които са инсталирани. Това не е необходимо за сервизни сайтове. Но за ТЯХ това е.

Ако имате въпроси, тогава задавайте въпроси.

Здравейте приятели! Надявам се, че сте си починали чудесно през майските празници: тичахте сред природата, хапнахте барбекю и се разхождахте из цъфтящата природа. Сега трябва да се върнем към активната работа =).

Днес ще покажа резултатите от един малък експеримент за премахване на всички страници на сайта от търсачките Yandex и Google. Неговите заключения ще помогнат при избора на един от методите за забрана на индексирането на целия ресурс или на отделните му части.

Бях изправен пред задачата да затворя сайта за индексиране, без да губя функционалността му. Тоест ресурсът трябва да работи, но да бъде премахнат от индекса на търсачките. Разбира се, най-сигурният начин е просто да изтриете проекта от хостинга. Документите ще върнат грешка 404 и в крайна сметка ще "напуснат" от базата данни на търсачката. Но задачата ми беше друга.

- определя кой метод за забрана на индексирането е по-приоритетен за търсачките;

- наблюдавайте динамиката на скоростта;

- всъщност изтрийте проекти от базите данни на PS.

Експериментът включваше 2 обекта (всички за една година). Първо: в индекса на Yandex има 3000 страници, Google - 2090. Второ: Yandex - 734, Google - 733. Ако не премахнете ресурса от хостинга, остават 2 популярни опции: мета име = маркер "robots" и забраната в robots.txt.

За първия сайт беше добавен ред на всяка страница:

За втория беше компилиран следният robots.txt:

Потребителски агент: *

Забрани: /

Експериментът стартира на 14 декември и продължи до 9 май. Данните са взети приблизително за датите на актуализации на Yandex.

резултати

По-долу са дадени графиките на динамиката на броя на индексираните страници. Първи сайт № 1 (метод за премахване на мета име = таг "robots").

Както можете да видите, търсачките се държаха приблизително по същия сценарий. Но има и разлики. В Yandex ресурсът беше напълно изтрит на 10 февруари, когато в Google все още бяха останали 224 страници. Какво да кажа, след 5 месеца остават още 2 дузини документи. Google е много чувствителен към индексираните страници и не иска да ги пусне.

Сайт № 2 (метод за забрана на файлове - robots.txt).

Тук ситуацията се разви по-интересно. Yandex достатъчно бързо (за по-малко от месец) изтри всички страници. Google, от друга страна, изхвърли около 100 документа от индекса за един месец, след това още 200 след месец и на практика замръзна на място.

На 4 април ми писна да чакам и промених метода за забрана от robots.txt на meta name = "robots". Изплати се - след месец в базата данни на Google останаха само 160 страници. Приблизително същият брой остава и до днес.

Още един момент е забележителен. Въпреки факта, че страниците бяха премахнати от индекса за дълго време, трафикът от търсачките започна да пада много по-бързо.

Оказва се, че PS разбира, че уебмастърът е забранил ресурса или неговите документи за индексиране, но по някаква причина продължават да ги държат там.

заключения

- Yandex обича повече да работи с robots.txt;

- Google обича повече да работи с meta name = "роботи". Поради факта, че Google не харесва много robots.txt, методът с тага ще бъде универсален. Не можете да комбинирате методи, защото като забраните ресурс в robots.txt, паякът за търсене няма да може да прочете правилата за meta name = "robots".

- Runet Mirror премахва документи достатъчно бързо, като използва всеки метод. Чуждестранна търсачка прави това неохотно - много е трудно да се постигне пълно премахване от базата данни.

Ето един малък експеримент. Да, разбира се, извадката е много малка, но също така успя да потвърди предположенията ми. От гледна точка на приложението, това може да се използва, когато има нужда от затваряне на определени документи за индексиране: за предпочитане е да се използва meta name = "robots" вместо директиви в robots.txt.

Какви наблюдения имате по тази тема? Споделете своя опит в коментарите!

Как да премахнете страница от индекса на търсачките и като цяло защо е необходимо? В тази статия ще разгледаме всички опции и ще отговорим на често задавани въпроси.

Защо да премахнете страница(и) от индекса?Може да има много причини за премахване на страница или страници от индекса. Най-често срещаните са:

- Страницата е дубликат (например страниците site.ru/cat/stranica.html и site.ru/cat/stranica могат да бъдат дублирани). И както всички знаят, дубликатите в индекса са зло, което вреди на сайта като цяло.

- Страницата е престанала да съществува (например информацията вече не е от значение).

Скоростта на отстраняване не зависи от нас. Максималният период е около 60..90 дни. Според моя опит средният период на премахване е около 25..35 дни. Ако посочим ръчно чрез панела Yandex Webmaster или Google Webmaster, че страницата трябва да бъде изтрита, тогава процесът ще бъде по-бърз. Най-важното тук е роботът за търсене да посети забранената страница на сайта и след това, когато индексът се актуализира, ще го изключи от резултатите от търсенето.

Начини за премахване на страница от индекса

В опциите, обсъдени по-долу, страницата ще съществува (ще бъде отворена за потребители), но ще я забраним (изтрием) в индекса на търсачката.

1. Чрез мета тага

Удобно е да блокирате индексирането на страници с помощта на robots.txt, тъй като можете незабавно да посочите целия раздел в насипно състояние или да забраните индексирането на група от страници от същия тип. Търсачките обаче ясно казват, че файлът robots не е задължителен за тях по отношение на изпълнение. Тези. търсачката на теория може да остави документ в индекса, който е затворен в роботите. Вярно е, че не познавам такива примери.

3. Чрез панела на уебмастъра на търсачките

И в Yandex, и в Google в панела на уеб администратора има такава възможност. Ако обаче изтриете страницата по този начин, тогава трябва да разберете, че страницата трябва първо да бъде затворена с помощта на един от горните методи, в противен случай нищо няма да се случи. С такова изтриване ние само намекваме на търсещите роботи, че те определено трябва да отидат на тези страници при следващото обхождане.

3.1. Панел за уеб администратори на Yandex

Адресът на страницата е http://webmaster.yandex.ru/delurl.xml. След като влезете в тази страница, просто трябва да посочите във формуляра адреса на страницата, която искате да премахнете от индекса.

3.2. Панел за уеб администратори на Google

Адрес на страницата - https://www.google.com/webmasters/tools/... За да стигнете до необходимия формуляр, изберете сайт от списъка (ако имате няколко сайта) и след това изберете раздела „Google Index“ -> „Премахване на URL адреси“.

В Google можете веднага да регистрирате директория с URL адреси (точно както в robots.txt).

4. X-Robots-Tag Headers

Този метод се използва само от Google. Записът за забрана трябва да е в http заглавките:

X-Robots-Tag: noindex, nofollow

5. Чрез пренасочване или 404 грешка

Можете също да премахнете страница от индекса, като използвате пренасочване или да върнете грешка 404 от страницата. В такъв случай търсачките също ще премахнат страниците от индекса.

Разгледахме основните начини за премахване на страница от индекса. Както писах по-горе, скоростта на премахване е различна във всеки отделен случай. Но едно е сигурно – не е бързо. Във всеки случай ще отнеме поне 5-7 дни.

Почти всеки уеб администратор, особено в началния етап на създаване на проект, се сблъска с необходимостта да премахне страниците на уебсайта от индекса на търсачката. Въпреки факта, че процедурата на пръв поглед е доста проста, много от тях все още имат трудности.

Понякога собственикът на уеб ресурс трябва да скрие документ от търсачките поради следните причини:

- сайтът е в процес на изграждане и попадна в SERP съвсем случайно;

- съдържанието на страницата вече не е уместно;

- документът дублира друга страница, която вече е на сайта;

- индексът включва сервизни страници, където се намират личните данни на клиентите.

За да избегнем подобни случаи, днес ще говорим за 4 ефективни начина за премахване на страница от индекса на търсачките.

Как да затворите страница от търсачките с помощта на панела на уеб администратора?

Този метод за блокиране на достъпа до страниците на вашия сайт за роботи за търсене се счита за един от най-лесните. Освен това този инструмент е идеален за случаите, когато определени URL адреси трябва да бъдат премахнати спешно.

Yandex

За да направите това, имате нужда от услугата Yandex.Webmaster. Казахме ви как да добавите сайт към този сайт, за да ускорите индексирането. Следвайте връзката https://webmaster.yandex.ru/tools/del-url/ и добавете адреса на конкретна страница в съответното поле, след което щракнете върху „Изтриване“.

С голяма степен на вероятност Yandex ще ви помоли да ускорите процеса на изтриване на страница от системната база данни. За да направите това, първо трябва да го затворите от ботове чрез файл или мета-таг на robots или да накарате сървъра да върне грешка 404. Ще говорим как да направите това малко по-късно.

Ще отнеме няколко часа или дори дни, преди ботовете да изтрият документа от базата данни. Това се дължи на факта, че системата ще трябва да проследи състоянието си и да се увери, че вече не се променя.

Влезте в сайта Google Webmaster Tools... Първо добавете сайта си към индекса, ако още не сте го направили. След това намерете там раздела „Google Index“ и под него „Премахване на URL адреси“. В прозореца, който се показва, изберете опцията за създаване на заявка за изтриване и въведете в полето адреса на документа, който ще изтриете. След това изпратете вашата заявка.

Грешка на сървъра 404

Със сигурност всеки потребител, търсейки необходимата информация в Интернет, се озовава на страницата, която е дал грешка 404 - "Страницата не е намерена"... Това означава, че търсеният от вас документ е премахнат от ресурса.

Уеб администраторът може да направи това в контролния панел на сайта, например. За търсачките това означава, че конфигурирате сървъра за отговор на тази страница, така че кодът да се показва на конкретен адрес 404 ненамерени... И когато роботът посети отново дадения URL, сървърът ще го информира, че страницата вече не съществува. Това дава да се разбере на търсачките, че документът е премахнат от сайта и те ще го премахнат от резултатите от търсенето, така че посетителите да не отидат до него и да прочетат грешката 404.

Характерните особености на този метод включват:

- Лесна настройка само с няколко щраквания.

- Пълно изчезване на документа от уеб ресурса. Поради това не се препоръчва използването на този метод в случаите, когато страница за услуга (поверителна информация на клиенти и др.) трябва да бъде премахната от индекса.

- Също така си струва да се прибегне до друга опция за скриване на страницата, например 301 пренасочване, ако входящите връзки водят до нея.

Важно!Страницата изпада от индекса за търсене не поради премахването й от ресурса, а поради по-нататъшно преиндексиране. Следователно, за да го премахнете, ще трябва да изчакате около 2 седмици, докато ботът отново посети ресурса.

За уеб администраторите този метод е един от най-удобните, но грешката 404 може да не хареса на посетителя и има риск потребителят, като го види, да спре да посещава сайта. Но и от тази ситуация има изход.

На бележка.Много често създателите на сайтове се занимават с интересен дизайн на страницата, на която излита грешката 404 not found. Те публикуват полезна информация там и предлагат да посетят други страници на ресурса, което със сигурност ще привлече вниманието на посетителя. Това ще направи тази страница по-привлекателна за потребителя, което със сигурност ще има положителен ефект върху неговото класиране и разпознаване.

Промяна на файла robots.txt

Друг често срещан метод, използван от уеб администраторите. Позволява ви да скриете отделни документи и цели раздели. Във вашия файл robots можете не само да откажете, но и да разрешите на ботове за търсене да индексират сайт или определени страници. Такива команди се предоставят с помощта на директивата Disallow.

За да скриете страница от търсачките, трябва да получите достъп до главната папка на сайта. Документът robots.txt съдържа основно 2 реда:

- потребител-агент.Тук е посочено името на робота на конкретна търсачка, която забранявате да обхожда страницата или е написан код Потребителски агент: *, приложим за всички ботове наведнъж.

- Забрани.Тук е изписан URL адресът на страницата, която трябва да бъде изтрита.

Заедно те създават команда към търсачките за посочения URL. Ако е необходимо, можете да скриете няколко документа на един ресурс в един файл наведнъж и те няма да се отразят един на друг по никакъв начин.

Например, така казваме на всички роботи за търсене да не индексират страниците с индекс и парола на нашия уебсайт.

Потребителски агент: * Disallow: / index Disallow: / парола

Когато пишете тази команда, ще трябва да изчакате следващото индексиране. Трябва да знаете, че всички промени във файла robots имат препоръчителен характер за търсачките, така че не се изненадвайте, ако обектът все още остане в индекса, но е маркиран като скрит чрез robots.txt. Но ако след определен период от време статусът на документа не се промени, той пак ще бъде изтрит от базата данни на търсачката.

Важно!Ако има външни връзки на отдалечените страници, те ще останат достъпни за щракване върху тях. Това се дължи на факта, че командите във файла robots всъщност не премахват обекта от резултатите от търсенето, а само го скриват от резултатите.

Мета етикет за роботи

Ако не навлизате в подробности, тогава този метод е подобен на горния, само всички команди са записани в html-кода на сайта вътре в таговете head:

Всички промени също ще бъдат направени след индексиране. Предимството на използването на маркера meta robots е, че можете да премахнете няколко URL адреса от вашето търсене, като го използвате, без да се налага да променяте роботите. Този метод е идеален за начинаещи създатели на сайтове, които постепенно създават нови страници.

Също така е чудесен вариант, когато трябва да затворите страница от индекса на Yandex, но в същото време да я запазите достъпна в Google. Или когато искате да премахнете обект от търсенето, но да оставите информацията налична в самия сайт.

Пример за затваряне на URL адрес само за Yandex:

Важно!Писането на мета тагове се различава от промяната на robots.txt по това, че можете да ги използвате, за да премахнете обект от търсене, дори ако външни връзки водят до него. Това се улеснява от мета тага noindex. Въпреки това, ако вашият сайт не е изграден на WordPress, тогава процедурата ще бъде по-сложна. Факт е, че WP има специален плъгин Yoast SEO, който ви позволява да изтривате страници с мета тагове.

Заключение

Ако внезапно се наложи да премахнете конкретна страница от вашия сайт от индекса за търсене, можете лесно да използвате всички методи, посочени в тази статия. Изберете този, който е по-удобен за вас, но в същото време вземете предвид характерните особености на всеки от тях. Като цяло, ако искате да затворите документа възможно най-скоро, използвайте няколко опции наведнъж.